天翼云通用型S6、计算增强型C6 等新一代云主机上提供超高网络性能,您可通过本实践提供的 netperf 和 DPDK 两种网络性能测试方法,进行云主机高吞吐网络性能测试。

推荐选择 netperf 方法进行测试,netperf 为通常使用的测试方法,可满足大多数测试场景。但当云主机配置较高(pps 超过1000万且带宽大于50Gbps)时,netperf包含云主机机内核协议栈的完整处理路径对网络性能损耗较大,而 DPDK 可屏蔽虚拟机内核协议栈的差异,获取虚拟机网卡的网络性能,此时可选择 DPDK 方法进行测试。

netperf测试

工具介绍

Netperf

HP 开发的网络性能测量工具,主要测试 TCP 及 UDP 吞吐量性能。测试结果主要反应系统向其他系统发送数据的速度,以及其他系统接收数据的速度。

SAR

用于监控网络流量,运行示例如下:

sar -n DEV 1 02:41:03 PM IFACE rxpck/s txpck/s rxkB/s txkB/s rxcmp/s txcmp/s rxmcst/s 02:41:04 PM eth0 1626689.00 8.00 68308.62 1.65 0.00 0.00 0.0002:41:04 PM lo 0.00 0.00 0.00 0.00 0.00 0.00 0.0002:41:04 PM IFACE rxpck/s txpck/s rxkB/s txkB/s rxcmp/s txcmp/s rxmcst/s 02:41:05 PM eth0 1599900.00 1.00 67183.30 0.10 0.00 0.00 0.0002:41:05 PM lo 0.00 0.00 0.00 0.00 0.00 0.00 0.00sar -n DEV 1:该命令每秒钟报告一次网络设备的性能统计信息

字段解释

| 字段 | 单位 | 说明 |

|---|---|---|

| rxpck/s | pps | 每秒收包量,即接收 pps |

| txpck/s | pps | 每秒发包量,即发送 pps |

| rxkB/s | kB/s | 接收带宽 |

| txkB/s | kB/s | 发送带宽 |

测试场景

| 测试场景 | 客户端运行命令 | SAR 监控指标 |

|---|---|---|

| UDP 64 | netperf -t UDP_STREAM -H-l 10000 -- -m 64 -R 1 & | PPS |

| TCP 1500 | netperf -t TCP_STREAM -H-l 10000 -- -m 1500 -R 1 & | 带宽 |

| TCP RR | netperf -t TCP_RR -H-l 10000 -- -r 32,128 -R 1 & | PPS |

命令说明:

netperf: 这是 Netperf 工具的命令,用于执行网络性能测试。

-t UDP_STREAM/TCP_STREAM: 指定测试的类型为 UDP/TCP 流量测试。

-H: 指定远程主机的地址。在这里,-H 后面应该跟上远程主机的地址或主机名。

-l : 指定测试的时间限制,后接时间,单位为秒。

-m : 设置消息大小,单位为字节。

-R : 指定测试运行的数量 。

&: 将测试命令放入后台运行。

性能指标

| 指标 | 说明 |

|---|---|

| 64字节 UDP 收发 PPS(包/秒) | 表示通过 UDP 进行批量数据传输时的数据传输吞吐量, 能反映网络极限转发能力(可能会存在丢包)。 |

| 1500字节 TCP 收发带宽(Mbits/秒) | 表示通过 TCP 进行批量数据传输时的数据传输吞吐量, 能反映网络极限带宽能力(可能会存在丢包)。 |

| TCP-RR(次/秒) | 表示在 TCP 长链接中反复进行 Request/Response 操作的交易吞吐量, 能反映 TCP 不丢包网络转发能力。 |

操作步骤

准备测试环境

准备3台测试机器,请参见创建弹性云主机购买测试机器。本文测试机器使用 CentOS 8.2 操作系统。

依次登录测试机器,并执行以下命令安装 netperf 工具。

yum install -y sysstat wget tar automake make gccwget -O netperf-2.7.0.tar.gz -c https://codeload.github.com/HewlettPackard/netperf/tar.gz/netperf-2.7.0tar zxf netperf-2.7.0.tar.gzcd netperf-netperf-2.7.0./autogen.sh && ./configure && make && make install

测试发包性能

分别在机器中执行命令“

pkill netserver && pkill netperf”,停止残余的 netperf 和 netserver 进程。将其中的机器 a 作为客户端,机器 b 和机器 c 作为服务端。在服务端中执行命令“

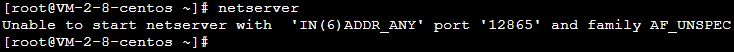

netserver”,运行 netserver。若返回结果如下图所示,则说明仍存在其他 netserver 进程。请执行步骤1中的命令,停止该进程。

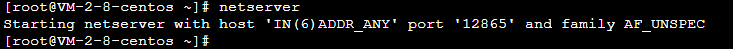

若返回结果如下图所示,则说明已成功运行 netserver,请继续下一步操作。

在客户端中执行 测试场景 中提供的命令,不断增减 netperf 进程,直到客户端发包性能不再增加。

执行以下命令,启动10个netperf客户端进程

bash netperf 10 <serverip1> <serverip2> <serverip3> <serverip4> <serverip5> <serverip6> <serverip7> <serverip8> <serverip9> <serverip10>同时向b、c两台或者多台客户端发送数据,代码如下:

#!/bin/bash count=$1 shift while [ $# != 0 ];do for ((i=1;i<=count;i++)) do server_ip=$1 [ -z $server_ip ] && exit 0 # 下方命令可以替换为测试场景表格中的命令 # -H 后填写服务器 IP 地址; # -l 后为测试时间,为了防止 netperf 提前结束,因此时间设为 10000; netperf -t UDP_STREAM -H $server_ip -l 10000 -- -m 64 -R 1 & echo "$server_ip run $i times" done shift done

在客户端执行命令“sar -n DEV 1”,观察客户端发包性能变化,取最大值。

根据所得结果,参考性能指标进行分析,即可测出云主机高吞吐网络性能。

测试收包性能

分别在机器中执行命令“

pkill netserver && pkill netperf”,停止残余的 netperf 和 netserver 进程。将其中的机器 a 作为服务端,机器 b 和机器 c 作为客户端。在服务端中执行命令“

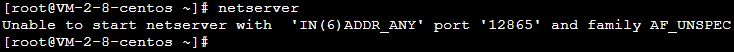

netserver”,运行 netserver。若返回结果如下图所示,则说明仍存在其他 netserver 进程。请执行 步骤1 中的命令,停止该进程。

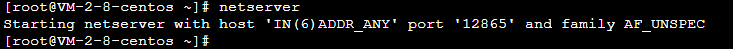

若返回结果如下图所示,则说明已成功运行 netserver,请继续下一步操作。

在客户端中执行 测试场景 中提供的命令,不断增减 netperf 进程,直到客户端发包性能不再增加。

在服务端执行命令“

sar -n DEV 1”,观察服务端收包性能变化,取最大值。根据所得结果,参考 性能指标 进行分析,即可测出云主机高吞吐网络性能。

附录

测试辅助脚本:

执行该脚本,可快速发起多个 netperf 进程。

#!/bin/bash

count=$1

for ((i=1;i<=count;i++))

do

echo "Instance:$i-------"

# 下方命令可以替换为测试场景表格中的命令

# -H 后填写服务器 IP 地址;

# -l 后为测试时间,为了防止 netperf 提前结束,因此时间设为 10000;

netperf -t UDP_STREAM -H <server ip=""> -l 10000 -- -m 64 -R 1 &

doneDPDK测试

编译安装 DPDK

准备2台测试机器,请参见 自定义配置 Linux 云主机 购买测试机器。本文测试机器使用 CentOS 8.2 操作系统。

依次登录测试机器,并执行以下命令下载 DPDK 工具。

yum install -y sysstat wget tar automake make gcc wget http://git.dpdk.org/dpdk/snapshot/dpdk-17.11.tar.gz tar -xf dpdk-17.11.tar.gz mv dpdk-17.11 dpdk修改 txonly 引擎,使每个 DPDK 发包 CPU 上的 UDP 流量的端口变动产生多条流。

执行以下命令,修改 dpdk/app/test-pmd/txonly.c 文件。

vim dpdk/app/test-pmd/txonly.c按 i 进入编辑模式,修改以下内容:

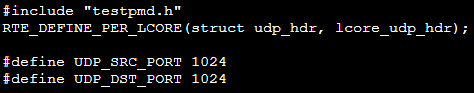

找到 #include "testpmd.h",另起一行输入如下内容:

RTE_DEFINE_PER_LCORE(struct udp_hdr, lcore_udp_hdr);修改完成后,如下图所示:

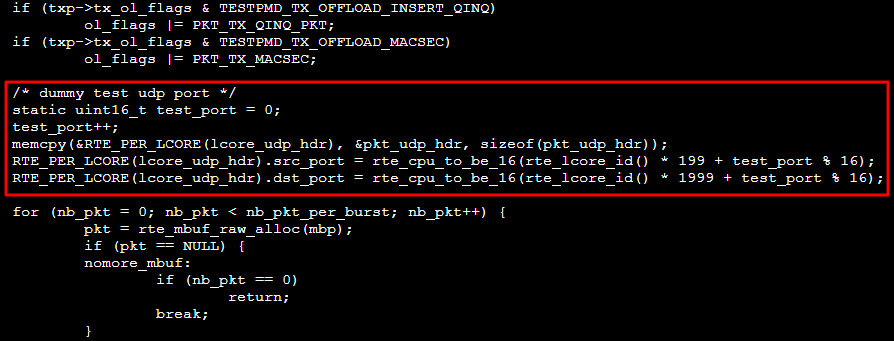

找到 ol_flags |= PKT_TX_MACSEC;,另起一行输入如下内容:

/* dummy test udp port */ static uint16_t test_port = 0; test_port++; memcpy(&RTE_PER_LCORE(lcore_udp_hdr), &pkt_udp_hdr, sizeof(pkt_udp_hdr)); RTE_PER_LCORE(lcore_udp_hdr).src_port = rte_cpu_to_be_16(rte_lcore_id() * 199 + test_port % 16); RTE_PER_LCORE(lcore_udp_hdr).dst_port = rte_cpu_to_be_16(rte_lcore_id() * 1999 + test_port % 16);修改完成后,如下图所示:

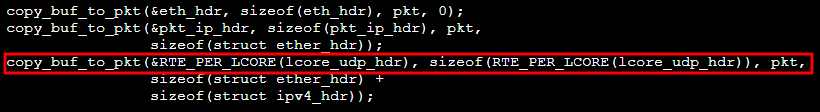

找到 copy_buf_to_pkt(&pkt_udp_hdr, sizeof(pkt_udp_hdr), pkt,,将其替换为如下内容:

copy_buf_to_pkt(&RTE_PER_LCORE(lcore_udp_hdr), sizeof(RTE_PER_LCORE(lcore_udp_hdr)), pkt,修改完成后,如下图所示:

按 Esc 输入 :wq 保存修改并退出。

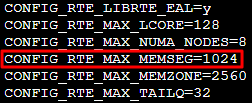

执行以下命令,修改 dpdk/config/common_base 文件。

vim dpdk/config/common_base按 i 进入编辑模式,找到 CONFIG_RTE_MAX_MEMSEG=256,将其修改为1024。修改完成后如下图所示:

按 Esc 输入 :wq 保存修改并退出。

执行以下命令,将 dpdk/app/test-pmd/txonly.c 的 IP 地址修改为测试机器所用 IP。

vim dpdk/app/test-pmd/txonly.c按 i 进入编辑模式,找到如下内容:

#define IP_SRC_ADDR (198U << 24) | (18 << 16) | (0 << 8) | 1; #define IP_DST_ADDR (198U << 24) | (18 << 16) | (0 << 8) | 2;按数字198、18、0、1替换为机器 IP,SRC_ADDR 为发送端 IP,DST_ADDR 为接收端 IP。

对应机器操作系统,执行以下命令,安装 numa 库。

yum install numactl-devel在 dpdk/ 目录下执行以下命令,关闭 KNI。

sed -i "s/\(^CONFIG_.KNI.\)=y/\1=n/g" ./config/*若您的操作系统内核版本较高(例如5.3),则请执行以下命令,屏蔽差异。

sed -i "s/\(^WERROR_FLAGS += -Wundef -Wwrite-strings$\)/\1 -Wno-address-of-packed-member/g" ./mk/toolchain/gcc/rte.vars.mksed -i "s/fall back/falls through -/g" ./lib/librte_eal/linuxapp/igb_uio/igb_uio.c执行以下命令,编译DPDK。

make defconfigmake -j

配置大页内存

执行以下命令,配置大页内存。

let hugepagesall=$(cat /proc/meminfo | grep MemTotal | awk '{print $2}')/1024/2048

#配置时不超过理论可配大页个数

echo $hugepagesall > /sys/kernel/mm/hugepages/hugepages-2048kB/nr_hugepages装载内核模块及绑定接口

切换登录方式为使用VNC。由于将网卡驱动绑定至 igb_uio 用户态驱动后,该网卡将无法通过 ssh 或 IP 访问,仅支持通过 VNC 或 console 方式访问。

依次执行以下命令,装载 UIO 模块及绑定 virito 接口。

ifconfig eth0 0 ifconfig eth0 down modprobe uio insmod /root/dpdk/build/kmod/igb_uio.ko cd /root/dpdk/usertools/ python3 dpdk-devbind.py --bind=igb_uio 00:05.0完成测试后,可通过请执行以下命令,恢复网卡变更。

cd /root/dpdk/usertools/ python3 dpdk-devbind.py --bind=virtio-pci 00:05.0 ifconfig eth0 up

测试带宽及吞吐量

执行以下命令,发送端采用 TX only 模式启动 testpmd, 接收端启用 rxonly 模式。

发送端:

/root/dpdk/build/app/testpmd -- --txd=128 --rxd=128 --txq=16 --rxq=16 --nb-cores=1 --forward-mode=txonly --txpkts=1430 --stats-period=1接收端:

/root/dpdk/build/app/testpmd -- --txd=128 --rxd=128 --txq=48 --rxq=48 --nb-cores=16 --forward-mode=rxonly --stats-period=1

执行以下命令,测试 pps(UDP 64B 小包)。

发送端:

/root/dpdk/build/app/testpmd -- --txd=128 --rxd=128 --txq=16 --rxq=16 --nb-cores=3 --forward-mode=txonly --txpkts=64 --stats-period=1接收端:

/root/dpdk/build/app/testpmd -- --txd=128 --rxd=128 --txq=48 --rxq=48 --nb-cores=16 --forward-mode=rxonly --stats-period=1

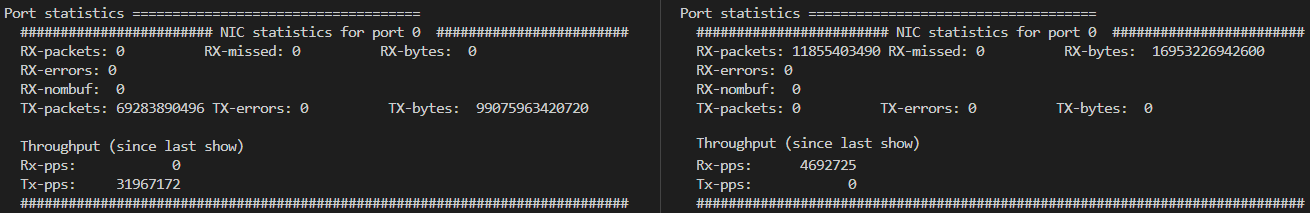

得出如下图所示测试结果:

网络带宽计算

可根据接收端 PPS 和测试包长来计算当前网络的接收带宽,公式如下:

PPS × packet length × 8bit/B × 10^-9 = 带宽

结合测试得出数据,可得当前带宽为:

4692725pps × 1430B × 8bit/B × 10^-9 ≈ 53Gbps