一、引言

1、什么是Apache Spark

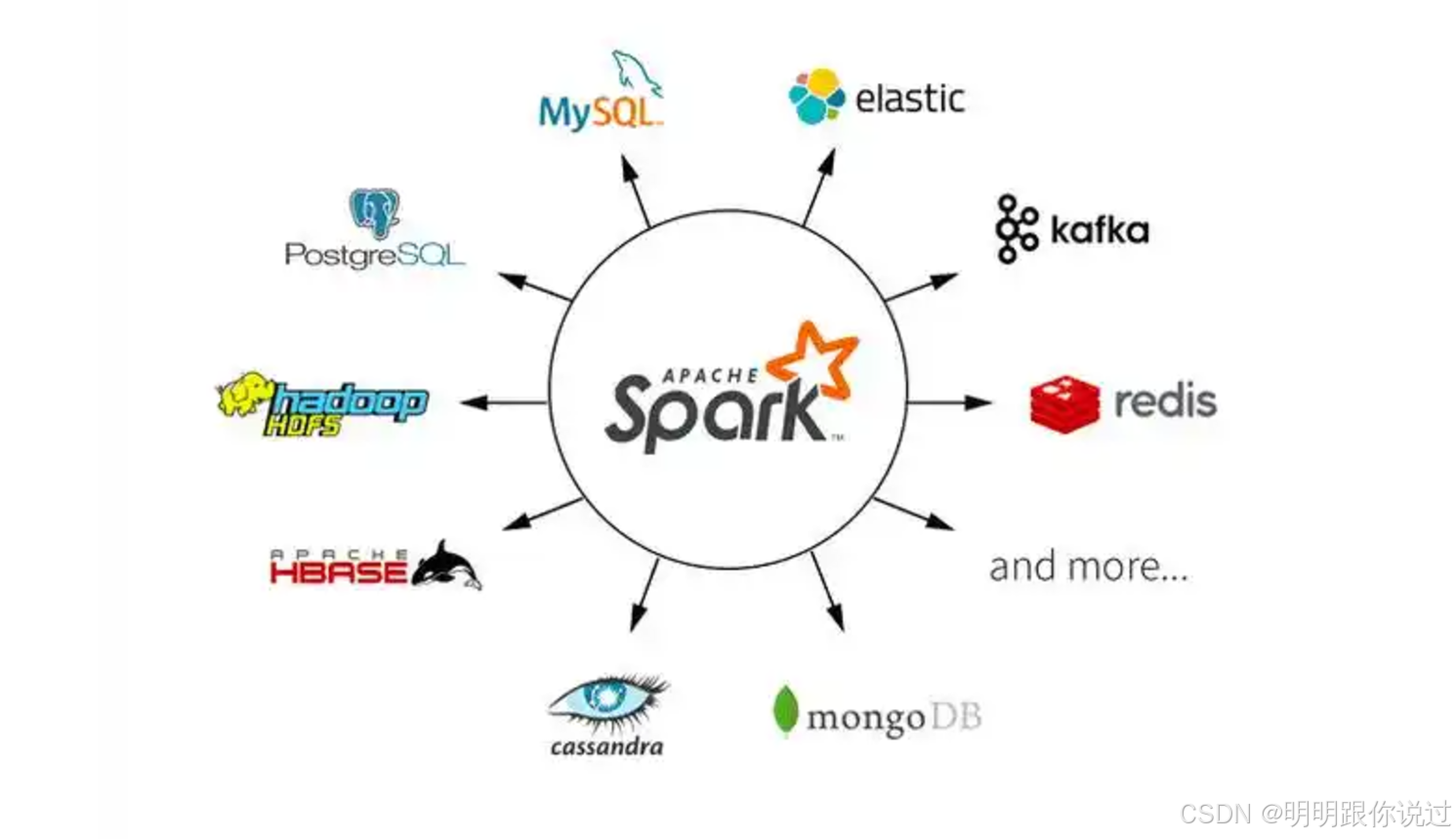

Apache Spark 是一个开源的大数据处理框架,它支持高效的分布式计算,并能够处理大规模数据集。Spark 提供了一个统一的编程模型,支持批处理、流处理、机器学习和图计算等多种数据处理模式。Spark 以其内存计算的特性和高效的任务调度而著称,比传统的大数据处理框架(如 Hadoop MapReduce)具有更高的性能和

2、Spark 的应用场景:

- 批处理:Spark 可以处理大规模数据集的批量处理任务,类似于 Hadoop 的 MapReduce。

- 流处理:Spark Streaming 可以实时处理流数据,适用于日志分析、社交媒体分析等实时数据分析场景。

- 机器学习:通过 MLlib,Spark 提供了大规模机器学习的支持,适用于推荐系统、分类、回归等任务。

- 图计算:GraphX 提供了图计算的能力,适用于社交网络分析、路径计算等图数据处理任务。

二、Spark核心组件之一:RDD

1、什么是RDD

RDD(Resilient Distributed Dataset)是 Apache Spark 的核心数据结构,它是一个不可变的、分布式的数据集。RDD 具有高度的容错性、可分布性和支持并行计算的特点,因此成为 Spark 中进行分布式数据处理的基础。RDD 的设计使得 Spark 能够在大规模集群中高效地处理数据,同时提供容错机制,以确保即使在部分计算失败的情况下,数据也能恢复。

2、RDD 的特点

弹性(Resilient):

- RDD 通过 数据血统(Lineage) 来实现容错性。数据血统是 RDD 的操作日志,它记录了生成当前 RDD 的所有操作(如 map、filter 等)。如果某个节点发生故障,Spark 可以通过重新计算丢失的数据分区来恢复数据,保证系统的容错性。

分布式(Distributed):

- RDD 是分布式的,它的数据可以存储在集群的不同节点上。每个 RDD 都有多个分区,每个分区由集群中的一个节点存储和处理,支持并行计算。

不可变(Immutable):

- 一旦 RDD 被创建,它的数据不能被修改。对 RDD 的操作(如 map()、filter())会生成新的 RDD,而不会改变原始 RDD 的内容。这种不可变性使得 Spark 可以更好地管理并行计算和容错。