神经网络

神经网络是深度学习的核心,在了解神经网络之前,我们先来了解几个概念:

智能( Intelligence )是个体有目的的行为,合理的思维以及有效的适应环境的综合能力。或者说智能是个体认识客观事物和运用知识解决问题的能力。

人工智能( Artificial Intelligence, AI)最初在1956年被引入,它主要研究怎样让计算机模仿人脑从事推理、设计、思考、学习等思维活动,以解决和处理较复杂的问题。简单的讲,人工智能就是研究如何让计算机模仿人脑进行工作。

人工神经网络( Artificial Neural Network , ANN)是一种旨在模仿人脑结构及其功能的脑式智能信息处理系统。通常以数学和物理的方法以及信息处理的角度对人脑神经网络进行抽象,并建立某种简化模型。简单的讲,它是一种数学模型 ,可以用电子线路来实现,也可以通过计算机程序来模拟,是人工智能的一种研究方法。

人工智能( Artificial Intelligence , AI)最初在1956年被引入,它主要研究怎样让计算机模仿人脑从事推理、设计、思考、学习等思维活动,以解决和处理较复杂的问题。简单的讲,仍贡智能就是研究如何让j计算机模仿人脑进行工作。由于研究的出发点、方法学以及应用领域的不同,有多个代表性的流派:

-

符号主义学派: Newell和Simon在1967年提出的假说,认为人工智能源于数学逻辑,通过数学逻辑来描述智能行为,后来发展了启发式算法->专家系统- >知识工程的理论。

-

联接主义学派:代表人物为McCulloch和Pitts ,认为人工智能源于仿生学,特别是人脑的研究,并提出了MP模型,后来基于该模型衍生出人工神经网络等

-

行为主义学派:认为人工智能源于控制论, Wiener等提出的控制论和自组织系统等,立足于模拟人在控制过程中的智能行为和作用, 如自组织、自寻优、自适应、自学习等

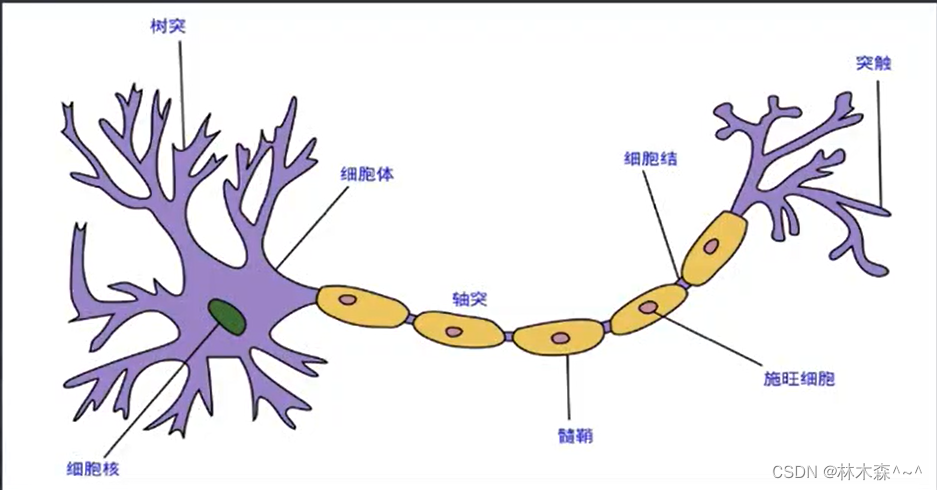

人类神经元

我们了解一下人类神经元的工作原理:

神经元是脑组织的基本单元,是神经系统结构与功能的单位。不同的神经元形态不同功能也有差异,其共性的结构简化如下:

- 细胞体: 神经元主体,由细胞核、细胞质、细胞 膜等组成,细胞膜对细胞液中的不同离子通透性不同,使得产生离子浓度差,从而出现内负外正的静息电位

- 树突: 通过树突接受来自其他神经元的输入信号

- 轴突: 传出细胞体产生的输出电化学信号

- 突触: 神经元间通过一个的轴突末梢和其他神经元的细胞体或者树突进行通信连接,相当于神经元之间的输入输出接口

突触是神经元的输入和输出接口,树突和细胞体作为输入端,接收突出点的输入信号;细胞体相当于一个处理器,对各树突和细胞体各部位收到的来自其他神经元的输入信号进行组合,并在一定条件下触发,产生一个输出信号,输出信号沿轴突传至末梢, 轴突末梢作为输出端通过突触将这以输出信号传向其他神经元。

生物神经元的信息的产生、传递和处理是一种电化学活动 ,其机制为:

-

信息产生:在某一给定时刻 ,神经元总是处于静息、兴奋和抑制三种状态之一-。在外界的刺激下,当神经元的兴奋程度大于某个阈电位时, 神经元被激发而发出神经脉冲。

-

传递与接收:神经脉冲信号沿轴突传向其末端的各个分支,通过突触完成传递与接收。突触有兴奋性突触和抑制性性突触两种,当兴奋性突触的电位超过某个阈电位时, 后-一个神经元就有神经脉冲输出,从而把前一个神经元的信息传递给了后一一个神经元。

-

信息整合:接收各个轴突传来的脉冲输入,根据输入可到达神经元的不同部位,输入部位不同, 对神经元影响的权重也不同。在同一时刻产生的刺激所3 |起的电位变化大致等于各单独刺激3 |起的电位变化的代数和。神经元对空间和时间上对输入进行积累和整合加工,从而决定输出的时机和强弱

-

生物神经网络:由多个生物神经元以确定方式和拓扑结构互相连接即形成生物神经网络,是一 种更为灵巧、复杂的生物信息处理系统,在宏观上呈现出复杂的信息处理能力。

M-P模型

1943年心理学家McCulloch和数学家w. Pitts基于生物神经元的特点,提出了M-P模型。模型通过对生物神经元信息处理过程进行了简化和概括。

- 每个神经元都是多输入单输出的信息处理单元

- 神经元的输入分为兴奋性输入和抑制性输入两种类型

- 神经元具有空间整合特性和阈值特性

- 神经元输入与输出间有固定的时间延迟

- 忽略时间整合作用,忽略兴奋期后的不应期

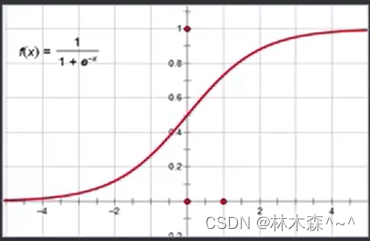

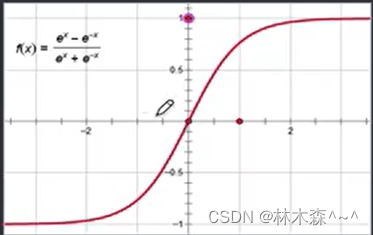

激活函数

激活函数(Activation Function) :也叫连接函数、传递函数、变换函数或者激励函数。用来模拟神经元输出与其激活状态之间的联系:输入达到某个阈值后达到激活状态,否则为抑制态。不同的激活函数,会使神经元具有不同的信息处理特性。对于神经网络来讲,激活函数的主要作用就是进行线性变换,增加系统的非线性表达能力。

sign函数

sigmoid函数

Tanh函数

arctan函数

神经网络分类

按照信息流方向可分为前馈性网络和反馈性网络

- 前馈型网络:网络信息从输入层到各隐藏层再到输出层逐层前进

- 反馈型网络:反馈网络中所有节点都具有信息处理功能,并且每个节点既可以接收输入同时又可以进行输出。

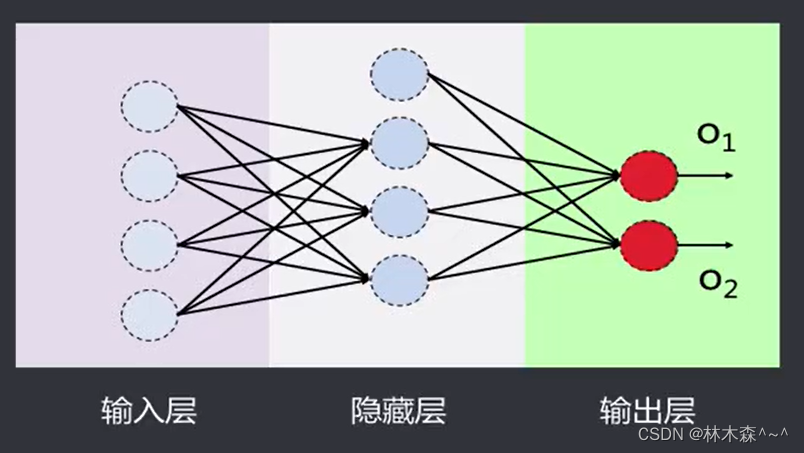

前馈神经网络

前馈神经网络( FeedForward NN ) : 是一种最简单的神经网络,采用单向多层结构,各神经元分层排列,每个神经元只与前一-层的神经元相连。接收前一层的输出,并输出给下-层,各层间没有反馈。

前馈网络包括三类节点:

- 输入节点( Input Nodes) :外界信息输入,不进行任何计算,仅向下一层节点传递信息

- 隐藏节点 ( Hidden Nodes) : 接收上一层节点的输入,进行计算,并将信息传到下一层节点

- 输出节点( Output Nodes) : 接收上-层节 点的输入,进行计算,并将结果输出

输入层和输出层必须有,隐藏层可以没有,即为单层感知器,隐藏层也可以不止-层,有隐藏层的前馈网络即多层感知器

反馈神经网络

反馈神经网络( FeedBack NN ) : 又称递归网络、回归网络,是一种将输出经过一 步时移再接 入到输入层的神经网络系统。这类网络中,神经元可以互连,有些神经元的输出会被反馈至同层甚至前层的神经元。常见的有Hopfield神经网络、EIman神经网络、 Boltzmann机等。

前馈神经网络和反馈神经网络的主要区别:

- 前馈神经网络各层神经元之间无连接,神经元只接受上层传来的数据,处理后传入下一层,数据正向流动;反馈神经网络层间神经元有连接,数据可以在同层间流动或反馈至前层

- 前馈神经网络不考虑输出与输入在时间上的滞后效应,只表达输出与输入的映射关系;反馈神经网络考虑输出与输入之间在时间上的延迟,需要用动态方程来描述系统的模型。

- 前馈神经网络的学习主要采用误差修正法(如BP算法) ,计算过程一般比较慢,收敛速度也比较慢;反馈神经网络主要采用Hebb学习规则,一般情况下计算的收敛速度很快

- 相比前馈神经网络,反馈神经网络更适合应用在联想记忆和优化计算等领域