Hadoop常用命令

1、实验描述

- 熟悉HDFS的命令行接口

2、实验环境

-

虚拟机数量:3

-

系统版本:Centos 7.5

-

Hadoop版本:Apache Hadoop 2.7.3

3、相关技能

-

熟悉Linux操作系统,Hadoop原理

-

HDFS命令行接口

4、知识点

- HDFS命令行接口

5、实验步骤

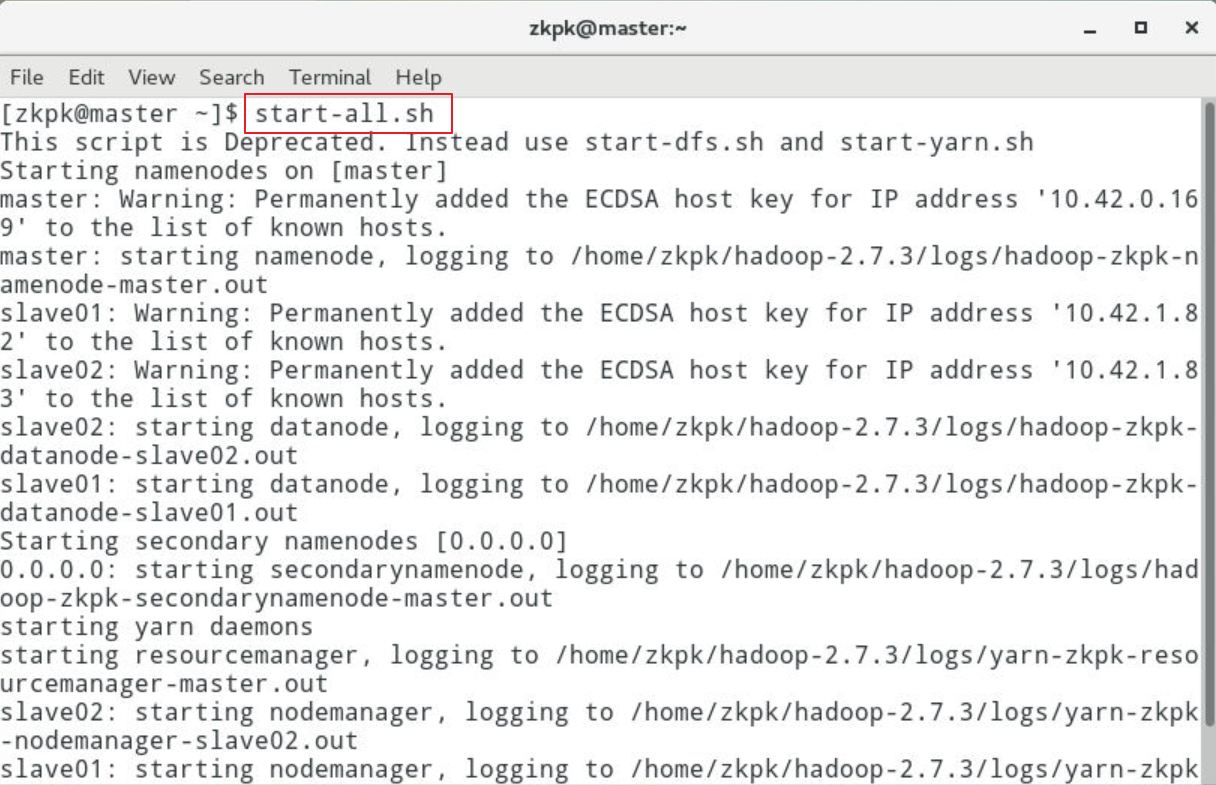

5.1进入虚拟机并启动Hadoop集群

5.1.1在master启动Hadoop集群

[zkpk@master ~]$ start-all.sh

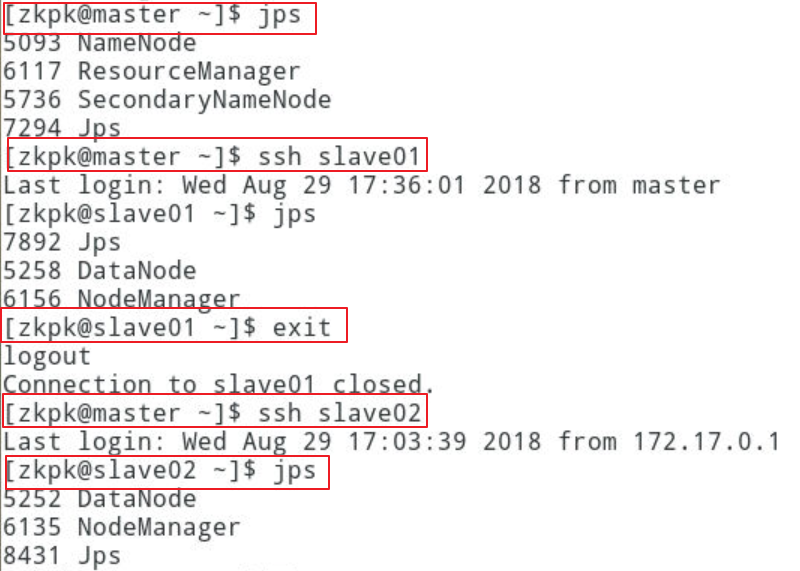

5.1.2在master上运行jps,确认NameNode, SecondaryNameNode, ResourceManager进程启动

5.1.3在slave01上运行jps,确认DataNode, NodeManager进程启动

5.1.4在slave02上运行jps,确认DataNode, NodeManager进程启动

5.2练习hdfs命令行接口

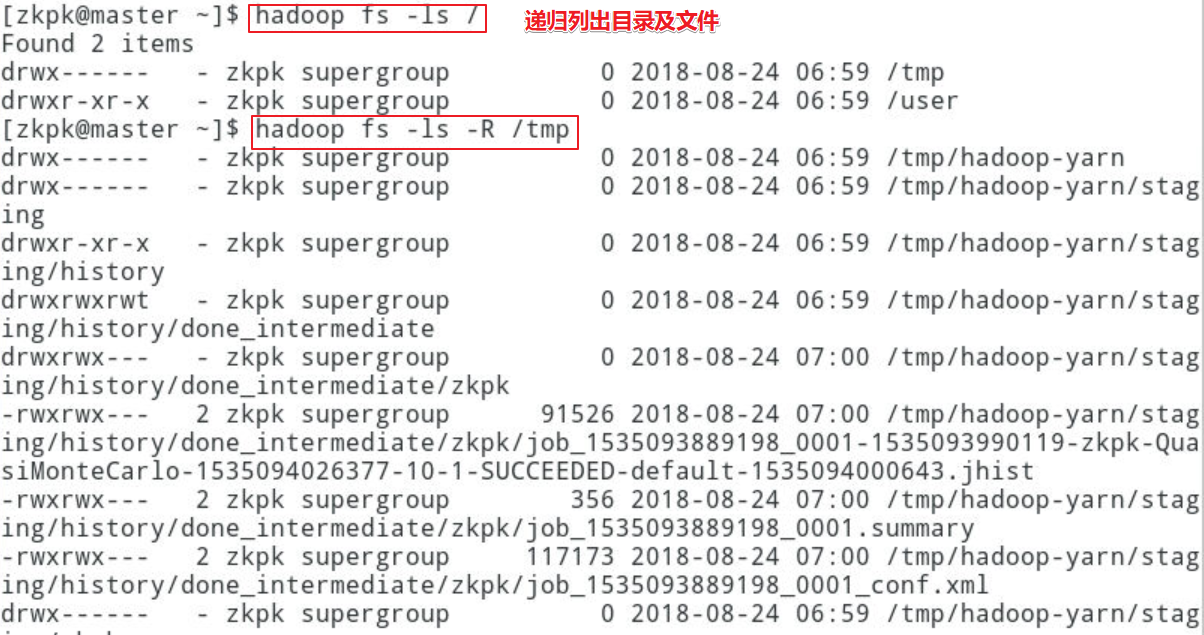

5.2.1列出目录及文件命令

5.2.1.1hadoop fs –ls为固定的命令,-ls用来指定咱们要列出文件,path参数指定需要列出列表的父路径。path取值如果在前边加上/的话是从HDFS的根目录下开始列,否则从HDFS上的用户目录/user/username/开始列。

[zkpk@master ~]$ hadoop fs -ls <path>

5.2.2递归列出目录及文件

5.2.21hadoop fs –ls -R为固定的命令,-ls -R用来指定咱们要递归查看的文件,path参数指定需要列出列表的父路径 。

[zkpk@master ~]$ hadoop fs -ls -R <path>

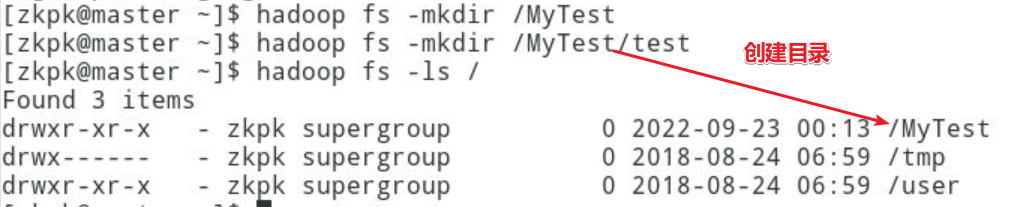

5.2.3创建目录

5.2.3.1hadoop fs –mkdir为固定的命令,–mkdir用来指定创建的文件目录命令,path参数指定创建目录路径,注意,不能创建级联目录。

[zkpk@master ~]$ hadoop fs -mkdir <path>

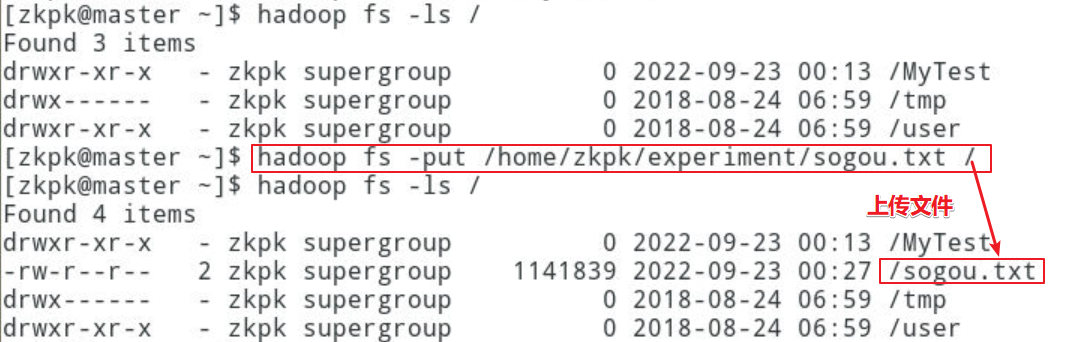

5.2.4上传文件,有两种方式

5.2.4.1hadoop fs -put 为固定的命令,\参数指定上传文件及其本地路径,\参数指定文件上传到HDFS的路径

[zkpk@master ~]$ hadoop fs -put <src> <des>

5.2.4.2hadoop fs - copyFromLocal为固定的命令,\参数指定上传文件及其本地路径,\参数指定文件上传到HDFS的路径

[zkpk@master ~]$ hadoop fs -copyFromLocal <src> <des>

5.2.5从hdfs上传下载文件

5.2.5.1hadoop fs -get \ ;des为HDFS上的文件的绝对路径,src为本地要把下载的文件存放的位置

[zkpk@master ~]$ hadoop fs -get <des> <src>

5.2.5.2hadoop fs -copyToLocal \ ;命令copyToLocal后边必须跟两个参数,第一个是HDFS上的文件的绝对路径,第二个是本地要存档下载文件的路径,必须存在,否则报错

[zkpk@master ~]$ hadoop fs -copyToLocal <src> <des>

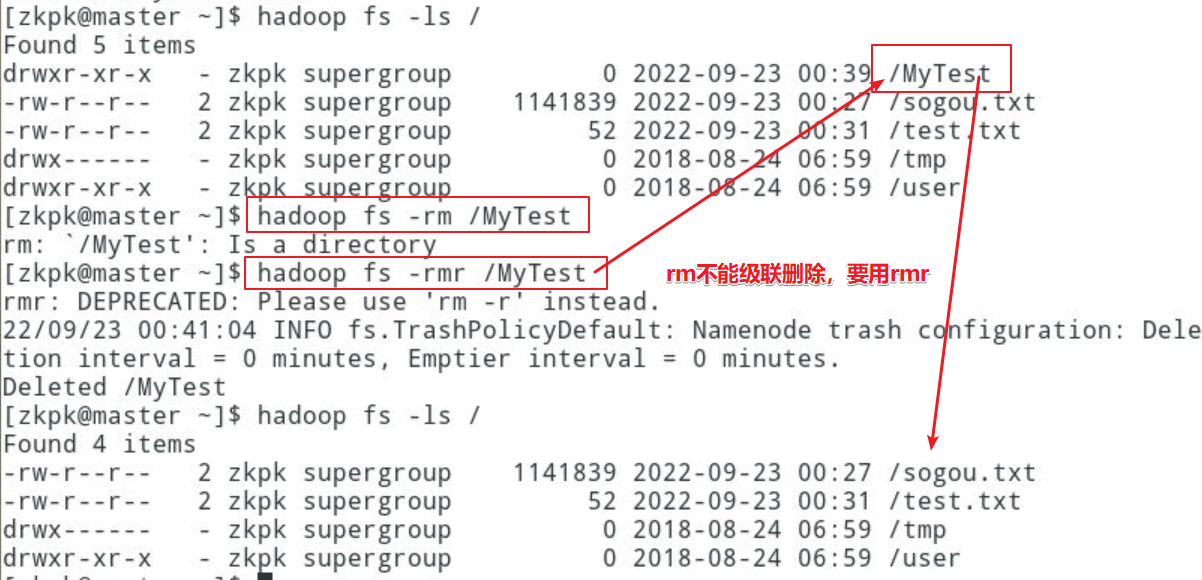

5.2.6删除HDFS上的文件

5.2.6.1hadoop fs –rm \ ;rm命令后边必须跟要查看的文件的路径,路径必须存在,否则报错。如果需要递归删除某个文件夹下所有的文件夹和目录,使用rmr命令就可以了。

[zkpk@master ~]$ hadoop fs -rm <path>[zkpk@master ~]$ hadoop fs -rmr <path>

6、总结

HDFS虽然是Hadoop的一个组件,但同时HDFS本身也是独立的,并不依赖与MapReduce运行环境,可以作为一个独立的分布式文件系统来使用。我们可以同过HDFS的命令行接口进一步认识HDFS。