最佳实践概述

场景描述

如果您想要在流数据实时处理场景下,使用Kafka作为流数据的源或者使用Kafka作为流数据的目的,需要将Kafka与Flink对接,可以参考本实践方案。

技术架构图

暂无。

方案优势

用户可按业务需要,参考设置Kafka与Flink框架对接,实现流数据的消息消费。

前提条件

需已购买Kafka实例、创建Topic,并且已成功消费消息。

资源规划

本实践方案内容仅涉及Kafka专享版实例和Flink的安装配置。

分布式消息服务

Figure 分布式消息服务

| 资源类型 | 配置项 | 配置明细 | 说明 |

|---|---|---|---|

| 企业中间件 | DMS | Kafka专享实例 | 需已购买kafka专享实例,创建好Topic,并成功消费消息。 |

Flink流数据处理框架

Figure Flink框架

| 资源类型 | 配置项 | 配置明细 | 说明 |

|---|---|---|---|

| 应用软件 | Flink框架 | Flink 1.14 | 使用开源Apache Flink |

方案正文

获取Kafka访问地址

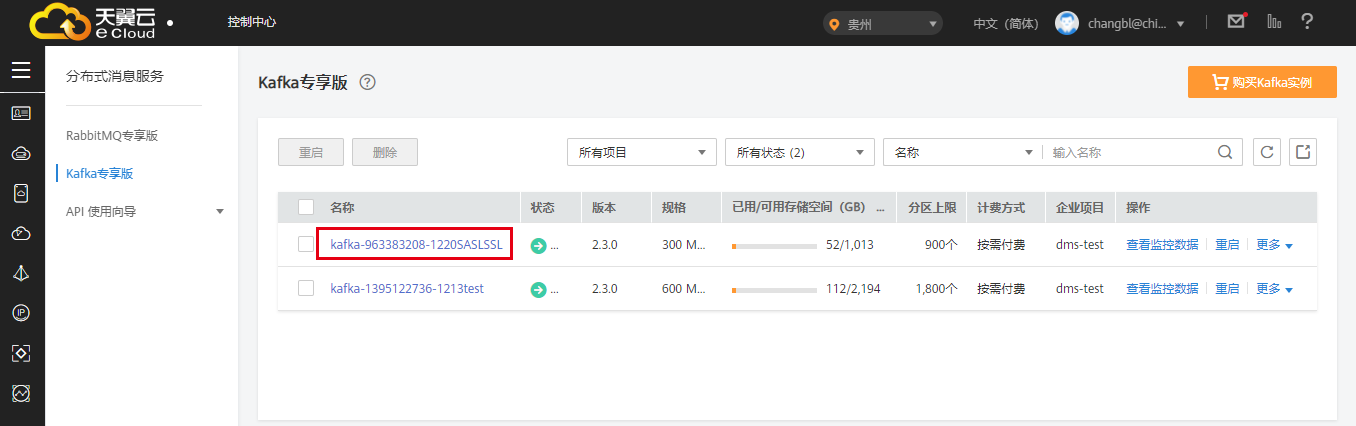

1、登录分布式消息服务Kafka版控制台,按需要单击“实例名称”,进入实例基本信息页面。

图 Kafka控制台实例列表

2、在“连接地址”模块,获取Kafka连接IP地址。

图 连接IP地址与端口

创建Topic

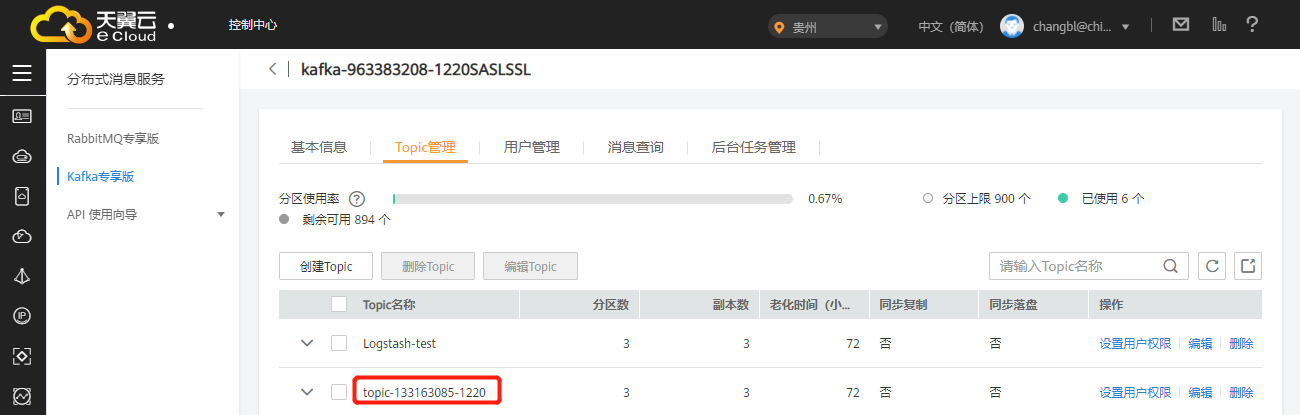

在 Topic 管理页面,单击创建Topic,创建一个名为 topic-133163085-1220的 Topic。

图 创建Topic

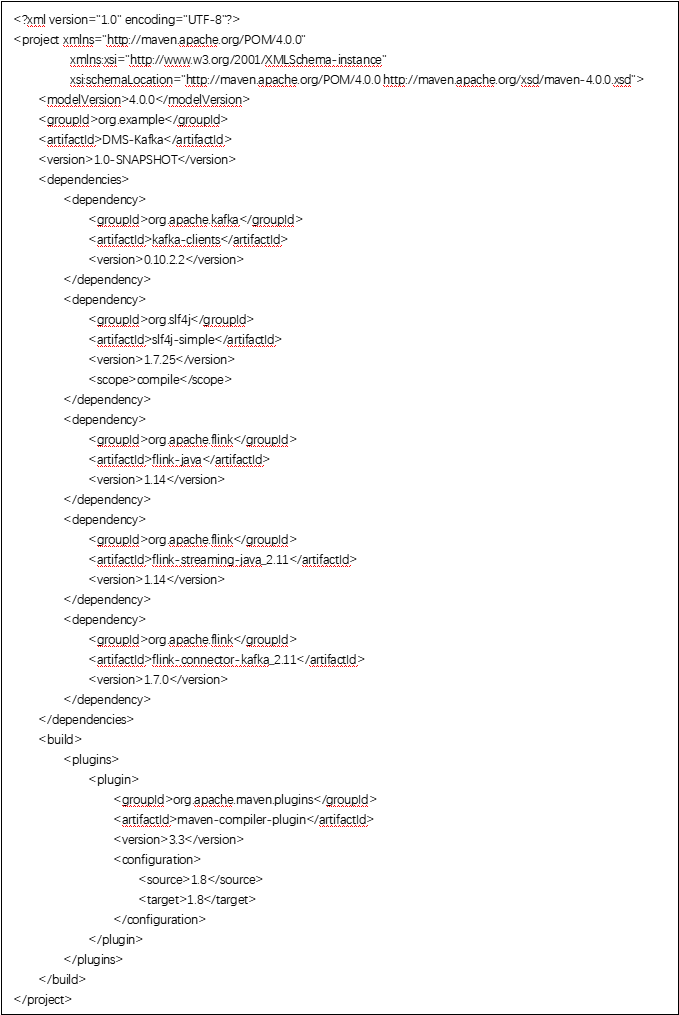

添加Maven依赖

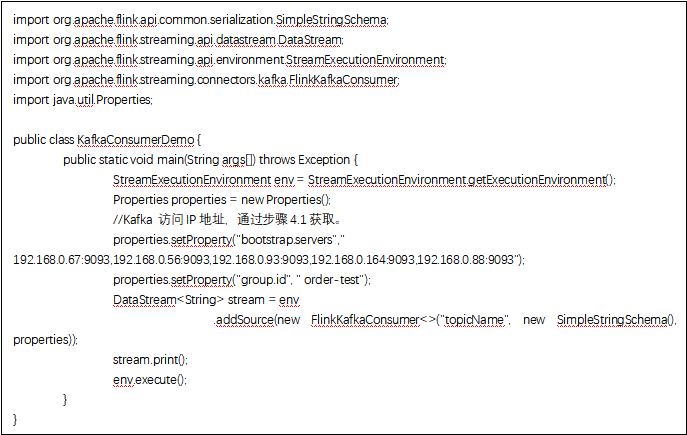

在应用代码工程中找到pom.xml,添加如下依赖配置信息:

消费Kafka消息

在Flink工程代码中,连接Kafka信息: