为什么可用区不能选择2个?

如果您需要提高Kafka实例的可靠性,在创建实例时,建议选择3个或以上的可用区,不支持选择2个可用区。原因如下:

每个Kafka实例包含3个Zookeeper节点,Zookeeper集群用来管理Kafka实例的配置,如果Zookeeper集群出现问题,Kafka实例将无法正常运行。至少2个Zookeeper节点正常运行,才能保证Zookeeper集群正常运行。

假设选择2个可用区,可用区1有1个Zookeeper节点,可用区2有2个Zookeeper节点。如果可用区1故障,则Kafka实例能正常使用;如果可用区2故障,则不能正常使用。Kafka实例可用的场景只有50%,所以不支持选择2个可用区。

创建实例时为什么无法查看子网和安全组等信息?

创建实例时,如果无法查看虚拟私有云、子网、安全组、弹性IP,可能原因是该用户的用户组无Server Administrator和VPC Administrator权限。增加用户组权限的详细步骤,请参考《统一身份认证服务 用户指南》的“用户指南 > 用户组及授权 > 查看或修改用户组”章节。

如何选择Kafka实例的存储空间?

存储空间主要是指用于存储消息(包括副本中的消息)、日志和元数据所需要的空间。选择存储空间时,需要选择磁盘类型和磁盘大小。更多磁盘信息,请参考《云硬盘用户指南》的“简介 > 磁盘类型及性能介绍”章节

假设业务存储数据保留天数内磁盘大小为100GB,则磁盘容量最少为 100GB*副本数 + 预留磁盘大小100GB 。Kafka集群中,每个Kafka节点会使用33GB的磁盘作为日志和Zookeeper数据的存储,因而实际可用存储会小于购买存储。

其中,副本数在创建Topic时可以选择,默认为3副本存储。如果开启了Kafka自动创建Topic功能,自动创建的Topic默认为3副本,副本数可以通过“配置参数”页签中的“default.replication.factor”修改。

Kafka实例的超高IO和高IO如何选择?

- 高IO:平均时延1-3ms,最大带宽150MB/s(读+写)。

- 超高IO:平均时延1ms,最大带宽350MB/s(读+写)。

建议选择超高IO,云硬盘服务端压力大场景,都不能达到最大带宽,但是超高IO可达到的带宽比高IO高很多。

- 如何选择Kafka实例存储容量阈值策略?

支持以下两种策略:

- 生产受限策略

该策略场景下一旦磁盘使用达到容量阈值95%,会导致后续生产失败,但保留了当前磁盘中的数据,直至数据自然老化(Kafka原有的老化机制,数据默认保留3天)。该场景适用于对数据不能丢的业务场景,但是会导致生产业务失败。

- 自动删除策略

该策略场景下磁盘使用到达容量阈值95%后,依旧可以正常生产和消费消息,但是会删除最早的10%的消息,以保证磁盘容量充足。该场景优先保障业务不中断,数据可能会丢失。

以上两种策略的需要基于业务对数据和业务的可靠性来进行选择,只能作为极端场景下的一个种处理方式。 建议业务购买时保证有充足的磁盘容量,避免磁盘的使用达到容量阈值 。

Kafka服务端支持版本是多少?

Kafka 1.1.0、2.3.0和2.7版本。

如果您想要创建Kafka实例,具体步骤请参考购买Kafka实例。

Kafka实例的ZK地址是什么?

Kafka实例依赖ZK进行管理,开放ZK可能引发误操作导致业务受损,ZK仅Kafka内部使用,不对外提供服务。

您可使用Kafka开源客户端连接Kafka实例,调用源生API生产与消费消息。

创建的Kafka实例是集群模式么?

一个Kafka实例即为一个集群实例,Kafka实例由3个及以上代理组成。

Kafka实例是否支持修改访问端口?

Kafka实例的访问端口固定,不支持修改。

1.如果是访问未开启SASL的Kafka实例

支持的访问方式如下:同一VPC内访问、公网访问、跨VPC访问和DNAT访问。

- 同一VPC内使用IPv4地址访问,访问端口为 9092 。

- 同一VPC内使用IPv6地址访问,访问端口为 9192 。

- 公网访问,访问端口为 9094 。

- 使用VPCEP跨VPC访问,访问端口为 9011 。

- 使用对等连接跨VPC访问,访问端口为 9092 。

- DNAT访问,访问端口为 9011 。

2.如果是访问开启SASL的Kafka实例

支持的访问方式如下:同一VPC内访问、公网访问、跨VPC访问和DNAT访问。

- 同一VPC内使用IPv4地址访问,访问端口为 9093 。

- 同一VPC内使用IPv6地址访问,访问端口为 9193 。

- 公网访问,访问端口为 9095 。

- 使用VPCEP跨VPC访问,访问端口为 9011 。

- 使用对等连接跨VPC访问,访问端口为 9093 。

- DNAT访问,访问端口为 9011 。

在访问Kafka实例之前,需要确保安全组是否配置正确,配置要求,请参考选择和配置安全组。

Kafka实例的SSL证书有效期多长?

Kafka实例开启SASL时,需进行单向认证,证书有效期足够长(超过15年),客户端不需要关注证书过期风险。

如何将Kafka实例中的数据同步到另一个Kafka实例中?

Kafka实例之间没有好的实时同步方案,如果需要做实例迁移,可以同时向两个实例生产消息,源实例中的消息可继续消费,待源实例的消息数据全部被消费完或老化后,业务可迁移到新的Kafka实例。

Kafka实例的SASL_SSL开关如何修改?

Kafka SASL_SSL开关不支持购买实例后修改,在购买时,请慎重选择,如果购买后需要修改,需要重新购买实例。

开启IPv6的实例不支持动态修改SASL_SSL开关。

SASL认证机制如何修改?

实例创建后,不支持修改SASL认证机制。如果需要修改,请重新购买实例。

修改企业项目,是否会导致Kafka重启?

修改企业项目不会导致Kafka重启。

Kafka服务和ZK是部署在相同的虚拟机中,还是分开部署?

Kafka服务和ZK部署在相同的虚拟机中。

Kafka包周期实例不支持删除吗?

可以删除。登录Kafka控制台,在包周期实例所在行,单击“更多 > 退订”,完成实例的删除。

Kafka支持哪些加密套件?

由于安全问题,支持的加密套件为TLS_ECDHE_ECDSA_WITH_AES_128_CBC_SHA256,TLS_ECDHE_RSA_WITH_AES_128_CBC_SHA256和TLS_ECDHE_RSA_WITH_AES_128_GCM_SHA256。

购买实例时选择的单AZ,怎样可以扩展为多AZ?

已购买的实例无法扩展AZ,请重新购买多AZ的实例。

Kafka是否支持跨AZ容灾?已经购买的实例在哪里查看是否为跨AZ?

Kafka实例支持跨AZ容灾,在购买实例时,选择多个可用区即可实现跨AZ容灾。

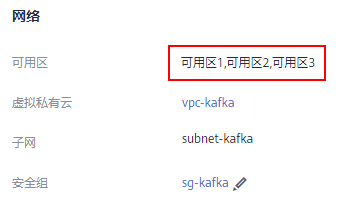

已购买的实例,在实例详情页“基本信息”页面的“网络”区域,查看可用区数量。多于一个可用区时,表示已实现跨AZ容灾。

图实例基本信息

Kafka支持磁盘加密吗?

Kafka实例不支持磁盘加密。

Kafka实例创建后,能修改VPC和子网吗?

不能修改VPC和子网。

有没有Kafka Stream的案例?

Kafka Stream的案例请参见Kafka Stream的官网。

Kafka实例版本可以升级吗?

Kafka实例创建成功后,实例版本不支持升级。您可以重新创建Kafka实例,实现升级Kafka实例的版本。

实例版本在控制台和Kafka Manager上显示不一致?

Kafka实例的版本以控制台为准。Kafka Manager使用了开源Kafka 2.2.0的公共信息配置,所以显示的版本是2.2.0,和购买的Kafka实例版本没有关系。

怎样重新绑定公网IP?

首先在分布式消息服务Kafka控制台,单击Kafka实例名称,进入实例详情页。在“基本信息”页面的“连接信息”区域,关闭“公网访问”,然后重新打开“公网访问”,并选择需要绑定的公网IP地址。