图1 Grace Hopper 超级芯片

图1 Grace Hopper 超级芯片

H100是NVIDIA的第9代数据中心GPU,旨在为大规模AI和HPC实现相比于上一代 NVIDIA A100 Tensor Core GPU数量级的性能飞跃。H100延续了A100的主要设计重点,可提升AI和HPC工作负载的强大扩展能力,并显著提升架构效率。

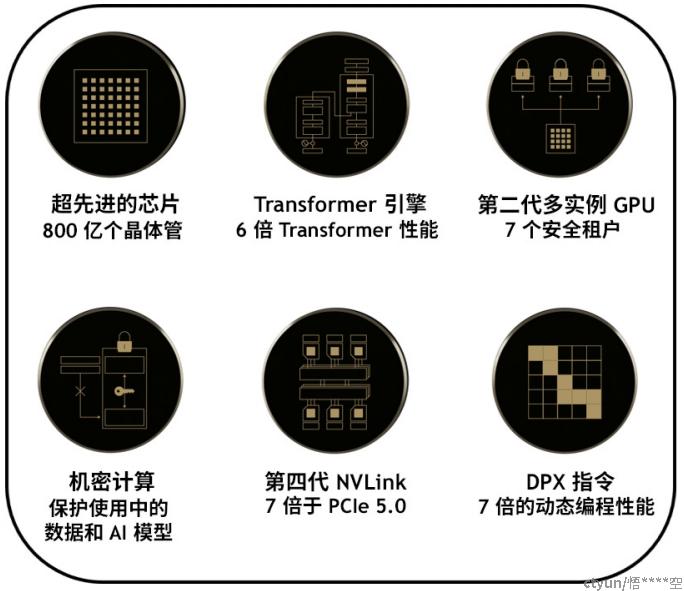

NVIDIA H100 GPU 有以下几个关键特性:

一、新型流式多处理器 (SM) 在性能和效率方面有许多改进。新的关键特性包括:

- 与 A100 相比,新的第四代 Tensor Core 的芯片间速度最高可提升6倍,包括每SM提速、额外的SM数量以及更高的H100时钟频率。基于单个SM,与上一代16位浮点选项相比,Tensor Core在同等数据类型上计算MMA(矩阵乘积累加)速度是A100 SM的 2 倍,而在使用新的 FP8数据类型时,计算速度是A100 的4 倍。稀疏功能利用深度学习网络中的细粒度结构化稀疏,使标准Tensor Core运算的性能提高了一倍。

- 与 A100 GPU 相比,新的 DPX 指令最高可将动态编程算法的速度提升7 倍。其中的两个示例包括用于基因组学处理的Smith-Waterman算法,以及在动态仓储环境中用于为机器人寻找最优路线的Floyd-Warshall算法。

- 与 A100 相比,IEEE FP64 和 FP32 的芯片间处理速度可提升 3 倍,这是因为每个 SM 的时钟频率提升了 2 倍,此外还有额外的 SM 数量以及更高的 H100时钟频率。

- 新的线程块簇功能允许以比单个 SM 上的单个线程块更大的粒度对局部性进行编程控制。这通过在编程层次结构中添加了另一个层级扩展了 CUDA 编程模型现在其中包括线程、线程块、线程块簇和网格。簇支持多个线程块在多个 SM 上并发运行,以进行同步并以协作方式获取和交换数据。

- 新的异步执行功能包括新的 Tensor Memory Accelerator(TMA) 单元,此单元可以在全局显存和共享内存之间非常高效地传输大数据块。TMA 还支持集群中线程块之间的异步拷贝。此外,还新增了异步事务屏障功能,用于执行原子数据移动和同步。

二、新的 Transformer 引擎结合了软件和定制的 Hopper Tensor Core 技术,专门用于加速Transformer 模型的训练和推理。Transformer 引擎能够智能管理并动态选择 FP8 和FP16 计算,自动处理每层中 FP8 和 FP16 之间的重铸和缩放,与上一代 A100 相比可令大型语言模型的 AI 训练速度最高提升 9 倍、AI 推理速度最高提升 30 倍。

三、与上一代产品相比,HBM3 显存子系统的带宽提升了近 2 倍。H100 SXM5 GPU 率先采用 HBM3 显存,可提供 3TB/s 的超高显存带宽。

四、50 MB 二级缓存架构可缓存大量模型和数据集以便于重复访问,从而减少对 HBM3 的访问。

五、与 A100 相比,第二代多实例 GPU (MIG) 技术提供的计算容量大约增加了 3 倍,每个GPU 实例的显存带宽提升了近 2 倍。现在首次提供具有 MIG 级别可信执行环境(TEE)的机密计算能力。支持多达七个单独的 GPU 实例,每个实例均配备专门的 NVDEC 和NVJPG 单元。每个实例现在都包含一套性能监控器,可与 NVIDIA 开发工具配合使用。

六、新的机密计算支持可保护用户数据,抵御硬件和软件攻击,并能更好地隔离和保护虚拟化及 MIG 环境中的虚拟机(VM)。H100 是全球首款支持原生机密计算的 GPU,并能够以PCle 全线速搭配 CPU 扩展可信执行环境。

七、与上一代 NVLink 相比,第四代 NVIDIA NVLink可将全局归约操作的带宽提升3 倍通用带宽提升 50%,同时多 GPU O 的总带宽为 900GB/s,是 PCle 5.0 的7倍。

八、第三代 NVSwitch 技术包括位于节点内部和外部的交换机,用于连接服务器、集群和数据中心环境中的多个 GPU。节点内的每个 NVSwitch 具有 64 个第四代 VLink 链路端口,可加速多 GPU 连接。交换机总吞吐量从上一代的 7.2Tb/s 提升到 13.6Tb/s。新的第三代NVSwitch 技术还通过组播和 NVIDIA SHARP 在网计算,为集合运算提供硬件加速。

九、新的 NVLink Switch 系统互连技术和基于第三代 NVSwitch 技术的新的二级 NVLink交换机引入了地址空间隔离和保护,使多达 32 节点或 256 个 GPU 能够以 2:1 收敛比在胖树拓扑架构中通过 NVLink 进行连接。这些连接的节点能够提供 57.6TB/s 的多对多带宽,并可以提供惊人的 1 exaFLOP FP8 稀疏 AI 计算性能。

十、PCle 5.0 的总带宽为 128GB/s (每个方向 64GB/s) ,而 PCle 4.0 的总带宽为 64GB/s(每个方向 32GB/s) 。PCle 5.0 支持 H100 与超高性能的 x86 CPU 和智能网卡/DPU(数据处理器) 交互。

此外,H100 还包括许多其他的新功能,以提升强大的扩展性、减少延迟和开销,并从总体上简化 GPU 编程。

图2 Hopper H100 中采用的新技术