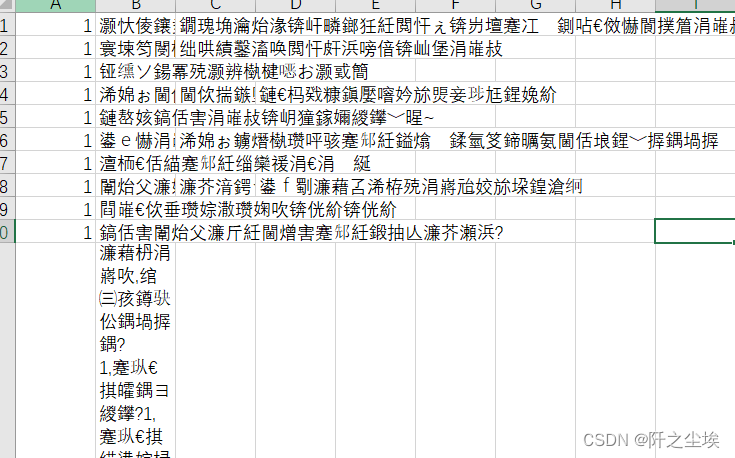

有时候我们打开csv文件会发现乱码:

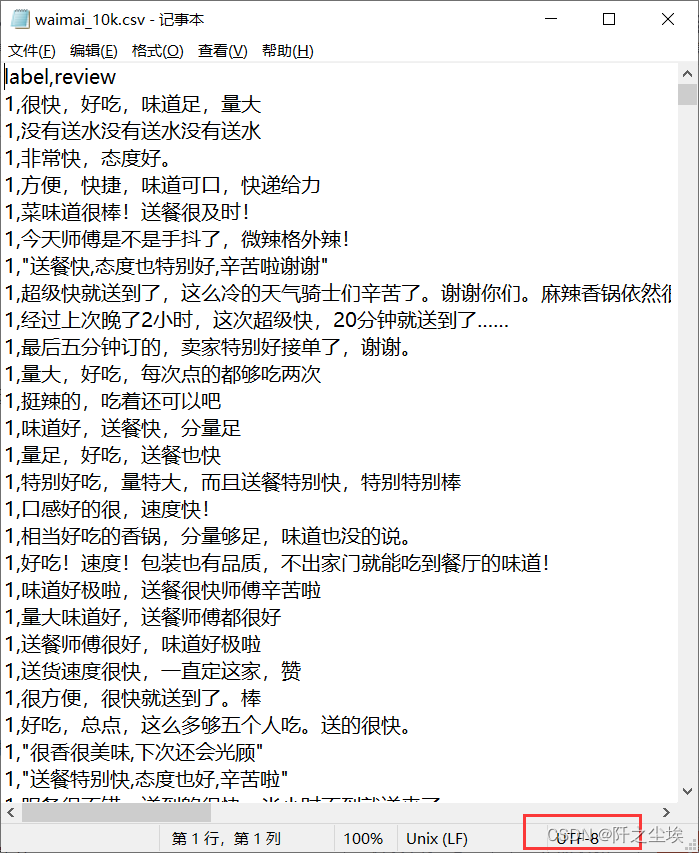

这是因为excel打开csv文件的时候用的编码方式不对,如果我们使用记事本打开csv文件会看到是正常的,而且下面的角标会告诉我们编码方式:

这个文件的编码是uft-8。

当然还有很多别的编码方式比如‘gbk’,‘ASCII ’等等,如果文件的来源不统一,并且数量很多的时候我们不能很方便用记事本去一一查看,就应该使用Python来进行编码方式的获取。

代码演示

本次主要依赖这个包:chardet,它可以探测文件的编码方法,并且给出把握概率。

这里打开3个文件,为了区别,我使用了csv,xlsx,txt三种不同的文件,然后获取他们的编码方式。

#查看编码

import chardet

with open ('waimai_10k.csv','rb') as f:

f1=f.read()

print(chardet.detect(f1))

with open ('stopwords.txt','rb') as f:

f3=f.read()

print(chardet.detect(f3)['encoding'])

with open ('外卖.xlsx','rb') as f:

f2=f.read()

print(chardet.detect(f2).get('encoding'))运行结果

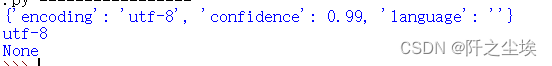

可以看到 在文件read()之后使用chardet.detect()函数会返回一个字典,给出了文件的编码方式和置信水平。

我上面的两个文件都是uft-8编码,第三个文件是none,应该是这个Python自带的读取方式打不开excel文件.....所以就读不出来编码。

目前来看chardet.detect()应该堆文本类型文件都能使用。

批量处理文件的编码方式,可以使用os包返回目录下的所有文件,然后再去循环一个个读取编码方式。

之后就一一对应,可以使用正确的编码方式进行文件读取啦。