论文: A Survey on LLM-as-a-Judge

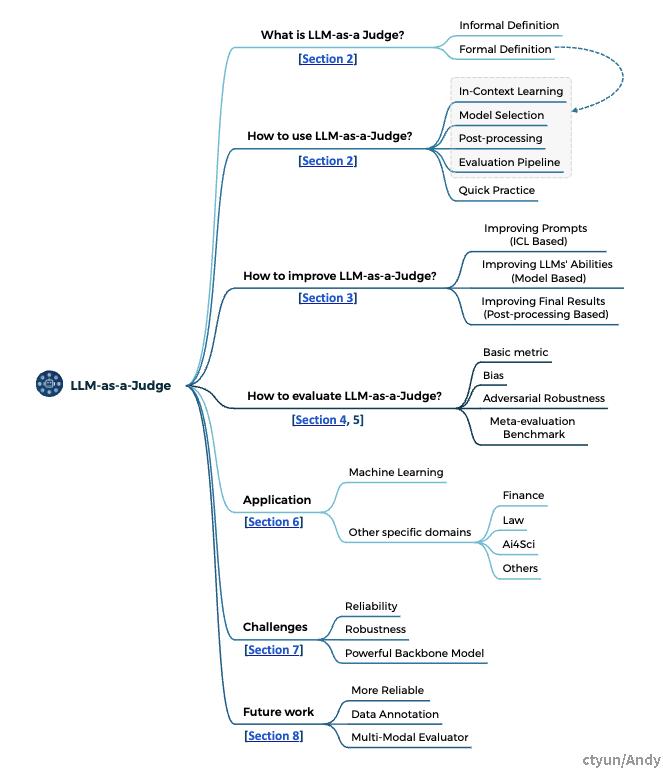

大纲结构

1.1 大纲

- 引言

- 描述LLM-as-a-Judge的背景和意义。

- 背景与方法

- 提供LLM-as-a-Judge的定义和核心原理。

- 提升策略

- 通过提示优化和模型调优提升LLM评估能力。

- 基准评价

- 系统分析评价基准的设计原则和应用。

- 偏差与鲁棒性

- 识别并解决LLM评估中的偏差与鲁棒性问题。

- 实际应用

- 探讨LLM-as-a-Judge在实际场景中的应用。

- 挑战与未来方向

- 分析现有挑战并展望未来发展方向。

1.2 逻辑脉络

论文从背景引出LLM-as-a-Judge的概念,通过定义、提升策略和评价基准探讨该方法的核心价值,接着分析偏差与鲁棒性对实际应用的影响,最后提出未来研究的方向。

2 分析

这篇综述的核心调研问题是:如何构建可靠的LLM-as-a-Judge系统?由此展开以下两方面的论述:

- 提升LLM-as-a-Judge的策略

- 评估LLM-as-a-Judge系统本身可靠性的方法论

对于提升LLM-as-a-Judge可靠性的第一个方面,作者回顾了旨在优化其在多样化评估任务中表现的主要策略。这些策略包括提高一致性、减轻偏见和提高对不同评估场景的适应性。

对于第二个方面,作者检验了用于评估LLM-as-a-Judge系统性能的指标、数据集和方法论,讨论了潜在的偏见来源和相应的缓解技术。在此基础上,作者引入了一个专为LLM-as-a-Judge评估设计的新型基准测试。利用已建立的指标和数据集,这个基准测试提供了一个框架,用于分析各种可靠性增强策略的有效性。

Part 1:引言

- 核心观点:

- 本部分引出LLM-as-a-Judge的背景,强调其作为一种解决传统评估方法局限性的潜力。

- 提出LLM-as-a-Judge是一种可以通过语言模型实现动态、准确、和成本效益较高的评价方式。

- 详细要点:

- 传统方法的局限性:

- 人工评估:

- 缺点:成本高(需要专家参与),时间长(多轮评估),一致性差(受主观因素影响)。

- 自动化方法:---> 难以捕捉语义深度或上下文关联

- 问题:传统指标如BLEU、ROUGE等局限于词汇匹配,无法反映复杂生成任务中的质量。

- 人工评估:

- LLM的优势: ---> 能在多模态、多任务和动态环境中提供相对一致且高效的评估

- 大规模处理能力,能够快速适应不同场景。

- 灵活性:支持文本、半结构化数据和多模态内容。

- 提供定性和定量结合的评估。

- 传统方法的局限性:

Part 2:背景与方法

- 详细要点:

- 定义:

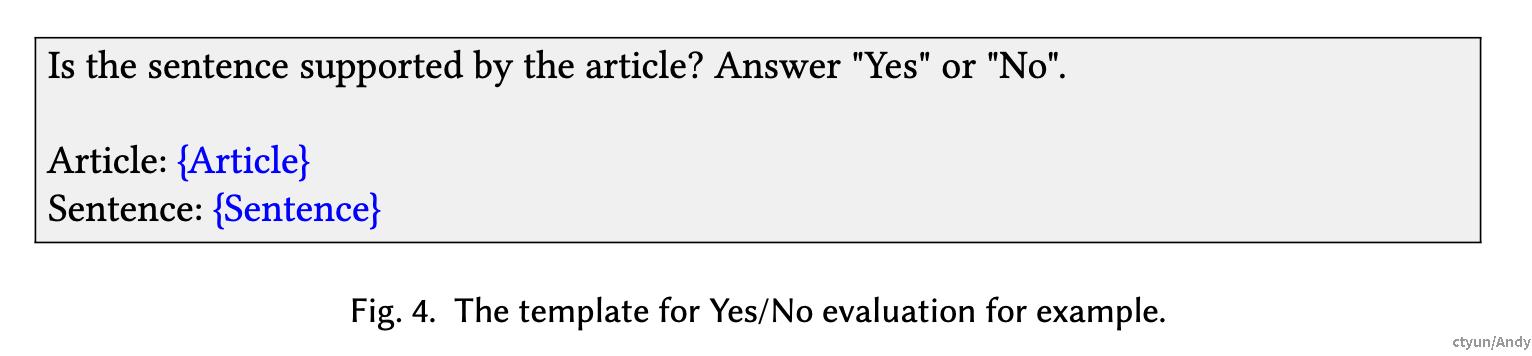

- 通过上下文提示(Prompt & Context)和输入(Input)生成评估结果。

- 评估结果形式包括评分(分数)、选择(选项)和比较(对比)。

- 主要流程:

- 输入设计:包括任务类型(如文本、图像)和评估方式。

- 提示生成:通过少样本学习或多轮交互引导模型生成精准评估。

- 模型选择:使用预训练模型或经过微调的专用模型。

- 形式化表达:

- E←P_{LLM}(x⊕C) :其中,E 为评估结果,x为输入数据,C 为结合prompt/历史信息的上下文提示。 P_{LLM} 是由相应LLM定义的概率函数,其生成是一个自回归过程。 ⊕ **组合操作符将输入𝑥与上下文C结合起来,这个操作可以根据上下文的不同而变化,比如可以放在开始、中间或末尾。

- 定义:

- 应用LLM-as-a-Judge

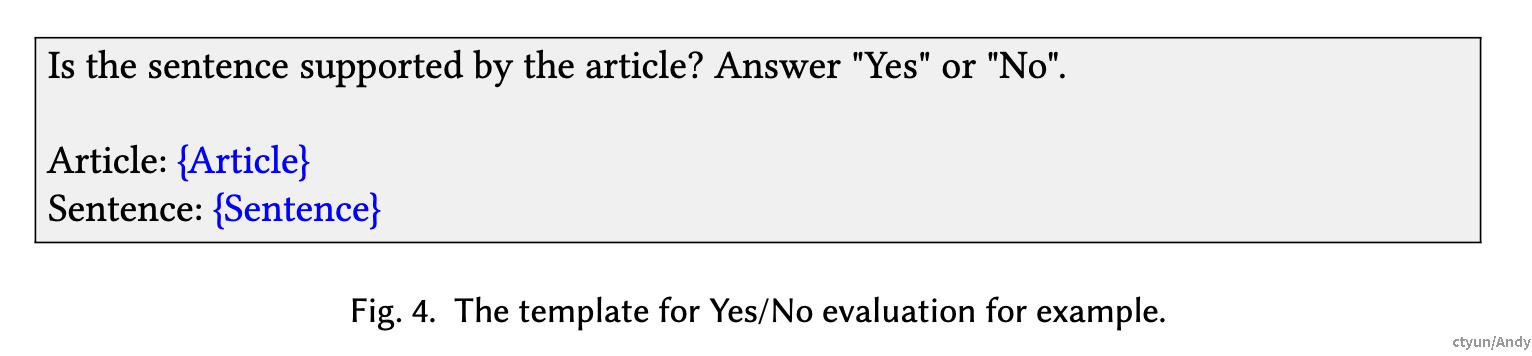

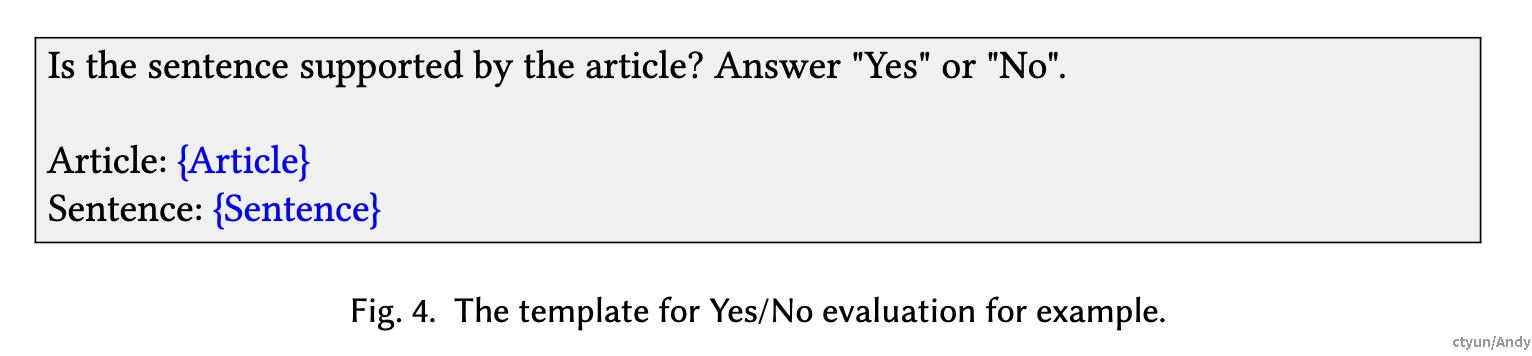

这个过程涉及两个关键方面:提示prompt的设计和输入的设计。

对于输入设计,重要的是考虑要评估的变量类型(如文本、图像或视频)、输入的方式(例如,单独、成对或批量)以及输入的位置(例如,在开始、中间或末尾)。

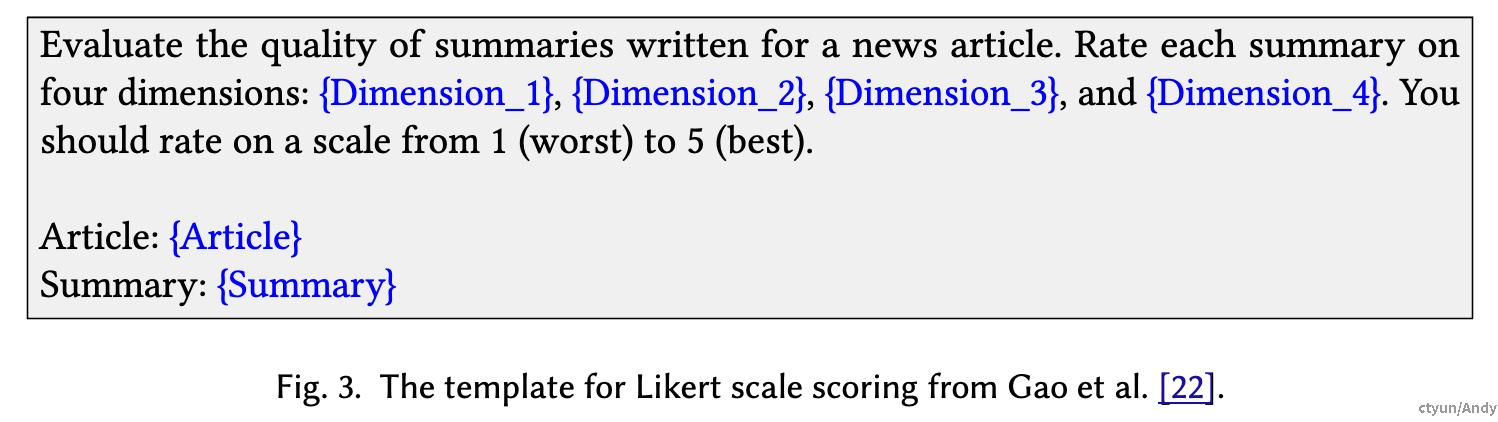

至于Prompt设计,可以采用四种不同的方法:包括生成分数、解决真/假问题、进行成对(Pairwise)比较和进行多项选择(Making multiple-choice selections)。

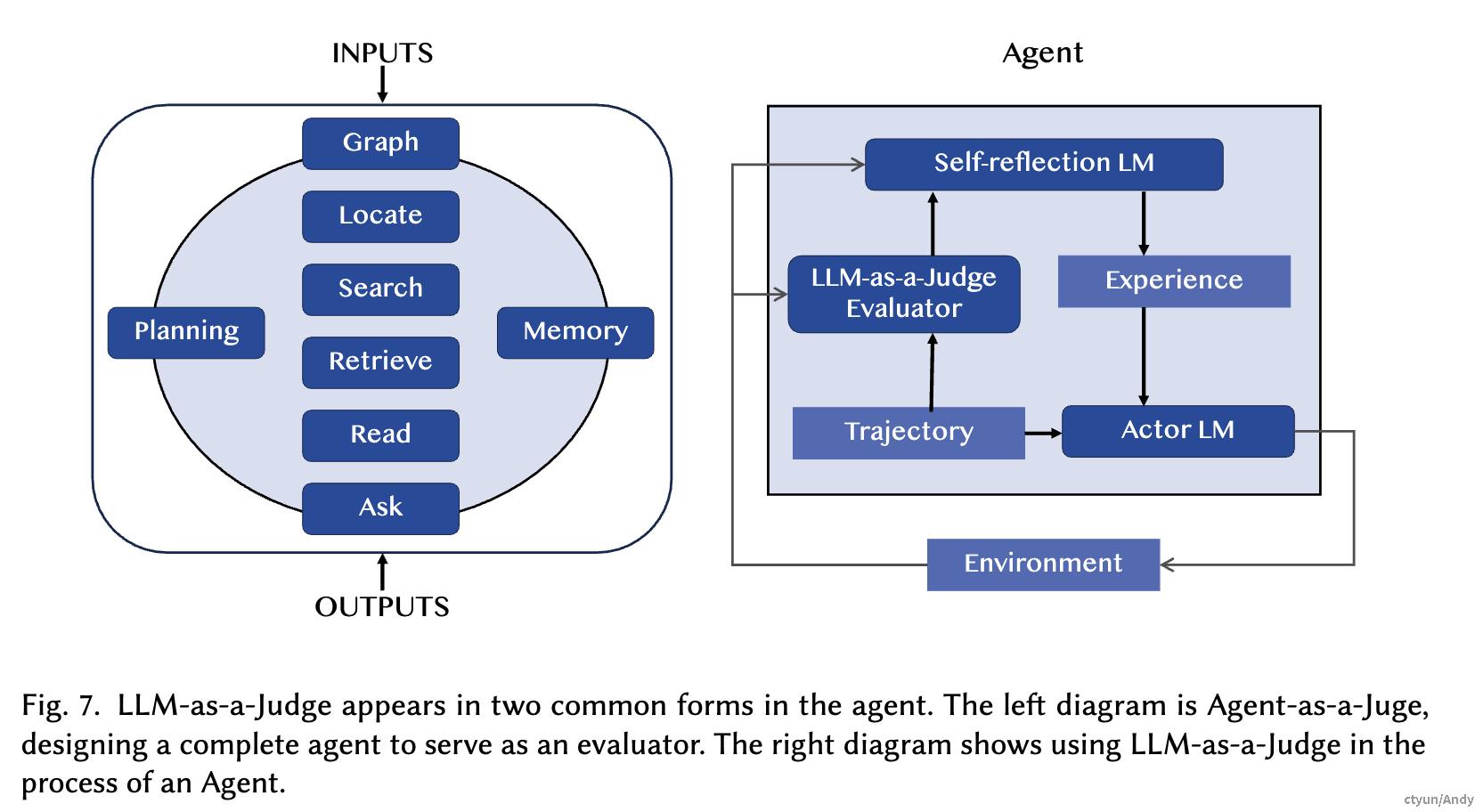

- LLM-as-a-Judge在agent场景使用

应用LLM-as-a-Judge有两种方式。一种是评估智能agent的整体过程,另一种是在代理框架过程中的特定阶段进行评估。这两种方法都在下图中有简要说明。将LLM作为agent的大脑,agent系统可以像人类一样进行评估,这将极大减少人类参与的需求。此外,agent可以通过语言与环境互动,并通过LLM接收对行动的反馈,以做出下一个行动的决策。

Part 3:提升策略

通过优化Prompt设计和调优技术提升LLM-as-a-Judge的评估性能。

- 详细要点:

- 提示Prompt设计:

- 少样本学习(Few-shot prompting):

- 提供高质量示例帮助模型理解任务。

- 任务分解(Decomposition):

- 将复杂任务分解为更细粒度的子任务。

- 少样本学习(Few-shot prompting):

- 提示Prompt设计:

评估标准的分解涉及将粗略的评估标准如流畅性分解为更细粒度的子标准,如语法、吸引力和可读性,然后基于这些不同的维度生成总体分数。

偏差校正(Bias correction):针对常见偏差(如位置偏差)调整提示内容。

一些研究工作通过随机交换待评估的内容来优化提示设计。

- Wang等人分析并验证了位置偏见对LLM-as-a-Judge的影响,并提出了一个校准框架,通过交换内容并平均分数来减轻这种偏见。Auto-J和JudgeLM也通过打乱待评估的文本来增强评估的一致性。

- 与平均分数相比,PandaLM在交换后将冲突的评估结果标注为“平局”,以解决位置偏见。

2. 调优技术:微调(Fine-tuning):通过特定数据集调整模型权重,减少系统性错误。

提高LLM评估能力的直接方法是通过特别为评估任务构建的元评估数据集对它们进行微调,这有助于提高LLM对特定评估提示的理解,提升评估性能或解决潜在偏见。

一种常见的方法包括从公开可用的数据集中抽样评估问题,使用特定模板对它们进行修改,并用手动或像GPT4这样的强大LLM生成的评估响应来补充数据集。例如:PandaLM从Alpaca 52K中采样输入和指令,并使用GPT-3.5生成响应来构建训练数据,

反馈优化(Feedback-based): 结合人类反馈动态调整模型性能。

JADE中的LLM评估器依赖于人类评委来纠正LLMs的评估结果,并将最常被纠正的样本更新到示例集中进行少量样本提示。JADE利用这种相对低成本的方法实现评估能力的迭代更新。

3. 输出约束:使用结构化格式(如JSON或模板化输出)提升结果的可解释性和一致性。

直接要求LLM-as-a-Judge评估器输出评估结果会面临鲁棒性问题。由于LLM固有的生成随机性,响应文本可能会意外变化,例如在被要求用离散分数衡量时输出“低相关性”这样的文本,这阻碍了从LLM输出中自动且准确地提取评估结果。增强输出形式鲁棒性的有效方法是在提示中以结构化格式限制LLM的输出。

Part 4:基准评价

- 核心观点:

- 构建标准化的评价基准,用于衡量LLM-as-a-Judge的性能。

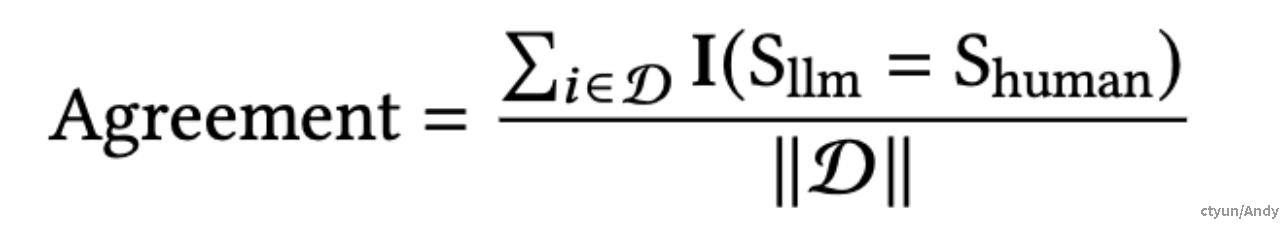

- 通过与人类判断的对齐度(如百分比一致性)评估:

- 详细要点:

- 评价原则:

- 全面性:覆盖多种任务类型(如文本生成、对话)。

- 细粒度:捕捉任务中不同维度(如有用性、可靠性)的表现。

- 可扩展性:支持添加新任务或属性。

- 典型基准:

- MT-Bench:专注于多任务评价。

- EvalBiasBench:针对偏差的评估测试。

- LLMEval2:覆盖多种数据源,注重人类对齐。

- 评价指标:

- 准确性(Accuracy):与人类评估的一致性。

- 偏差(Bias):评估位置、长度等可能影响结果的因素。

- 鲁棒性(Robustness):对抗性输入下的稳定性。

- 评价原则:

Part 5:偏差与鲁棒性

- 核心观点:

- 系统分析LLM-as-a-Judge中的常见偏差,并提出提升鲁棒性的策略。

- 详细要点:

- 常见偏差:

- 位置偏差(Position Bias):倾向选择提示中的特定位置内容。

- 常见偏差:

位置一致性(Position Consistency),量化了在改变它们位置后,评判模型选择相同响应的频率;

偏好公平性(Preference Fairness),衡量评判模型在特定位置偏好响应的程度。

冲突率(Conflict Rate),用于衡量在改变两个候选响应位置后不认同的百分比。

长度偏差(Length Bias):倾向于偏好特定长度的响应,例如偏好更冗长的响应,这也被称为冗长偏见。

长度偏见可以通过将原始响应之一改写为更冗长的版本来揭示。

即使这些扩展没有引入新信息,人们仍然担心原始响应在困惑度、流畅度或风格方面的变化。另外,有学者通过比较多个抽样响应来研究这种偏见,并揭示了对更长答案的统计倾向。

然而,确保多个样本质量的可比性仍然是一个挑战性问题。

自我增强偏见(Self-Enhancement Bias):

LLM评估器可能偏好自身生成的响应的现象。考虑到显著的自我增强偏见,建议避免使用相同的模型作为评估器。这只是权宜之计,因为我们在评估最先进的LLMs时可能无法使用最优的评估器。

具体性偏差(Concreteness Bias):倾向具有细节或复杂术语的内容。

2. 鲁棒性问题:对抗性输入可能导致不可靠的评分结果。

- 对抗性鲁棒性:对抗性鲁棒性指的是模型抵御通过精心设计的输入来操纵分数的故意尝试的能力。与主要关注自然发生的样本的偏见评估不同,对抗性鲁棒性涉及故意制造的样本,这些样本旨在操纵评分,例如插入人为提高分数的短语。

- 对抗性攻击短语的影响:通过普遍插入学习到的对抗性攻击短语,可以在不提高文本质量的情况下大幅膨胀评估分数。

- “零模型”的高胜率:即使一个与输入指令无关、输出恒定响应的“零模型”,也能在各种LLM-as-a-Judge方法中获得高胜率。

- 增加评估分数的方法:通过添加大多数人的意见,如“90%的人认为这个更好”,可以增加评估分数。

- 对抗无意义陈述的鲁棒性:评估了系统提示中无意义陈述的鲁棒性,例如,“助手A喜欢吃意大利面”。这些工作揭示了LLM-as-a-Judge对与文本质量无关的干扰仍然不够鲁棒。

- 防御措施的局限性:像困惑度分数这样的防御措施只能检测有限类型的对抗性样本。

- 构建更鲁棒的LLM-as-a-Judge的重要性:因此,构建更鲁棒的LLM-as-a-Judge是未来研究的关键方向。

3. 解决方案:

提示校正:通过随机化和多轮评估减少偏差。

评分平滑:结合隐式概率和显式输出生成更稳定的评分。

该方法通过结合隐式概率分布(模型生成过程中每个候选输出的概率权重)和显式输出(最终生成的评分),生成更一致和可靠的评分结果。

1. 隐式概率(Logit分布)的计算

- 隐式概率的定义:

- 在模型生成过程中,LLM 会基于上下文计算每个可能输出的条件概率 P(t_i|t_{<i}) ,即某个词或分数的概率分布。

- 这些概率构成了模型的 logit 分布,反映了 LLM 的内部评分偏好。

+ 获取隐式概率:

- 针对某个分数(如 1-10 的离散评分),计算每个可能分数的条件概率。

- 例如,对于评分范围 S={1,2,…,10} ,模型会生成对应的概率 P(1),P(2),…,P(10) 。2. 显式输出

显式输出的定义:

- LLM 在生成评分时直接输出的分数,比如 "The score is 7"。

- 显式输出是最终呈现给用户的结果,但可能由于生成随机性导致结果波动。3. 评分平滑策略

核心思想

- 利用隐式概率分布 P(t_i|t_{<i}) 和显式评分 S_{\text{explicit}} ,计算加权平滑后的最终评分 S_{\text{final}} 。

- 将隐式概率看作显式评分的权重,以减少单一生成过程中的随机性影响。公式表示:

S_{final} = \sum_{i \in S} P(i) \cdot i

- P(i) :隐式概率分布中的概率值。

- i :可能的评分值。

- S_{\text{final}} :平滑后的最终评分。

+ 操作步骤:

1. 模型生成显式评分结果(如 7)。

2. 从隐式概率分布中提取各评分的权重(如 7 的概率为 0.6,6 的概率0.3,8的概率为 0.1)。

3. 将显式评分 SexplicitSexplicit 融合概率权重生成最终平滑评分 S_{\text{final}} 。

Part 6:实际应用

讨论LLM-as-a-Judge在学术、工业和多模态领域的具体应用。

- 详细要点:

- 学术评估:

- 自动化审稿,提高效率和一致性。

- 用于教育场景下的考试评分。

- 工业应用:

- 内容生成质量控制。

- 产品推荐和用户反馈分析。

- 多模态扩展:

- 处理图文结合任务,如视觉-语言对齐。

- 学术评估:

Part 7:挑战与未来方向

- 当前挑战:

- 偏差问题仍难以完全消除。

- 动态场景下的实时评估适应性不足。

- 未来方向:

- 开发多模态评估框架。

- 探索人机协作的评估模式。

- 设计更全面的基准和更鲁棒的模型。