论文背景:大语言模型的幻觉问题与RAG系统

大语言模型(LLMs)近年来在自然语言处理(NLP)任务上取得了巨大成功,但它们在生成信息时仍然存在“幻觉”(hallucination)问题,也就是生成与事实不符的内容。这对实际应用(如医疗、金融或法律等领域)带来了极大的挑战,因为这些领域对信息准确性的要求非常高。

为了减少这种幻觉现象,来自清华大学、北京师范大学和中科院的研究团队提出了RAG评估系统新范式。RAG(Retrieval-Augmented Generation)通过在生成文本之前先检索相关资料,从而提供更加可靠的知识来源。尽管如此,现有的RAG评估基准主要针对开放域问题,无法很好地评估垂直领域(如医疗、法律等)中的模型表现。对此,研究人员提出新型RAGEval评测框架。

RAGEval框架的创新之处

-

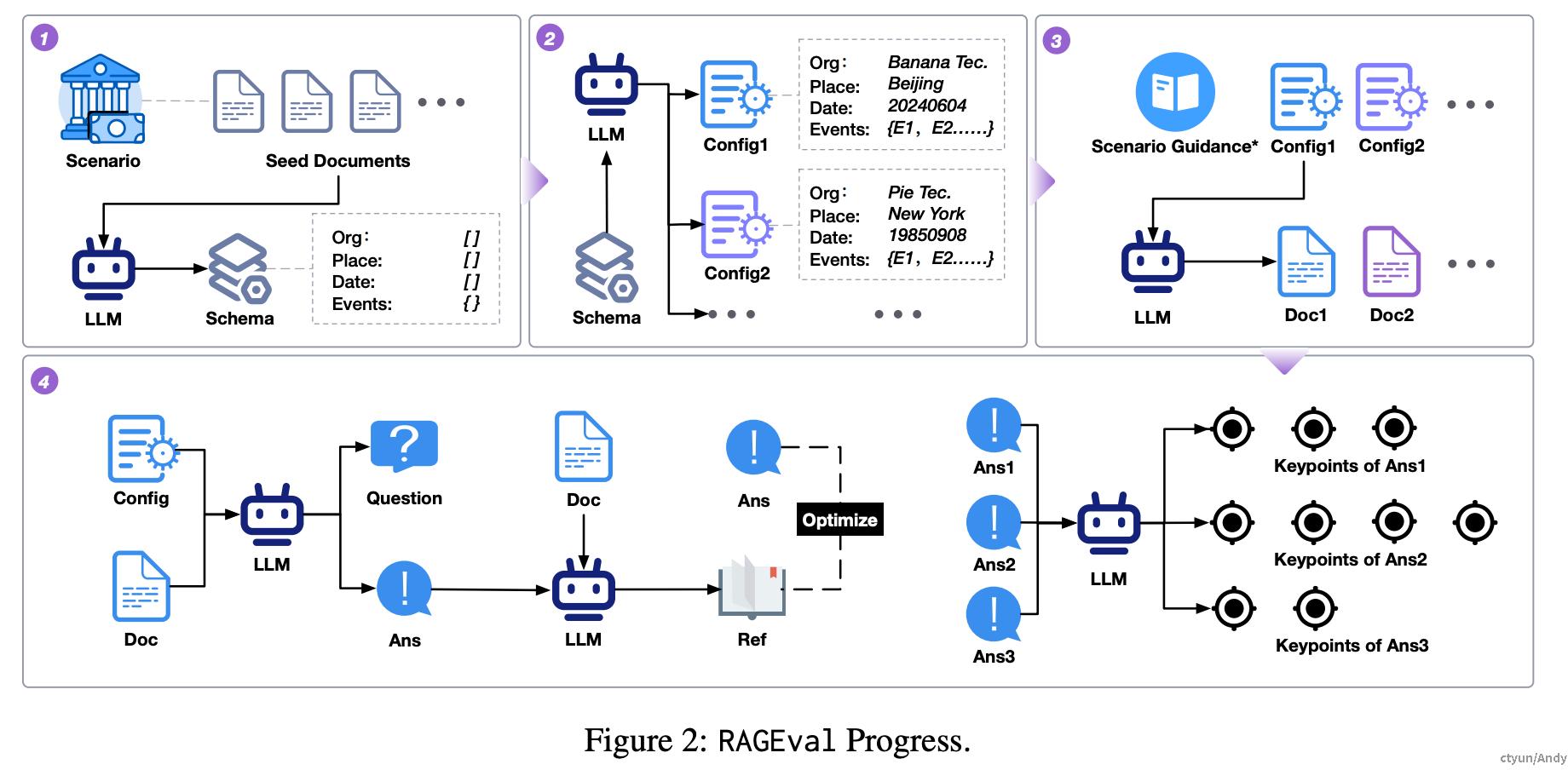

自动化生成场景特定评估数据集 RAGEval能够针对不同领域自动生成评估数据集。通过分析少量领域特定文档,RAGEval总结出一个“模式”(schema),并根据该模式生成多样化的文档配置。最终,框架根据这些配置生成问题和对应的答案对,用于评估RAG系统的知识使用能力。

举例说明:假设我们想评估RAG系统在金融领域的表现。RAGEval可以先从少量金融报告中提取出关键的结构化信息,比如公司名称、财务日期、关键事件等。随后,它会自动生成虚拟的财务报告和问题,比如“该公司在2023年的净利润是多少?”。通过这样的自动化过程,评估的内容可以更具领域针对性和多样性。

-

三大新评估指标 RAGEval引入了三个新指标来更精准地评估模型生成的回答质量:

- 完整性(Completeness):回答是否涵盖了问题中的所有关键信息。

- 幻觉(Hallucination):回答是否包含虚假或错误信息。

- 无关性(Irrelevance):回答中是否包含不相关的信息。

创新意义:这些指标克服了传统评估方式(如BLEU或ROUGE)无法捕捉生成内容质量的不足,能够更好地衡量模型生成的答案是否准确、可靠,特别是在高度专业化的领域中。

详细实现:从生成到评估

- 模式总结与文档生成 \RAGEval从领域内少量文档中提取出领域特定的模式。模式总结的核心目标是确保生成的文档具备高度一致性和真实性,特别是在金融或医疗这样的高度结构化领域。

例子:在金融领域,RAGEval可以总结出“公司名称”、“年度报告日期”、“关键财务数据”等结构化信息。这些信息作为“配置”,用于生成虚拟的财务报告,这样模型在回答时可以模拟真实世界的企业场景。 - 问答对生成 RAGEval使用生成的虚拟文档创建各种类型的问答对,包括简单事实性问题、跨文档推理问题以及总结类问题。框架通过多种类型的提问来全面测试模型的检索与生成能力。

例子:假设模型需要从一份虚拟生成的财务报告中回答类似“该公司在2024年收购了哪家企业?”的问题,RAGEval不仅要评估模型是否能从检索文档中找到正确答案,还要看模型回答是否准确无误。 - 评估模型的生成表现 RAGEval提出了新的评估标准,特别是通过“完整性”、“幻觉”和“无关性”三大指标,精确分析模型在生成内容时的表现。这不仅能够评估模型是否生成了与问题相关的内容,还可以进一步判断生成的答案是否准确无误。

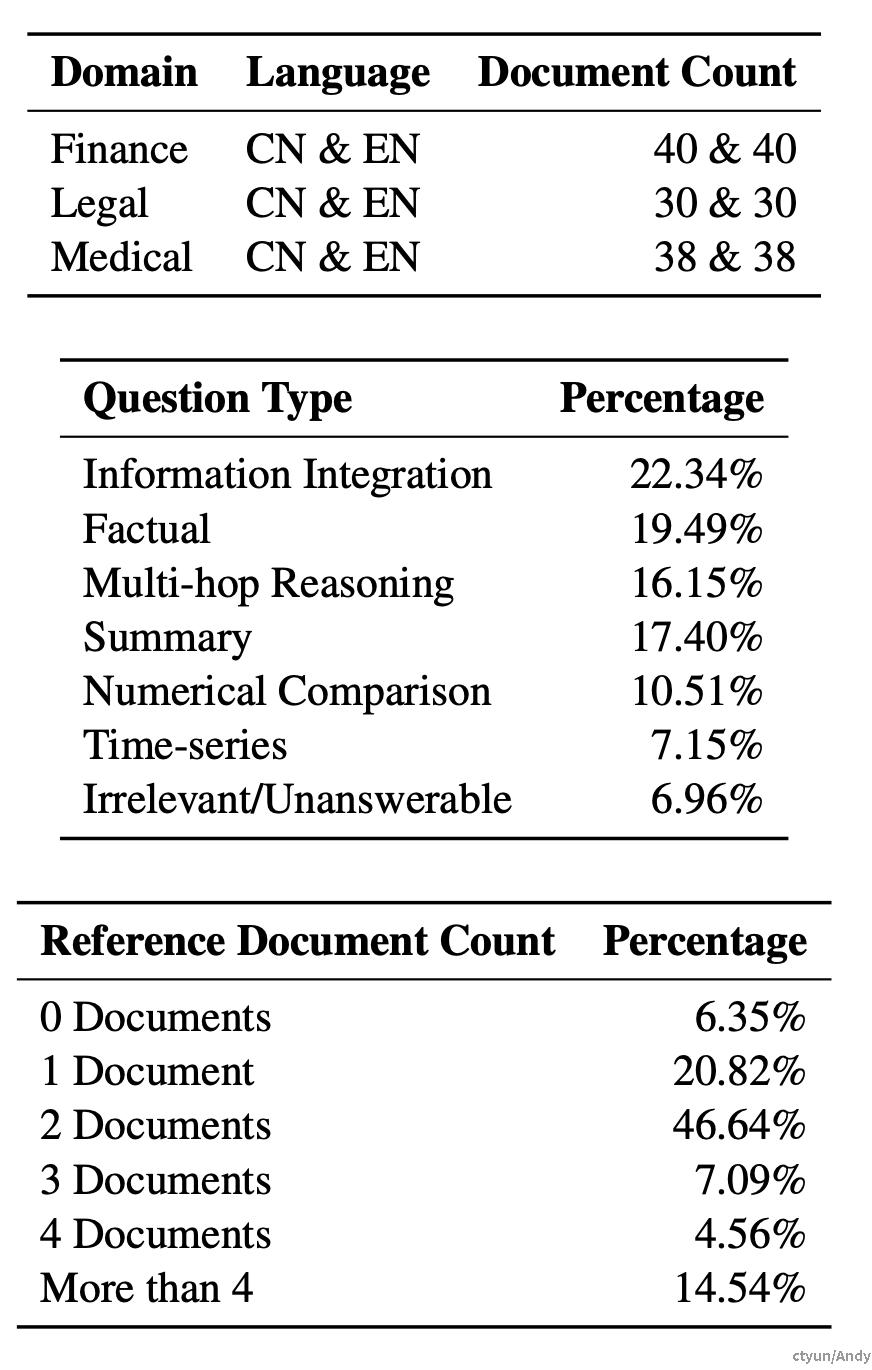

DRAGONBall数据集

RAGEval框架生成了一个名为DRAGONBall的数据集,涵盖了金融、法律和医疗等垂直领域,支持中文和英文的多语言评估。该数据集不仅包含结构化的领域文档,还包括大量的问答对,使得RAG系统的评估更加全面。

- 多语言支持:DRAGONBall数据集支持中文和英文的双语问答,确保了跨语言的广泛适用性。

- 多领域覆盖:数据集覆盖了从金融报表、法律案例到医疗记录等多个领域,为模型的多领域泛化能力提供了丰富的测试场景。

以下是DRAGONBall数据集的相关指标

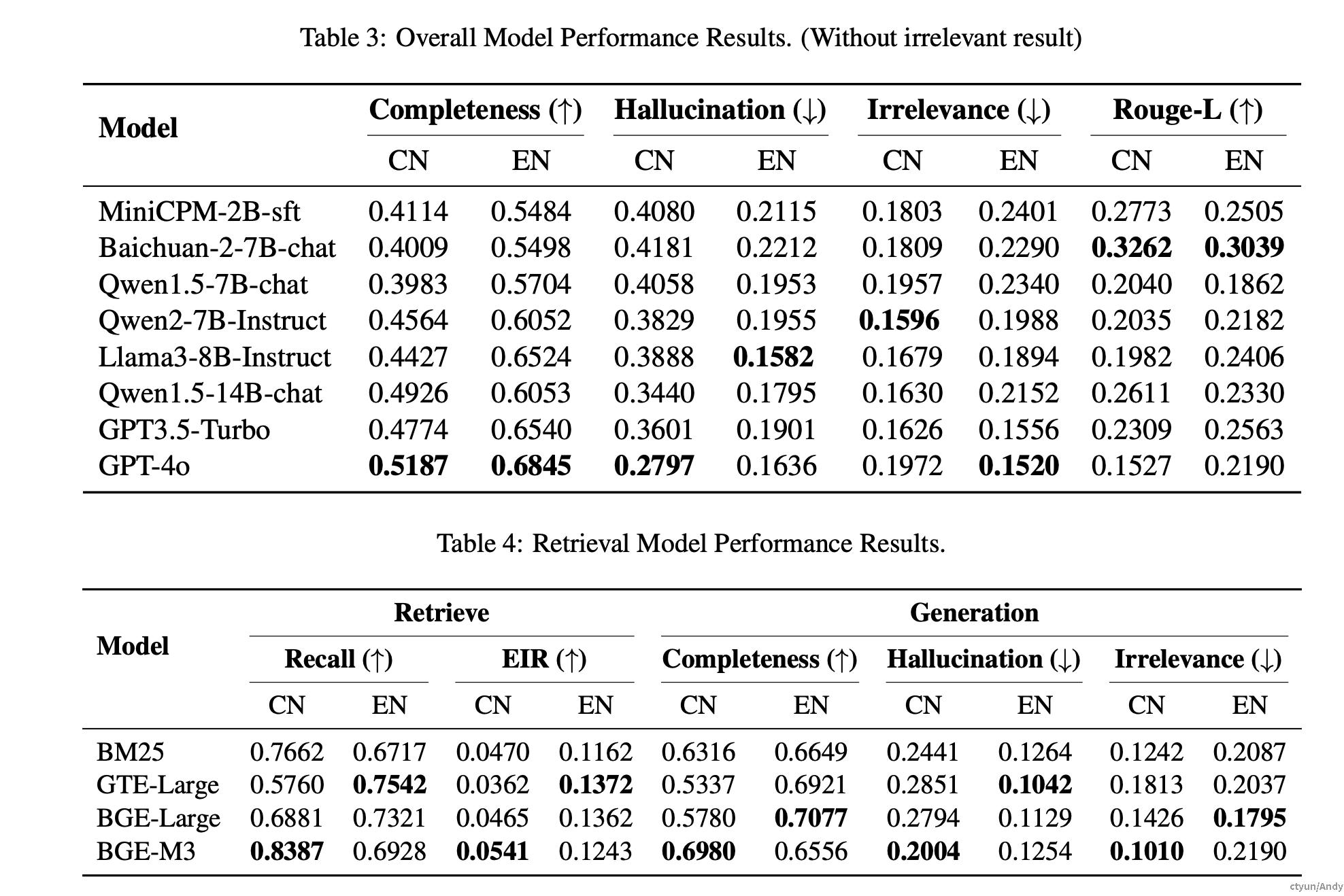

实验与结果

论文中对多个主流的生成模型(如GPT-4、Baichuan、MiniCPM等)进行了对比实验,发现尽管GPT-4表现最佳,但开源模型的表现逐渐接近。这意味着开源模型在RAG任务中的潜力巨大,未来有望缩小与闭源模型的差距。

- 实验中的相关结论:

- 小参数量的模型,如MiniCPM,在特定场景下可以表现出色,特别是在中文领域中与更大参数的模型相比几乎不落下风。

- GPT-4在RAG场景下的性能最佳,尤其是在完整性和幻觉控制方面表现突出,但在某些情况下,与Baichuan等开源模型的性能差距并不显著。

- 提高TopK检索数量和调整文本块大小能够显著改善模型的回答质量,这说明RAG系统中的检索阶段对最终的生成结果影响巨大。

对行业的影响与应用场景

- 金融领域 RAGEval能够生成真实感极强的虚拟财务报告,并通过相关的问答对来测试模型在财务分析、企业报告解读等任务上的能力。对金融从业者来说,这样的评估框架能够帮助他们挑选更精准的AI工具来辅助决策。

- 医疗领域 医疗领域的文本高度专业化,任何幻觉或错误信息可能导致严重后果。RAGEval框架通过严格的评估和问答对,能够有效测试医疗领域生成模型的准确性,为智能诊断、医疗记录分析等应用场景提供了技术保障。

- 法律领域 生成法律文书或解读法律条文需要高度的准确性。RAGEval框架通过生成高质量的法律案例和判决文书,帮助评估模型在法律领域的实际应用潜力,未来可以应用于智能法律咨询、合规审查等方面。

总结

RAGEval提供了一个创新且系统化的框架,帮助我们更好地评估RAG模型在特定领域中的表现。通过新引入的评估指标和生成的数据集,研究人员和从业者可以在实际场景中更精准地测试和优化他们的AI模型。RAGEval框架展示了在减少大语言模型“幻觉”问题方面的潜力,并为AI在垂直行业中的应用指明了方向。

这个研究不仅一定程度填补了当前RAG系统评估中的空白,还为进一步在金融、法律、医疗等领域部署更可靠的AI系统奠定了一定的评测基础。**