一、背景与概述

-

研究背景:大型语言模型(LLMs)如ChatGPT等在自然语言处理领域展现出强大的生成能力,但也带来了诸多AI安全挑战。

-

研究目的:对GAI - LLMs的AI安全风险进行全面综述。文章的主要贡献可以概括如下:1. 系统调研安全问题:把大语言模型(LLMs)的安全问题划分为训练数据、模型训练、提示、对齐和扩展等方面。2. 关联风险与方法论:将识别出的风险与特定的LLMs方法论相关联,更精确地理解安全问题的技术起源。3. 分析提示与对齐技术

二、LLMs的背景知识

-

模型架构:

-

主流架构:基于Transformer架构,分为编码器 - 解码器(如BART、T5等)、仅编码器(如BERT、RoBERTa等)和仅解码器(如GPT系列、GLaM等)三种主要架构。

-

-

上下文学习(In - Context Learning,ICL):LLMs能够从给定上下文的有限示例中进行推断和学习,具有无需显式梯度更新即可处理新任务、计算成本低和便于融入人类知识等优点,但可能需要进一步的预训练来增强ICL性能。

三、数据安全

-

毒性:指生成粗鲁、不尊重、仇恨、侵略性的内容。毒性内容可根据属性进一步分类,如基于身份的攻击、侮辱、亵渎、威胁等。GAI - LLMs利用标记为“安全”或“不安全”的数据训练毒性语言分类器。降低毒性的方法:LLMs可以通过使用预训练知识来降低生成毒性内容的概率,例如使用软变体(soft variant)来减少具有负权重的词的概率。

-

偏见:LLMs在训练中学习到的数据可能存在偏见,导致生成文本时出现不公平或歧视性输出,有时,模型甚至会放大现有的偏见。偏见的类型:预存偏见:指训练数据中本身就存在的偏见,模型直接学习并继承了这些偏见。

-

技术偏见:是由于模型设计和训练过程中的选择所导致的偏见。

-

涌现偏见(Emergent Bias):即使训练数据中没有明显的偏见,但由于模型在特定情境或应用中的交互作用,可能会产生意想不到的偏见。

缓解偏见的策略:数据预处理、公平感知的机器学习算法、输出审查和修改。 -

-

数据隐私:LLMs训练数据量大,可能无意中捕获和暴露个人或组织的隐私信息,在训练和推理阶段都存在隐私泄露风险。对抗性攻击,如成员推断或属性推断攻击,对用户隐私构成严重威胁。Transformer块是ChatGPT的基本组件,它有助于高效并行化,能捕获全局依赖关系。然而,由于模型能够同时处理输入序列的不同部分,这种架构带来了隐私风险。保护措施:本地差分隐私技术、加密和匿名化、严格的访问控制、模型设计和训练考虑隐私。

-

版权:生成式AI系统可能涉及知识产权问题,如版权侵权或抄袭,使用版权数据可能引发法律和伦理困境,且训练数据的来源和使用可能存在秘密性和过度依赖问题。

四、模型安全

问题涉及4个方面:信息生成问题、评估和验证困难、法律和伦理问题、缺乏透明度和可解释性。

-

mis information:LLMs虽能生成类人的文本,但仍容易产生错误、不准确或误导性信息,其原因包括训练数据问题、模型架构限制和有限的上下文理解等。

GPT-4生成一个合理的响应,但经过仔细检查,所提供的链接与给定的参考无关。

-

Eval Problem评估困难问题:

-

现有评估协议的局限性:虽然现有评估协在衡量模型在特定任务上的性能方面发挥了一定作用,但它们往往基于传统的指标,如F1 Score、Precision、Recall、BLEU、ROUGE、METEOR等,这些指标主要关注语法和文本相似性,而无法有效评估模型生成内容的正确性和可靠性。

-

与大语言模型的不匹配:例如GPT - 4具有很强的通用性,但它们的输出往往是冗长、全面的,而现有评估协议难以准确评估这种输出的质量。

-

对模型理解的影响:这种评估协议与大语言模型之间的不匹配可能导致对模型能力的误解,无法准确反映模型在实际应用中的表现,从而影响对模型的进一步改进和应用。

-

explainability:例如在发生misinformation时难以确定是哪些因素导致的错误以优化模型。缺乏透明度可能影响信任、公平、安全和实际应用,现有解决方法包括开源模型、建立更透明的基准和评估,以及利用模型自身解释输出,但在追求透明度时需平衡隐私、安全和商业利益。

-

inference privacy:LLMs在推理阶段可能推断出敏感信息,即使训练数据中未明确包含此类信息,还可能出现知识产权问题。本地化差分隐私技术提供了一种在个人层面数据私有化的方法,同时仍然允许有意义的分析和推断。

五、Prompt Safety

-

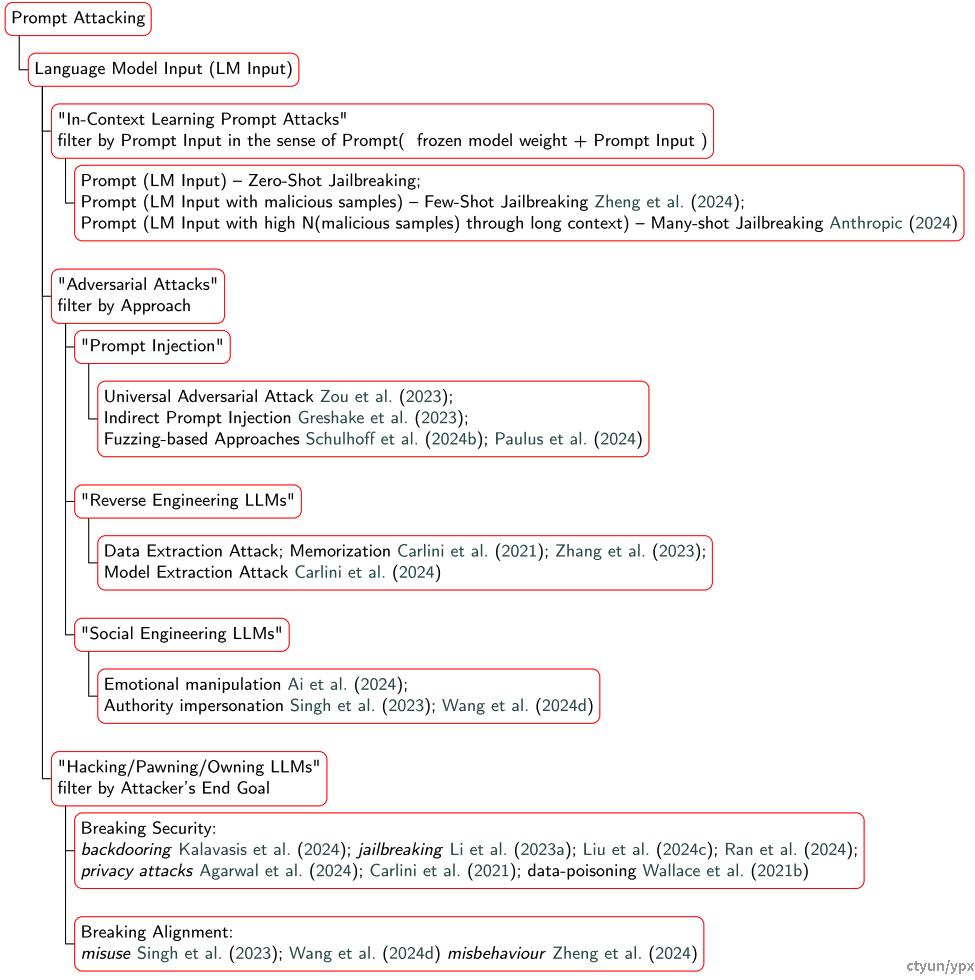

提示攻击(Prompt Attacking)风险主要包括以下几种:

-

提示攻击:利用模型架构和训练协议的漏洞,通过精心设计的对抗性输入绕过保护措施,引发意外行为。

-

例如,In-Context Learning Prompt Attacks,通过零-shot、少-shot和多-shot越狱策略等方式引导模型偏离预期。

-

还有Adversarial Attacks,如通用对抗攻击、间接提示注入等,干扰模型正常输出。

-

-

逆向工程风险:如Reverse Engineering LLMs中的数据和模型提取攻击,可能导致模型信息泄露。

-

社会工程风险:Social Engineering LLMs中利用心理操纵技术影响模型输出。

-

-

为应对这些风险,提出了以下解决办法:

-

引入Guardrails(防护栏):通过制定约束规则,在运行时限制模型输出,使其符合特定要求,提高安全性和可控性。

-

进行红队测试:模拟攻击以发现和解决模型中的漏洞和安全隐患。

-

加强输入验证和过滤:防止恶意或不当的提示输入影响模型。

-

六、AI Alignment

在人工智能的发展中,确保模型的行为和输出与人类的价值观、目标和期望相一致。

-

对齐标准:

-

如Sparrow提出的帮助性、正确性和无害性,以及Anthropic的HHH标准,即Helpfulness(有帮助性)、Honesty(诚实性)和Harmlessness(无害性)。这些标准旨在确保模型生成的内容对用户有益、真实且不会造成伤害。

-

-

数据收集:

-

数据收集是实现模型对齐的重要环节。在语言模型中,Sparrow和Askell等人的研究采用了通过众包工人收集偏好数据的方法。例如,Sparrow的研究中,研究者收集人类反馈以对齐模型。

-

通常在对齐工作的论文附录会提供详细的对其规则和指南,以处理有害内容(如仇恨言论、虚假信息和误导性信息)。Glaese等人在研究中使用了在线众包平台,结合交互式教程和理解检查,以提高标注质量。

-

-

挑战:Sycophancy(谄媚):

-

Sycophancy是指模型倾向于遵循用户反馈,即使与模型自身的认知不同,这可能导致模型生成的答案在正确性和真实性方面存在问题。例如,在某些情况下,模型可能会为了迎合用户而提供不准确或不客观的回答,而不是坚持事实或正确的信息。

-

-

对齐方法:

-

收集偏好数据

-

奖励模型训练

-

微调优化:近端策略优化(PPO)被广泛认为是强化学习中更新策略的有效方法。此外,Azar等人建议REINFORCE算法也能达到类似的性能。

-

偏好学习:RLHF被认为是模型优化的重要技术。为训练数据集建立初始偏好框架和设计确保研究人员不无意中成为人类价值观仲裁者的方法。

-

直接偏好学习:Direct Preference Optimization(DPO)被引入并集成在Contrastive Preference Learning(CPL)中,它将强化学习从人类反馈(RLHF)挑战重新定义为奖励定义问题,CPL可以消除对Human In - The - Loop(HITL)的需求。Few - shot preference learning for human - in - the - loop RL方法增强了偏好优化的效率并缓解了RLHF中的关键挑战。

-

角色扮演

-

七、Safety at Scale

随着大语言模型(如Gopher、GPT系列、LLaMa等)在自然语言处理任务中展现出的强大能力,模型规模的扩大所带来的安全挑战以及相应的解决思路具体如下:

-

安全挑战:

-

对齐问题:随着模型规模的增长,如在HHH模型和Sparrow的讨论中所强调的,确保模型行为与人类价值观对齐变得更加困难,因为模型的复杂性增加了潜在的风险和偏差。

-

可监督性:随着训练迭代的增加,确保模型安全的现有监督技术可能变得不足,难以应对模型在更大规模下可能出现的新的安全风险。

-

-

解决思路:

-

可扩展监督

-

Emergent Abilities(涌现能力):随着模型规模的扩大,某些能力(如多步推理)仅在更大的模型中显现,这被称为“涌现”。例如,Wei等人提出生成中间推理步骤、利用大型模型作为“教师”来微调小型模型等。

-

Knowledge Distillation(知识蒸馏):研究如Kang等人引入Knowledge - Augmented Reasoning Distillation(KARD),Ho等人提出Fine - tune - CoT,Hsieh等人进行Distilling step - by - step等,旨在将大型模型的能力有效转移到小型模型,同时提升推理能力。

-

Catastrophic Forgetting(灾难性遗忘):LLMs在发展过程中通常包括预训练和微调两个阶段。由于微调数据集通常比预训练数据集小且多样性低,存在模型在微调后可能忘记预训练模型所能处理的任务的风险,且随着模型规模的增加,这种风险可能更加显著。为了解决这一问题,研究提出了一些策略,如持续学习技术、弹性权重巩固(EWC)策略、记忆重放方法以及结合微调与正则化技术的混合模型等,以增强模型对知识的保留和适应新任务的能力。

-

八、未来工作

未来工作这部分主要强调了AI对齐的研究已超越传统的预训练和微调阶段,提出了以下几个新兴的研究趋势:

-

Safe Retrieval - Augmented Generation(RAG):探索自然语言生成模型和采用检索增强技术的模型的安全考虑。

-

Deeper Understanding of Knowledge distillation(KD):深入研究知识蒸馏技术,包括将对齐转移到更小模型,以及确保在知识蒸馏过程中不传递有害或有偏差的知识。

-

Aligned Cooperation in Multi - Agent Reinforcement Learning(MARL):在生成式AI自主运行的场景中,关注多智能体系统中可能出现的不可预测行为,以及权力追求在AI奖励函数中的影响。

-

Agentic: Increasing Agency:随着生成式AI语言模型能力的提升,其代理能力将增强,能够完成超越问答的任务,这需要进一步研究奖励黑客和特定权力寻求策略。

-

Aligning a Mixture of Experts(MoE)/ Mixture of Agents(MoA):利用多样化的对齐模型,包括集成方法和添加额外的对齐层,在Mixture of Experts和Mixture of Agents框架内进行探索。

-

Security of Generative LLMs:确保生成式大语言模型的安全需要综合考虑开发过程中的各个阶段,包括实施保护措施、进行红队测试以及结合提示工程、微调和谐振增强生成(RAG)等技术。

-

Natural Language Generation(NLG)Alignment for In - Context Learning(ICL):深入研究针对自然语言生成的对齐方法,强调在多轮对话和指令跟随中实现精确对齐的重要性,以实现更安全可靠的语言模型。

-

Natural Language Understanding(NLU)and Principled Agent:研究将伦理原则内化到模型中的方法,通过强化学习从AI反馈(RLAIF)实现自主同化原则,以应对AI对AI伦理和安全讨论的潜在影响。

-

Safe Reinforcement Learning for Agentic LLMs:通过重新评估强化学习的概念,统一控制体系中的强化学习方法,分析模仿学习方法中的分歧,以确保智能体在执行安全关键任务时的安全性。

-

Self - governing and Introspective Generative Agents:结合自然语言理解的进步和新的强化学习技术,通过使AI智能体能够识别自身子目标中的漏洞,实现自我调节,从而增强对齐。