以前的 FAS 方法受到数据集的规模大小和多样性的限制。作者观察到,使用二元分类模型在此类数据集上进行训练容易过度拟合。此外,网络在这类数据集中训练容易过拟合,这使得模型学习到的特征在未知的测试场景中很容易受到攻击。因此,近期的 FAS 方法利用辅助像素级监督信息 (如,binary mask 和 pseudo depth map)作为强大的先验知识,以在未知的测试场景下拥有更好的鲁棒性。然而基于整图输入的 FAS 模型缺乏捕获局部细粒度内在信息的能力,因此作者将 FAS 重新定义为细粒度的局部 patch 识别问题。

一、创新点

(1) 将 FAS 重新定义为细粒度的 patch 识别问题,并提出了名为 PatchNet 的简单框架。以patch 为输入可以增加数据的多样性,使模型学习类似人脸识别中的 embedding space,还可以使模型捕获来自局部 patch 的内在信息,防止网络过拟合数据集而引入的偏差,提升模型在未知场景中的鲁棒性。

(2)提出了基于非对称 Margin 的 Softmax Loss 和 Self-supervised Similarity Loss 来监督 PatchNet 训练。 前者有助于学习更通用的 patch 嵌入空间来解决活体和假体之间的不对称性,后者可以强制来自同一图片的不同 patch 的特征保持不变。

二、动机

以前的 FAS 方法受到数据集的规模大小和多样性的限制。作者观察到,使用二元分类模型在此类数据集上进行训练容易过度拟合。此外,网络在这类数据集中训练容易过拟合,这使得模型学习到的特征在未知的测试场景中很容易受到攻击。因此,近期的 FAS 方法利用辅助像素级监督信息 (如,binary mask 和 pseudo depth map)作为强大的先验知识,以在未知的测试场景下拥有更好的鲁棒性。然而基于整图输入的 FAS 模型缺乏捕获局部细粒度内在信息的能力,因此作者将 FAS 重新定义为细粒度的局部 patch 识别问题。

三、PatchNet

(1)总体框架

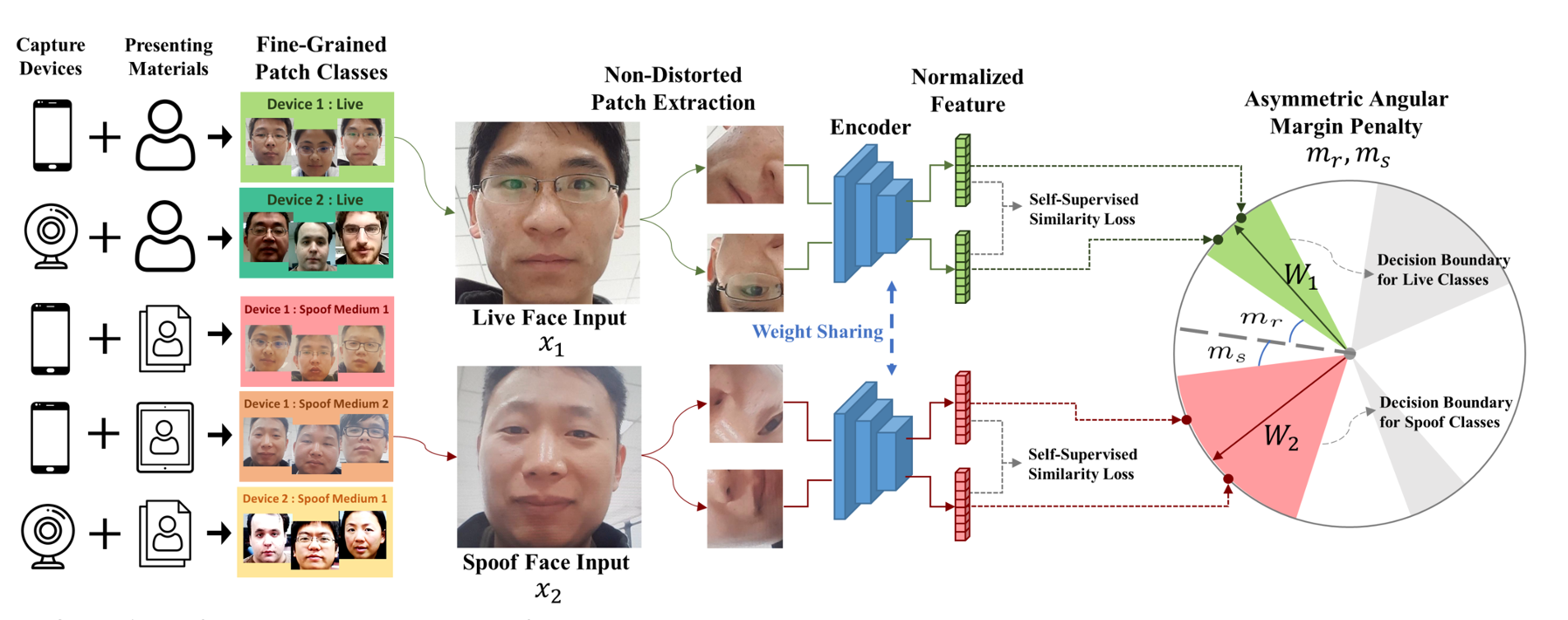

如图1所示,作者将 FAS 重新定义为细粒度的 patch 识别问题,并提出了一个简单的训练框架来有效地学习特征。首先对原始图像进行一定的变换 (此类变换不会导致图像失真) 以获得 patch 输入,然后通过编码器提取特征并在特征空间中进行归一化。此外,作者根据假体材料和捕获设备对类别进行精细划分。

受人脸识别方法的启发,在训练过程中,采用了基于角边距的 softmax 损失,它可以强制类内特征紧凑分布,并具有更好的泛化能力。此外,由于欺骗样本之间的分布差异大于真人样本,作者对活体样本和假体样本进行不对称处理:强制模型在活体样本中学习更紧凑的分布,同时使欺骗样本在特征空间中更加分散。作者还修改了基于角边距的 softmax 损失,将不对称边距应用在损失函数中,对活体类型施加更大的角距以获得更紧凑的边界。最后,自监督的相似性损失通过将对比损失中对正样本对之间的处理应用于来自同一图像的两个不同的 patch 中,进一步规范了 patch 特征。考虑到假体的欺骗信息在空间上存在于整个面部区域,那么来自同一面部捕获的两个不同 patch 之间的特征应该是相似的。

(2)提取Patch特征

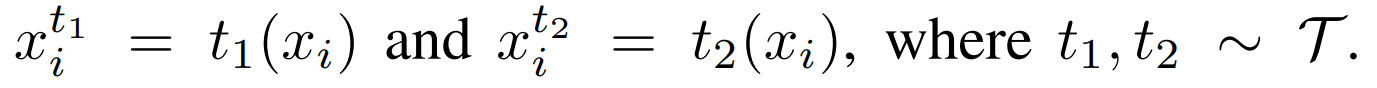

使用的数据增强策略应避免导致图像失真,给定原始人脸图像,对两个patch进行数据增强,其中t是一系列非失真增强操作,只包含随机水平翻转、随机旋转和固定大小裁剪。

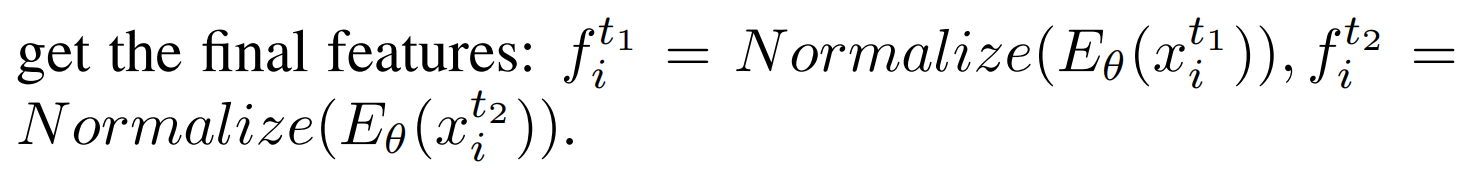

然后将两个输入 patch 前向传播到编码器和归一化层以获得最终特征。

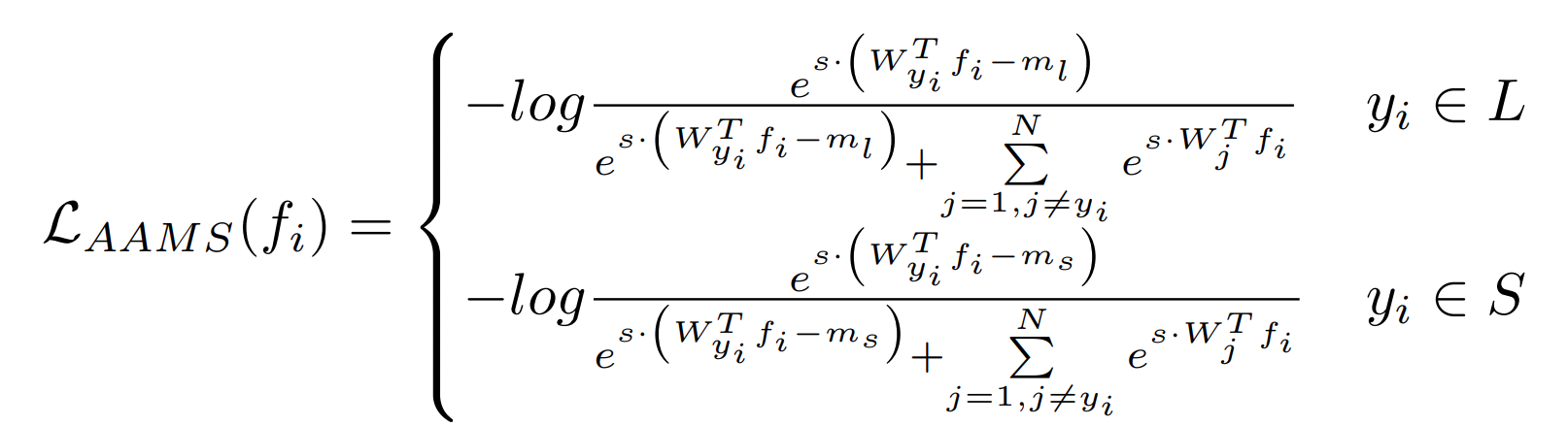

(3)细粒度的 patch 识别损失

Angular-Margin Softmax Loss 有很多变体,常用于人脸识别,以提高对开放数据集身份的泛化能力。在这项工作中,作者使用 AMSoftmax 损失来优化细粒度的 patch 识别模型并对其进行修改以解决 FAS 中的不对称性质。具体来说,分别对活体和假体类别的输入施加不同的阈值。

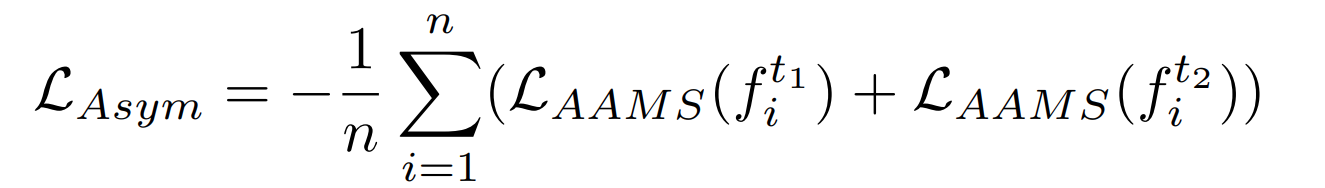

来自同一图像的两个增强 patch 上的非对称识别损失公式如下:

(4)自监督相似损失

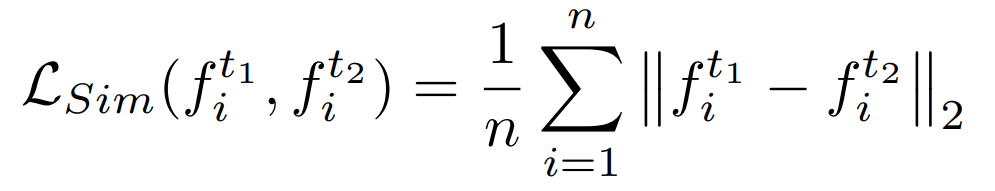

给定来自同一人脸图像的两个不同 patch,应用自监督的相似性约束来强制特征相似。公式如下:

(5)训练和测试

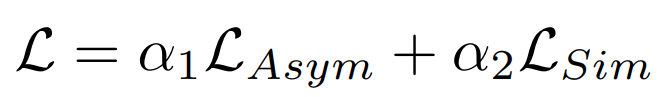

总体损失如下:

在测试时,给定一张测试人脸图像,首先从整个图像中统一裁剪 patch 进行网络推理,patch 大小与训练过程中的一致。假设有来自一张人脸图像的 P 个裁剪块特征,最终的预测分数为对 P (默认值为 9) 个patch 的分数取平均值,公式如下: