1. 关键特征

与单模态学习不同,多模态任务可以学习到单模态情况下难学习到的信息,或者需要更多的数据才能学习到的信息。使用多模态数据,可以让不同模态数据之间相互借鉴,相互验证,提升单模态能力,特别是存在在数据较少或者学习能力差的模态情况下,可以通过从较强的模态中迁移能力来优化弱模态的学习结果。如果要微调的模型是多模态的,那么在相同的资源情况下,其效果往往比单模态模型更好。在这种情况下,使用多模态模型的性价比会更高。加入多模态信息后,相对参数规模较小的模型也能更容易获得“智能涌现”能力,如小LLM模型加入视觉模块,也获得了思维链(CoT)的能力,相比大LLM参数更少。人工智能著名学者杨老师(Yann LeCun)认为,单靠语言模型是无法实现AGI的,人类自身是多模态学习的生物,而且很多信息在单纯的语言中难以体现。当GPT3.5或GPT-4刚出现时,很多人觉得离通用人工智能(AGI)似乎越来越近了,但现在看来,LLM仍存在很多难以解决的问题。在模型参数达到1000亿级别之后,增加更多的参数只能带来越来越小的收益。目前多模态学习被认为是通往通用人工智能(AGI)最有前景的候选路径之一。

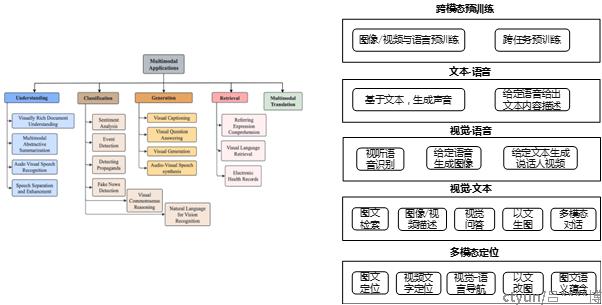

2. 典型任务

如图所示,多模态学习的典型任务包括跨模态预训练、文本-语音描述生成、视觉-语音内容描述生成、视觉-文本内容描述生成、多模态定位及其他模态任务等。目前基于视觉-文本类的多模态任务进展迅速,其中文图搜索、图文内容描述、图文内容理解、多模态图文对话,以及AIGC类的以文生图、以图改图等任务表现活跃,已经有诸多的学术成果和工业演示级产品样例出现,带给业界无限的想象空间,也具备非常有潜力的商业前景。

3. 最新模型

3.1 CLIP

CLIP全称Contrastive Language-Image Pre-training,是OpenAI最新的一篇NLP和CV结合的多模态的工作,在多模态领域迈出了重要的一步。CLIP在无需利用ImageNet的数据和标签进行训练的情况下,就可以达到ResNet50在ImageNet数据集上有监督训练的结果。CLIP主要的贡献就是利用无监督的文本信息,作为监督信号来学习视觉特征,训练数据中,采用弱对齐的海量图像文本对进行对比学习,可用于图文检索、zero-shot分类等任务。

3.2 BLIP2

BLIP-2 是 Saleforce 的工作。该工作的主要目标是在多模态模型中引入已训练好的模型,通过只训练少量的模型参数来获得好的效果。这种方式有点像使用胶水将已经训练好的,功能强大的单模态模型粘连在一起。在他们的例子中,他们使用了在CLIP中训练好的图像编码器,并在此基础上添加了一个语言模型(OPT 或者 FlanT5)。这样生成的模型可以用来执行视觉问答(VQA)任务,即给定一张图片,模型需要回答关于该图片的问题。这种方法的优点是它能够复用已经训练好的模型,并且只需要训练相对较少的参数。这在某种程度上减轻了训练的压力,降低了训练资源的消耗,并且还能保持相当不错的效果。

3.3 Multimodal-CoT

Multimodal-CoT是近期亚马逊李沐团队的工作。该工作的目标是探索通过添加视觉信息,是否可以使小型语言模型也具有推理能力。作者的结论是,通过引入视觉信息,小型语言模型确实能够实现某种程度的推理能力。如果没有视觉信息,只有文本信息,那么语言模型的参数规模大约需要达到1000亿。因此,通过引入多模态信息,语言模型的能力确实可以得到提升。

3.4 ImageBind

今年的一个新趋势是,是融合更多模态数据的多模态模型。以前,大部分的工作都关注在两个或最多三个模态,比如文本和图像,或者文本和语音。最近,Meta开源的模型 ImageBind,该模型利用了6个模态的数据进行训练,包括视觉、文本、声音、深度图、热力图以及运动向量图。这个模型的训练过程相当于训练了五个双模态模型,每一个都是其他五个模态与视觉模态的结合。通过这样的方式,所有的模态都被对齐到图像模态的表示空间,从而可以把所有的模态统一到一个共享的表示空间。

4. 最新模型

多模态学习是一种从异构和互联数据中进行学习的范式。目前主要采用Transformer的建模框架,将多源异构的数据做token化后,映射到统一空间进行对齐、融合和编码处理后,再通过解码器实现各种下游任务。不同模态的数据之间相互借鉴、相互启发、相互验证,从而显著提升模型的表征和泛化能力。多模态学习具有巨大发展潜力,被认为是目前最可能实现通用人工智能AGI的技术路径。

尽管多模态当前已经取得很大进展,但面临的挑战依旧很大。例如,如何采集噪音小的多模态对齐数据?如何让模型更好地学习到不同粒度的对齐能力,可迁移能力,如何进行客观全面的基准测评等,仍然值得业界进行探索和实践。