Text2Image任务随着midjourney、stable diffusion的广泛熟知也越来越受到关注了,那如何评估生成出来的图的好坏呢?下面是当前研究中使用最广泛的几种方法。

1.Inception Score (IS)

Inception Score (IS) IS 是一种衡量生成模型逼真程度的指标,是由 Salimans 等人于2016年提出的,它使用在ImageNet数据集上训练的 Inception Net 对评估的模型生成的假图像进行分类。然后,它测量了边缘标签分布 p(y) 与基于生成样本 p(y|x) 的条件标签分布之间的平均 KL 散度。

exp(E[KL(p(ylz)llp(y))])

IS 是一种用于评估生成模型质量的客观评估方法,它通过测量边缘标签分布 p(y) 与基于生成样本 p(y|x) 的条件标签分布之间的平均 KL 散度来实现。具体来说,IS 要求生成模型产生的图像具有高多样性(熵),即能够代表各种不同的类别;同时,要求条件标签分布 p(y|x) 具有低多样性,即能够表示有意义的概念。如果生成一系列猫的图像,它们都应该被 Inception Net 准确地分类为猫。 IS值越低表示生成的数据与真实数据越相似,逼真程度越高。由于 IS 与人类判断的相关性较好,因此备受青睐。

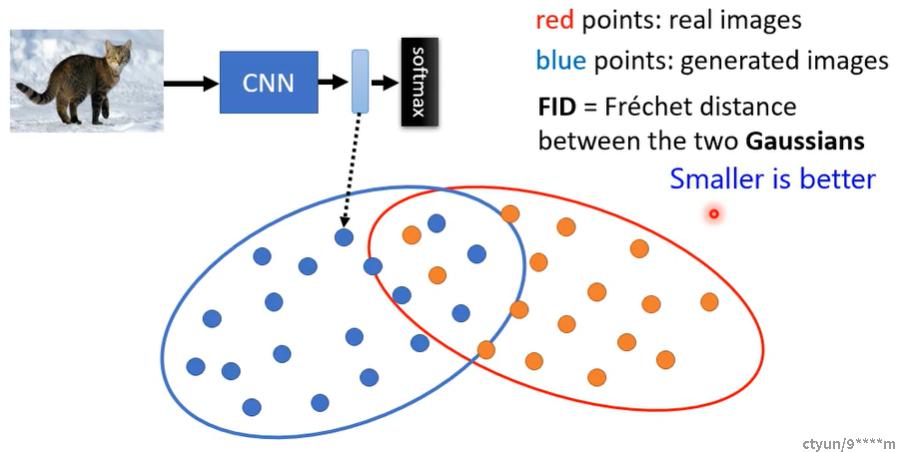

2.Fréchet Inception Distance (FID)

Fréchet Inception Distance (FID) 是一种改进的 IS 评估指标,它主要解决了 IS 没有考虑真实数据的问题。与 IS 不同的是,FID 将图像嵌入到特征空间中,并在特定的层停止,即丢弃了一些网络的最终层。然后假设特征向量服从高斯分布,计算真实和生成数据的分布之间的 Fréchet 距离。

FID 可以通过计算真实数据分布和生成数据分布之间的距离来评估生成数据的逼真程度。显然,FID 的值越低,说明生成的数据与真实数据越相似,逼真程度越高。

3.Precision / Recall

Precision和recall是许多机器学习问题中广泛使用的指标之一。然而,由于缺乏客观标签,它们的经典定义不能适用于生成模型。Sajjadi等人在2018年提出了一种新颖的这些指标的计算方法,直接从分布中计算,并由Kynkäänniemi等人在2019年进一步改进。这种方法背后的原因是,像IS或FID这样的指标仅提供模型性能的一维视图,忽略了精度和召回率之间的权衡。良好的FID结果很可能意味着高召回率(大的变化,即模型所代表的数据范围很广)、高精度(逼真的图像)或介于两者之间的任何东西。假设Pr表示真实数据的概率分布,Pg表示生成数据分布。召回率衡量可以从Pg中生成多少符合Pr的数据,而精度则试图了解有多少生成图像落入Pr中。

4.CLIP score

CLIP是一种来自OpenAI [CLIP2021]的模型。原则上,CLIP能够评估文本和图像之间的语义相似性,越大越好。基于这一理念,CLIP分数可以作为度量标准,定义为下面的式子。其中期望是针对生成的图像批次进行的,s是CLIP logit scale(Nichol et al.,2021b)。

E[s(f(image) * g(caption))]

5.Human evaluations

这类评估一般是测试以下两个标准:

• 照片逼真度

• 图像标题相似性(图像-文本对齐)。

通常,一组图像会呈现给人类,其任务是根据上述两个标准评估它们的质量。