CLIP是一种新的机器学习方法,它可以同时理解图像和文本。CLIP是用对比学习的方式来预训练一个能够同时处理图像和文本的模型。CLIP可以用自然语言来分类图像,用图像来生成文本描述,用文本来检索图像等等。CLIP只需要一个简单的线性分类器或者最近邻搜索就可以完成这些任务,不需要任何额外的训练或者微调。

下面将介绍CLIP的方法,以及优势和局限性,并给出一些后续有意思的应用工作。

论文: https://arxiv.org/abs/2103.00020

github:https://github.com/openai/CLIP

blog:https://openai.com/blog/clip/

1. 核心方法

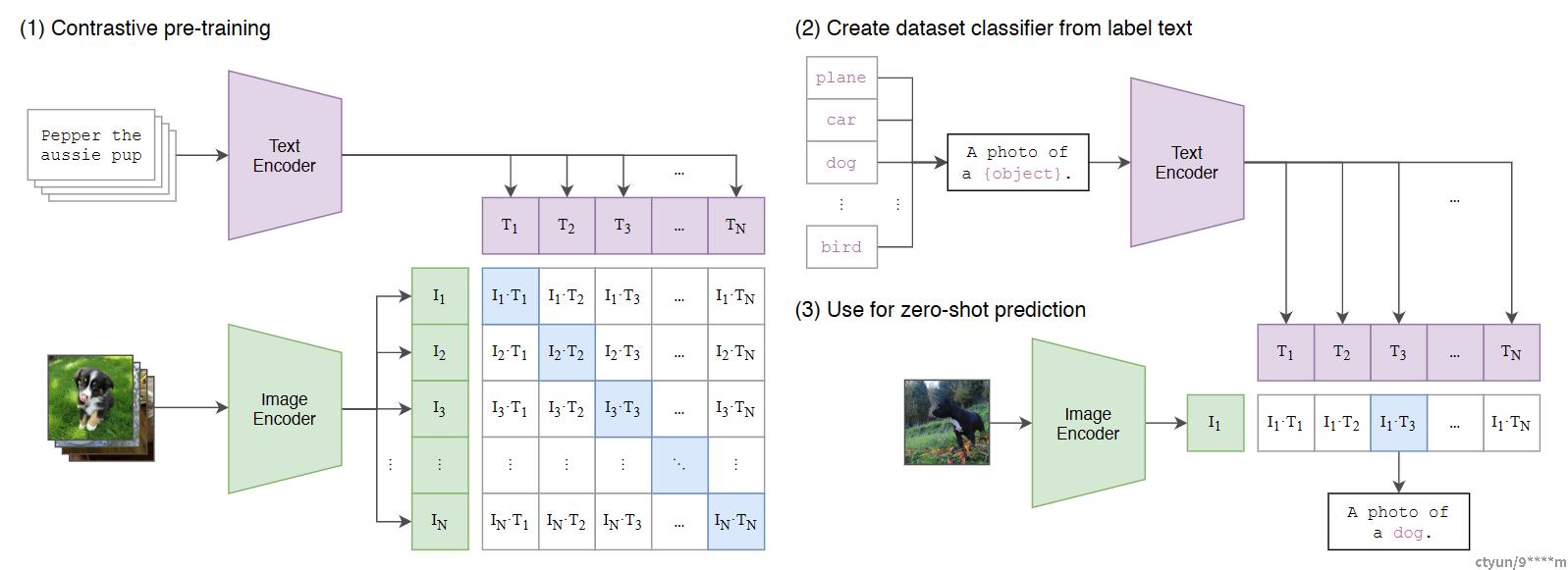

CLIP的核心思想是用图像和文本之间的语义相似性来训练一个视觉-语言模型。具体来说,CLIP使用了一个双塔结构的神经网络,其中一塔是一个图像编码器,另一塔是一个文本编码器。图像编码器负责将图像转换为一个向量表示,文本编码器负责将文本转换为一个向量表示。然后,CLIP使用了一个对比损失函数,来优化这两个向量之间的内积。也就是说,CLIP希望图像和文本之间的内积越大,表示它们越相似;反之,图像和文本之间的内积越小,表示它们越不相似。

为了实现这个目标,CLIP使用了一个大规模的数据集,包含了4亿多对图像和文本。这些图像和文本来自于互联网上的各种来源,例如网页、社交媒体、新闻等等。这些图像和文本涵盖了很多不同的主题、风格和语言,因此可以提供丰富的视觉和语言信息。CLIP使用了这些数据来训练它的图像编码器和文本编码器,使它们能够学习到一个通用的视觉-语言表示。

在训练完成后,CLIP就可以用来做各种视觉和语言任务。例如,如果要用CLIP来分类图像,只需要给出一些自然语言的标签,例如“猫”、“狗”、“花”等等。然后,CLIP就可以将每个标签转换为一个向量表示,并计算它和图像向量之间的内积。最后,CLIP就可以选择内积最大的标签作为图像的分类结果。同样地,如果要用CLIP来生成文本描述,只需要给出一些自然语言的模板,例如“这是一张{…}的图片”、“我看到了{…}”等等。然后,CLIP就可以将每个模板转换为一个向量表示,并计算它和图像向量之间的内积。最后,CLIP就可以选择内积最大的模板,并用图像中的内容来填充其中的空白部分,从而生成文本描述。

2.结果展示

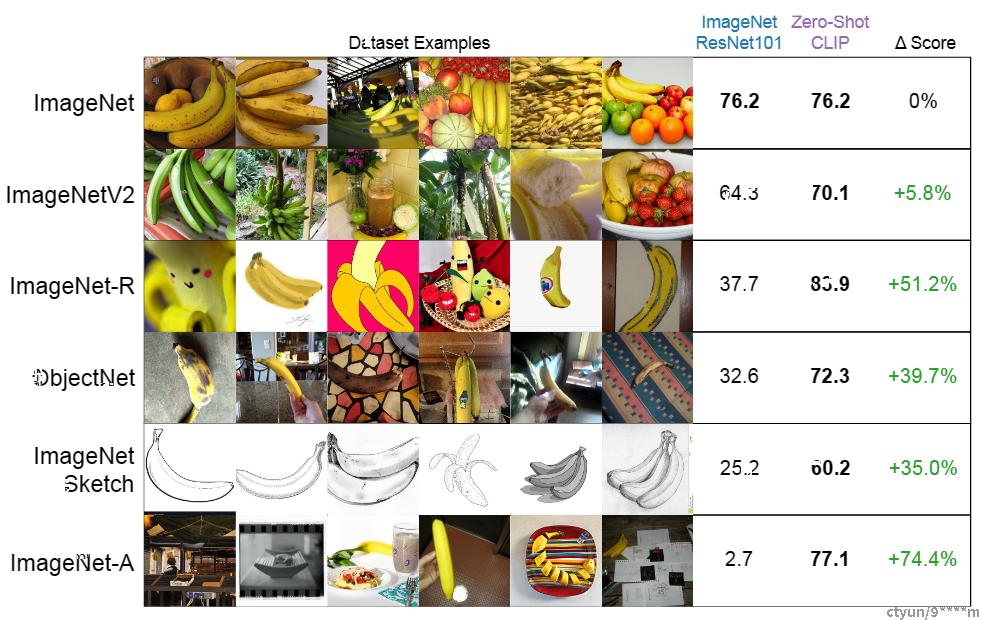

CLIP具有出色的zero-shot迁移能力。在ImageNet问题上,无需使用ImageNet标注数据进行训练,CLIP就可以通过zero-shot分类实现与ResNet相当的性能表现,并且具有更好的泛化性和鲁棒性。

3. 优势和局限性

CLIP的优势:

- CLIP可以用自然语言来处理图像,这使得它更加灵活和通用。例如,CLIP可以用任何语言来分类图像,只要给出相应的标签;CLIP也可以用任何风格和语气来生成文本描述,只要给出相应的模板。

- CLIP可以跨越多个视觉和语言任务,这使得它更加强大和高效。例如,CLIP可以用同一个模型来做图像分类、图像检索、文本生成、文本检索等等,不需要针对每个任务进行特定的训练或者微调。

- CLIP可以利用大量的未标注的图像和文本数据,这使得它更加鲁棒和广泛。例如,CLIP可以处理各种各样的图像和文本,不受数据集的限制;CLIP也可以适应各种各样的噪声和变化,不受环境的影响。

CLIP的局限性:

- CLIP依赖于图像和文本之间的语义相似性,这可能导致一些问题。例如,CLIP可能无法区分一些细微的差别,例如“狗”和“狼”;CLIP也可能受到一些干扰,例如“苹果”既可以指水果也可以指公司。

- CLIP需要大量的计算资源和存储空间,这可能导致一些困难。例如,CLIP需要使用高性能的GPU或者TPU来训练和运行;CLIP也需要使用大容量的硬盘或者云端服务来存储数据和模型。

- CLIP可能存在一些安全和伦理的风险,这可能导致一些后果。例如,CLIP可能被用来生成虚假或者有害的图像和文本;CLIP也可能被用来侵犯他人的隐私或者版权。

4.后续有趣工作

CLIP的出现引发了很多基于CLIP的有趣工作,它们利用了CLIP的视觉-语言能力,实现了一些创新和有趣的应用。

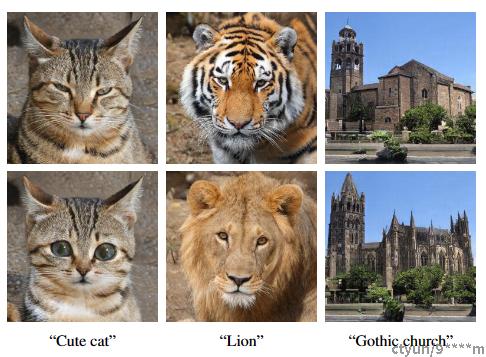

StyleCLIP

StyleCLIP是一种使用文本来操作图像的方法,它结合了预训练的StyleGAN生成器和CLIP模型。StyleCLIP可以根据文本直接修改图像的内容、风格或者属性,例如改变人脸的发型、表情或者年龄等。StyleCLIP也可以根据文本生成新的图像,例如生成不同风格或者主题的图像等。StyleCLIP还可以根据文本进行图像搜索,例如找出最符合文本描述的图像等。

Demo演示:https://replicate.com/orpatashnik/styleclip

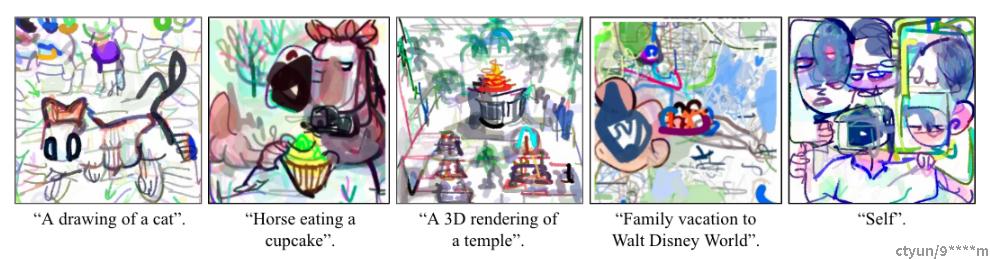

CLIPDraw

CLIPDraw是一种使用文本来绘制图像的方法,它只使用了CLIP模型,不需要任何额外的训练或者数据。CLIPDraw可以根据文本直接绘制出一系列的贝塞尔曲线,形成一个简笔画。CLIPDraw可以绘制各种各样的图像,例如动物、植物、食物、人物等。CLIPDraw还可以根据文本控制绘制的颜色、透明度等。