1.SecretFlow的安装

1.SecretFlow运行要求

SecretFlow作为一个隐私保护的数据分析和机器学习框架,其运行要求可能涉及以下方面:

-

操作系统:

-

能够支持Docker运行的环境,因为SecretFlow可能通过Docker容器来管理执行环境的一致性和隔离性。

-

硬件要求:

-

内存:由于隐私计算通常涉及到复杂的加密计算,因此需要足够的RAM来处理数据和运行计算任务,具体需求会根据数据规模和复杂模型有所不同。

-

CPU:为了高效地执行并行计算和加密操作,至少需要8核CPU,具体的核数根据所需并发能力和计算密集度来决定。

-

存储空间:需存放代码、数据集、模型和其他临时文件的空间。

-

软件依赖:

-

Python环境:SecretFlow是Python库,需要Python 3.8版本以上及其兼容的库环境。

-

私密计算相关库:可能需要特定的隐私计算库,比如多方安全计算(MPC)、同态加密(HE)相关的库。

-

Docker环境:如果是部署在集群或者分布式环境中,可能需要Docker Engine及相应的服务。

-

网络环境:

-

分布式部署时,各参与方之间需要稳定的网络连接,以便数据的安全交换和协同计算。

综上所述,运行SecretFlow的具体要求请参照其官方提供的最新文档,以确保得到详尽且符合当前版本的最佳实践指导。在实际部署前,请查阅SecretFlow的官方安装指南和技术要求文档,以确认确切的系统要求和部署步骤。

2.安装方式

SecretFlow的安装方式有三种,分别是:

- 1.docker镜像

- 2.pypi

- 3.源码

1.docker镜像安装SerectFlow

要使用Docker命令安装和启动secretflow/secretflow-lite-anolis8镜像,请按照以下步骤操作:

- 首先,确保您的计算机上已经安装了Docker。您可以从Docker官方网站下载和安装适用于您操作系统的Docker版本。

- 打开终端或命令提示符窗口,并使用以下命令从Docker Hub下载secretflow/secretflow-lite-anolis8镜像:

docker pull secretflow/secretflow-lite-anolis8

- 下载完成后,使用以下命令启动secretflow/secretflow-lite-anolis8容器

docker run -it secretflow/secretflow-lite-anolis8

此命令将在交互模式下启动容器,并将您连接到容器的终端。

至此你现在已经成功安装和启动了secretflow/secretflow-lite-anolis8镜像并测试安装成功。您可以在容器中执行SecretFlow的操作,例如加密和解密。请注意,具体的操作步骤可能会有所不同,具体取决于您对SecretFlow的使用需求。

2.SerectFlow部署-仿真模式

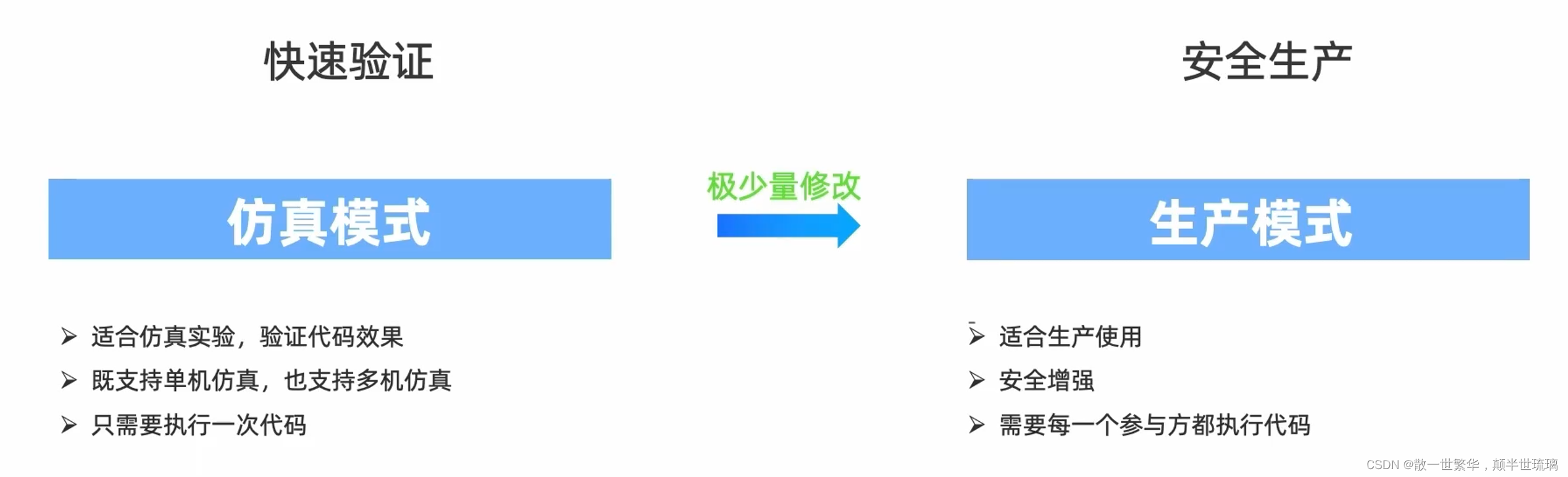

在SecretFlow的部署模式中,有两种主要模式:仿真模式和生产模式。这些模式具有不同的特点和用途。

-

仿真模式(Simulation Mode):

- 仿真模式是SecretFlow的默认模式,用于开发和测试目的。

- 在仿真模式中,SecretFlow使用仿真的网络环境来模拟真实网络的行为,从而提供一种安全的测试环境。

- 仿真模式不涉及实际的网络通信,只是在本地模拟加密和解密操作,因此不需要配置实际的网络设备和连接。

- 仿真模式适用于在不涉及真实网络的情况下测试和验证SecretFlow的功能和性能。

-

生产模式(Production Mode):

- 生产模式是SecretFlow的生产环境部署模式,用于实际的生产环境中的加密和解密操作。

- 在生产模式中,SecretFlow需要实际的网络设备和连接,以进行真实的加密和解密操作。

- 生产模式需要配置和连接SecretFlow的各个组件,例如SecretFlow节点、代理和密钥服务器等。

- 生产模式提供了高度安全和可扩展的加密解密服务,适用于实际的生产环境中保护敏感数据和通信的需求。

无论是仿真模式还是生产模式,SecretFlow都提供了一致的API和功能。根据您的需求和环境,你可以选择适合的模式来部署和使用SecretFlow。请注意,在生产环境中使用SecretFlow时,需要确保适当的安全措施和配置,以保护你的数据和通信的安全性。

1.单击仿真

首先使用docker命令启动secretflow,具体如下所示:

# 以交互式运行secretflow

docker run -it secretflow/secretflow-lite-anolis8

然后在本地单击模拟alice和bob两个参与方

import secretflow as sf

sf.init(parties=['alice','bob'],address='local')

alice = sf.PYU('alice')

bob = sf.PYU('bob')

# 将明文值2通过密文计算加一的操作,得到一个密文结果

alice(lambda x: x+1)(2)

# 将明文值2通过密文计算减一的操作,得到一个密文结果

bob(lambda x: x-1)(2)

2.集群仿真

1.在第一台机器上部署Ray主节点,模拟参与方alice,address填写Ray主节点的ip和port

ray start --head \

--node-ip-address="{ip}" --port="{port}" \

--resources='{"alice":16}' \

--include-dashboard=False \

--disable-usage-stats

2.在第二台机器上部署Ray从节点,模拟参与方bob,address填写Ray主节点ip和port

ray start \

--address="{Ray主节点的通信地址}" \

--resources='{"bob":16}' \

--include-dashboard=False \

--disable-usage-stats

3.执行Python代码

在任意一台机器上执行代码即可,address填写实际的Ray主节点ip和port

import secretflow as sf

sf.init(parties=['alice','bob'],address='{ip:port}')

alice = sf.PYU('alice')

bob = sf.PYU('bob')

# 将明文值2通过密文计算加一的操作,得到一个密文结果

alice(lambda x: x+1)(2)

# 将明文值2通过密文计算减一的操作,得到一个密文结果

bob(lambda x: x-1)(2)

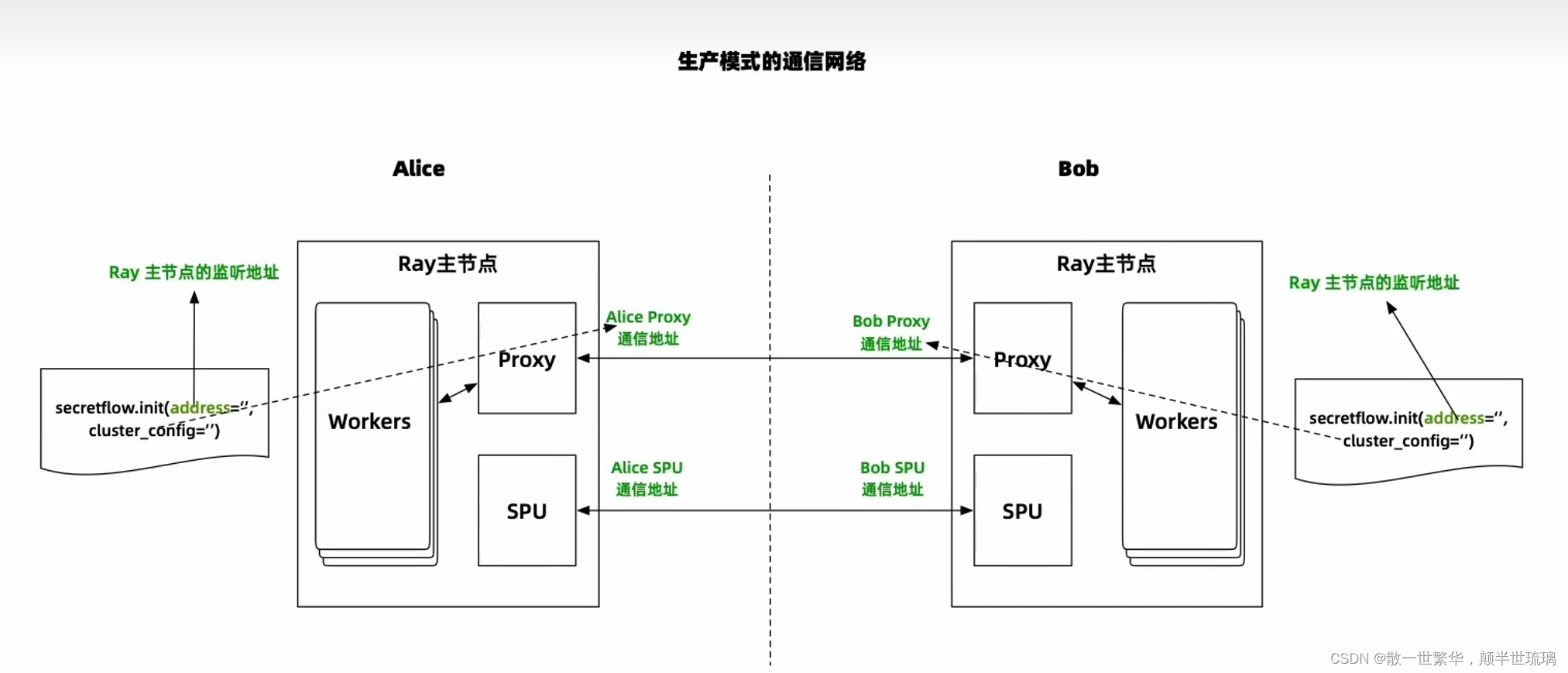

3.SecretFlow部署-生产模式

相比仿真模式,生产模式主要是每一个参与方都是独立的Ray集群,所有参与方都需要执行代码!

1.生产过程

1.模拟参与方alice

在第一台机器上部署Ray主节点,模拟参与方alice

ray start --head \

--node-ip-address="{ip}" --port="{port}" \

--resources='{"alice":16}' \

--include-dashboard=False \

--disable-usage-stats

2.模拟参与方bob

在第二台机器上部署Ray主节点,模拟参与方bob

ray start --head \

--node-ip-address="{ip}" --port="{port}" \

--resources='{"alice":16}' \

--include-dashboard=False \

--disable-usage-stats

3.alice执行Python代码

4.bob执行python代码

具体生产模式的通信网络图如下所示:

2.KUSCIA解决多端口问题

Kuscia 是隐私计算领域的一个资源调度框架,它在隐语1.0版本中被提及,用于解决在使用隐语技术时遇到的多端口整合与API接入等集成问题。在实际应用中,当业务系统需要对接隐私计算平台时,可能会涉及多个服务接口、不同功能模块之间的通信,而这些模块可能各自运行在独立的端口上。

Kuscia 提供了一种机制,使得业务系统能够更加方便地管理和调度跨系统的资源,包括但不限于端口合并、服务编排和服务发现等功能。这意味着开发者无需手动处理复杂的端口映射或网络配置,可以通过Kuscia框架统一管理并实现不同服务间的互联互通,简化了隐私计算任务在复杂环境下的部署和执行流程,提升了整体系统的稳定性和易用性。

以下是使用KUSCIA解决多端口问题的步骤:

-

安装KUSCIA:在Kubernetes集群上安装KUSCIA的控制器。您可以从KUSCIA的GitHub仓库获取最新的安装说明和代码。

-

创建Ingress资源:为每个需要多端口支持的服务创建一个Ingress资源。在Ingress资源的

metadata部分中,添加一个注解来指定要使用的端口和服务。例如:

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

name: my-ingress

annotations:

/port-routes: "80=default-service, 8080=other-service"

spec:

rules:

- host:

http:

paths:

- pathType: Prefix

path: /

backend:

service:

name: default-service

port:

number: 80

在上面的示例中,/port-routes注解指定了两个端口与服务之间的映射关系。

- 配置服务:为每个服务创建一个Service资源,并确保服务的端口与Ingress资源中指定的端口匹配。在Service资源的

spec部分中,定义服务的端口和目标端口。例如:

apiVersion: v1

kind: Service

metadata:

name: default-service

spec:

selector:

app: default-app

ports:

- protocol: TCP

port: 80

targetPort: 8080

在上面的示例中,Service资源的端口为80,目标端口为8080。

- 部署应用程序:使用Deployment或其他适当的资源部署您的应用程序。

通过上述步骤,您可以使用KUSCIA在Kubernetes中实现多端口支持。Ingress资源的注解配置了多个端口与服务之间的映射关系,而Service资源确保服务的端口与Ingress资源中指定的端口匹配。这样,Kubernetes集群就能够根据Ingress资源中的配置将流量正确路由到不同的服务和端口上。