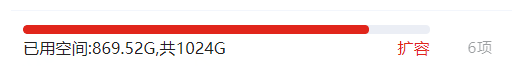

今天本来想训练一个模型的,但是奈何数据量非常大,还没全下载到本地就把我磁盘撑满了,经过一系列,但是仔细一查好像不是那么回事,记录一下解决过程。

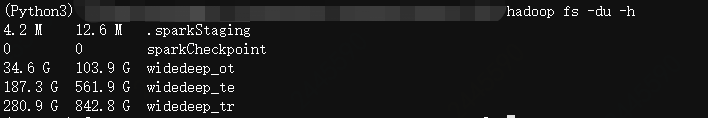

首先看了下HDFS上的数据:hadoop fs -du -h

第一列表示该目录下每个文件及文件夹的大小

第二列表示该目录下每个文件及文件夹原文件和副本大小,所以第二列是第一列的三倍

我还以为占得那么多磁盘空间就是因为副本数太多,加起来总的文件太大,但是转念一想不对啊,这数据是存在集群上的,跟我本地有什么关系。

但是磁盘爆满是从HDFS上下载完数据之后的发生的,我虽然把数据删了,但是磁盘空间并没有减少。

于是我又到家目录下看了一下各个目录的文件及文件夹占用大小:du -h --max-depth=1

我一看.local目录占了800+G的空间,就知道了糟了,估计之前删的文件都被放到回收站了。

找到原因在哪就好办了,一键清空回收站:

rm -rf ~/.local/share/Trash/*

我用的JupyterLab,测试了一下,通过rm -rf test删除的文件是被直接删除了,没有放入回收站,但是通过File Browser删除的文件都进入了回收站,谨记谨记。