CTyunOS DeepSeek本地部署:个人开发者的智能助手

在AI技术飞速发展的今天,个人开发者也需要高效、灵活的AI工具来加速项目开发与创新。 CTyunOS DeepSeek本地部署解决方案 为个人开发者提供了一站式的AI模型部署与应用服务,让您轻松在本地运行强大的DeepSeek模型,快速构建专属知识库,赋能您的开发灵感与创造力。

为什么选择CTyunOS DeepSeek本地部署?

- 轻量化部署,低资源需求:支持从1.5B到70B多种规模的模型,适应个人开发者的多样化需求,即使是低配置设 备也能高效运行。

- 一键安装,简单高效:CTyunOS提供一键安装脚本,简化部署流程,无需复杂的配置,快速上手。

- 本地运行,数据安全:所有数据与模型均在本地运行,确保您的开发数据隐私与安全,无需担心第三方数据泄露风险。

- 多种接入方式,灵活使用:支持通过Open WebUI、Chatbox、Cherry Studio等多种方式接入本地模型,满足不同开发需求。

CTyunOS DeepSeek本地部署步骤

环境准备

在开始部署之前,请确保您的设备满足以下最低硬件要求:

- · 1.5B模型:4核CPU,8GB内存。

- · 7B模型:8核CPU,16GB内存。

- · 14B模型:12核CPU,32GB内存。

- · 32B模型:16核CPU,64GB内存。

- · 70B模型:32核CPU,128GB内存,支持多卡并行。

步骤1:下载一键安装脚本

脚本内容如下,请保存为ctyunos_deepseek.sh

#!/bin/bash

# 脚本名称: ctyunos_deepseek.sh

# 功能:自动检查系统类型,检测是否已安装Ollama,安装必要软件、配置Ollama服务,安装并运行指定的DeepSeek模型

# 系统类型检查

check_system() {

if grep -q "CTyunOS" /etc/os-release; then

echo "当前系统为 CTyunOS,继续安装..."

else

echo "错误:当前系统不是 CTyunOS,脚本仅支持 CTyunOS 系统!"

exit 1

fi

}

# 检查Ollama是否已安装

check_ollama_installed() {

if which ollama &>/dev/null; then

echo "检测到 Ollama 已安装,跳过安装步骤。"

return 0

else

echo "未检测到 Ollama,继续安装..."

return 1

fi

}

# 帮助说明

show_help() {

echo "使用方法: $0 [选项]"

echo "选项:"

echo " --install 安装必要软件和Ollama,配置Ollama服务"

echo " --run <模型编号> 运行指定的DeepSeek模型"

echo " --help 显示帮助信息"

echo ""

echo "模型编号:"

echo " 1. 1.5B Qwen DeepSeek R1"

echo " 2. 7B Qwen DeepSeek R1"

echo " 3. 8B Llama DeepSeek R1"

echo " 4. 14B Qwen DeepSeek R1"

echo " 5. 32B Qwen DeepSeek R1"

echo " 6. 70B Llama DeepSeek R1"

echo ""

echo "示例:"

echo " $0 --install # 安装环境和配置服务"

echo " $0 --run 1 # 运行1.5B Qwen DeepSeek R1模型"

exit 1

}

# 步骤1:安装必要软件

install_software() {

echo "正在安装必要软件:python3, python3-pip, git, curl..."

yum install python3 python3-pip git curl -y

if [ $? -ne 0 ]; then

echo "软件安装失败,请检查网络或权限!"

exit 1

fi

echo "必要软件安装完成!"

}

# 步骤2:安装Ollama

install_ollama() {

echo "正在安装Ollama..."

curl -fsSL https://ollama.com/install.sh | sh

if [ $? -ne 0 ]; then

echo "Ollama安装失败,请检查网络连接!"

exit 1

fi

echo "Ollama安装完成!"

}

# 步骤3:配置Ollama服务支持外部IP访问

configure_ollama() {

echo "正在配置Ollama服务支持外部IP访问..."

OLLAMA_SERVICE_FILE="/etc/systemd/system/ollama.service"

if [ -f "$OLLAMA_SERVICE_FILE" ]; then

# 在Service块中追加配置

sed -i '/\[Service\]/a Environment="OLLAMA_HOST=0.0.0.0"\nEnvironment="OLLAMA_ORIGINS=*"' "$OLLAMA_SERVICE_FILE"

echo "Ollama服务文件配置完成!"

else

echo "未找到Ollama服务文件,配置失败!"

exit 1

fi

}

# 步骤4:启动Ollama服务

start_ollama() {

echo "正在启动Ollama服务..."

systemctl daemon-reload

systemctl enable ollama

systemctl start ollama

if systemctl is-active --quiet ollama; then

echo "Ollama服务启动成功!"

else

echo "Ollama服务启动失败,请检查日志!"

exit 1

fi

echo "正在检查Ollama端口(11434)是否监听..."

netstat -tulpn | grep 11434

if [ $? -ne 0 ]; then

echo "Ollama端口未监听,请检查服务状态!"

exit 1

fi

echo "Ollama端口监听正常!"

}

# 步骤5:安装指定的DeepSeek模型

install_deepseek() {

echo "请选择要安装的DeepSeek模型:"

echo "1. 极简版: 1.5B Qwen DeepSeek R1"

echo "2. 入门版: 7B Qwen DeepSeek R1"

echo "3. 专业版: 8B Llama DeepSeek R1"

echo "4. 进阶版: 14B Qwen DeepSeek R1"

echo "5. 专家版: 32B Qwen DeepSeek R1"

echo "6. 大师级: 70B Llama DeepSeek R1"

read -p "请输入对应的编号 (1-6): " choice

case $choice in

1)

echo "正在下载 极简版: 1.5B Qwen DeepSeek R1..."

ollama run deepseek-r1:1.5b

;;

2)

echo "正在下载 入门版: 7B Qwen DeepSeek R1..."

ollama run deepseek-r1:7b

;;

3)

echo "正在下载 专业版: 8B Llama DeepSeek R1..."

ollama run deepseek-r1:8b

;;

4)

echo "正在下载 进阶版: 14B Qwen DeepSeek R1..."

ollama run deepseek-r1:14b

;;

5)

echo "正在下载 专家版: 32B Qwen DeepSeek R1..."

ollama run deepseek-r1:32b

;;

6)

echo "正在下载 大师级: 70B Llama DeepSeek R1..."

ollama run deepseek-r1:70b

;;

*)

echo "无效的选择,请输入1到6之间的数字。"

exit 1

;;

esac

}

# 步骤6:运行指定的DeepSeek模型

run_deepseek() {

local model_num=$1

case $model_num in

1)

echo "正在运行 极简版: 1.5B Qwen DeepSeek R1..."

ollama run deepseek-r1:1.5b

;;

2)

echo "正在运行 入门版: 7B Qwen DeepSeek R1..."

ollama run deepseek-r1:7b

;;

3)

echo "正在运行 专业版: 8B Llama DeepSeek R1..."

ollama run deepseek-r1:8b

;;

4)

echo "正在运行 进阶版: 14B Qwen DeepSeek R1..."

ollama run deepseek-r1:14b

;;

5)

echo "正在运行 专家版: 32B Qwen DeepSeek R1..."

ollama run deepseek-r1:32b

;;

6)

echo "正在运行 大师级: 70B Llama DeepSeek R1..."

ollama run deepseek-r1:70b

;;

*)

echo "无效的模型编号,请输入1到6之间的数字。"

exit 1

;;

esac

}

# 主程序逻辑

if [ $# -eq 0 ]; then

show_help

fi

case $1 in

--install)

check_system

check_ollama_installed || {

install_software

install_ollama

configure_ollama

start_ollama

}

;;

--run)

if [ -z "$2" ]; then

echo "错误:未指定模型编号!"

show_help

else

run_deepseek "$2"

fi

;;

--help)

show_help

;;

*)

echo "错误:未知选项 '$1'!"

show_help

;;

esac

运行以下命令查看脚本的使用方法:

[root@localhost ~]# ./ctyunos_deepseek.sh --help

使用方法: ./ctyunos_deepseek.sh [选项]

选项:

--install 安装必要软件和Ollama,配置Ollama服务

--run <模型编号> 运行指定的DeepSeek模型

--help 显示帮助信息

模型编号:

1. 1.5B Qwen DeepSeek R1

2. 7B Qwen DeepSeek R1

3. 8B Llama DeepSeek R1

4. 14B Qwen DeepSeek R1

5. 32B Qwen DeepSeek R1

6. 70B Llama DeepSeek R1

示例:

./ctyunos_deepseek.sh --install # 安装环境和配置服务

./ctyunos_deepseek.sh --run 1 # 运行1.5B Qwen DeepSeek R1模型步骤2:运行脚本,安装必要软件

使用以下命令安装必要软件和配置Ollama服务:

[root@localhost ~]# ./ctyunos_deepseek.sh --install

当前系统为 CTyunOS,继续安装...

检测到 Ollama 已安装,跳过安装步骤。

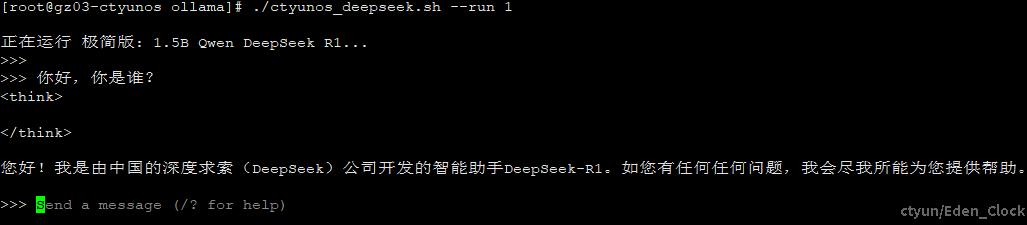

步骤3:选择并运行指定模型

通过脚本运行您所需的DeepSeek模型。以1.5B模型为例:

[root@localhost ~]# ./ctyunos_deepseek.sh --run 1

正在运行 极简版: 1.5B Qwen DeepSeek R1...

pulling manifest

pulling 96c415656d37... 安装完成后我们就可以运行使用模型

步骤4:接入本地模型

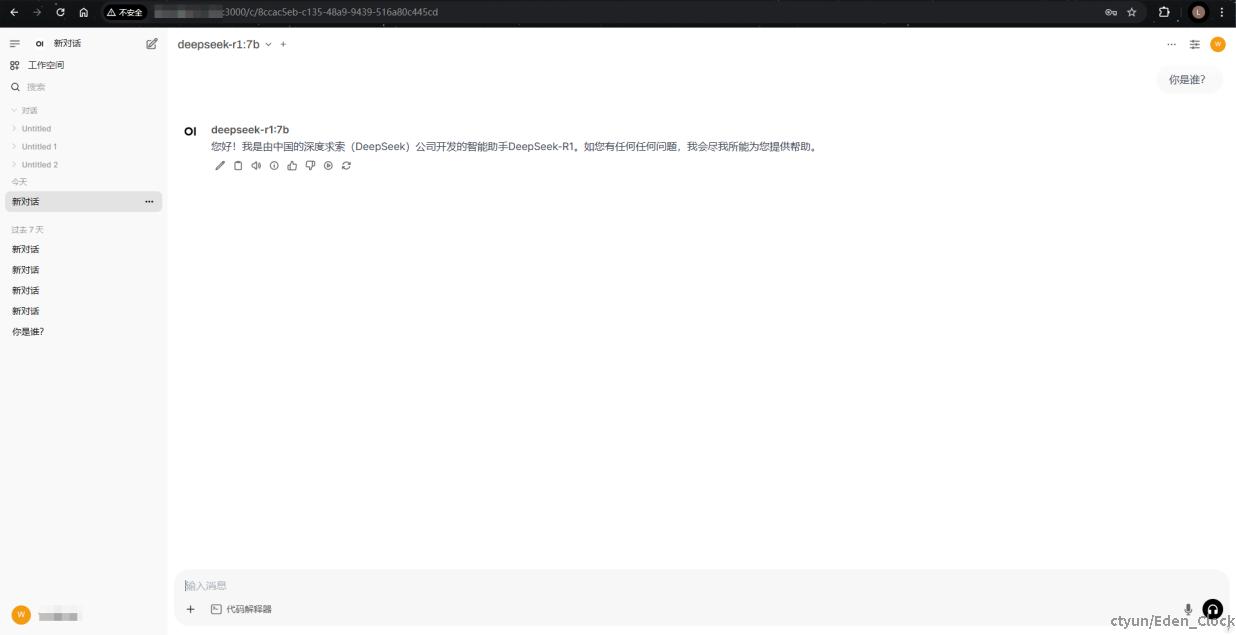

1. 通过Open WebUI

CTyunOS支持通过Docker快速部署Open WebUI,提供浏览器访问本地模型的便捷方式。

- 通过docker安装

- 启用GPU支持:

-

docker run -d -p 3000:8080 --gpus=all -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama

-

- 启用GPU支持:

-

- 仅使用CPU

-

docker run -d -p 3000:8080 -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama

-

- 仅使用CPU

- 使用 uv 安装

-

curl -LsSf https://astral.sh/uv/install.sh | sh DATA_DIR=~/.open-webui uvx --python 3.11 open-webui@latest serve

-

安装完成后,您可以通过访问 http://localhost:3000 使用 Open WebUI。(localhost替换为CTyunOS ip地址)

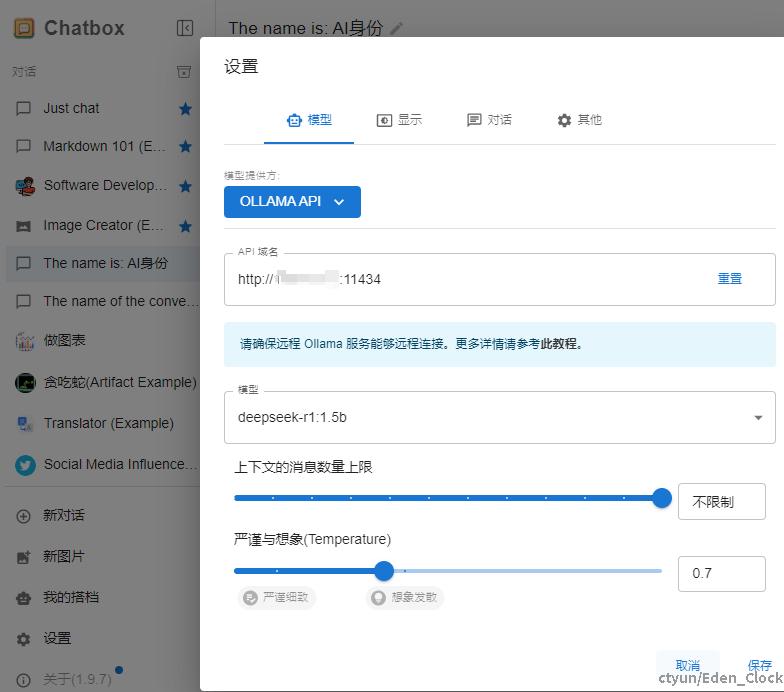

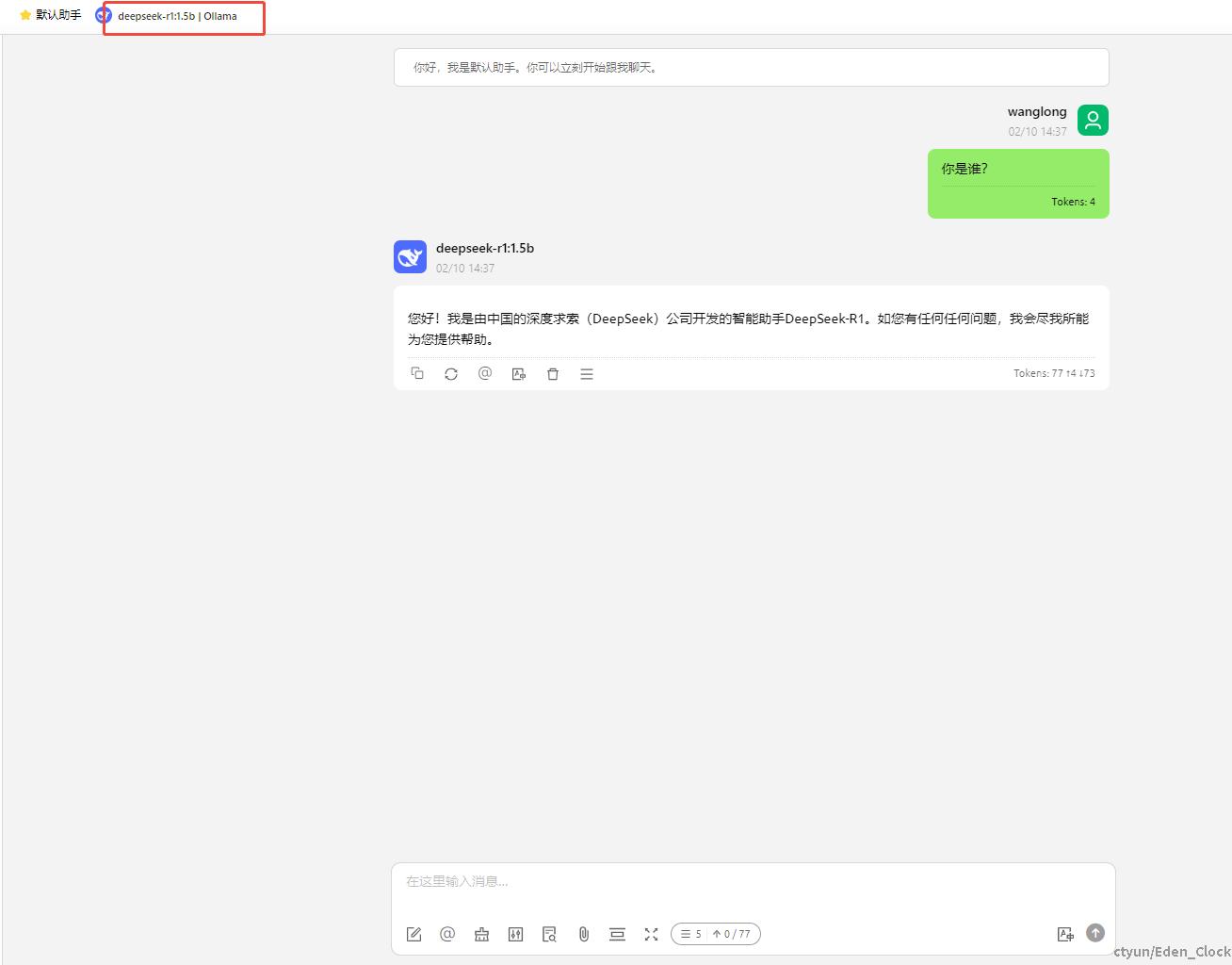

2、通过chatbox客户端

- 下载chatbox

- 配置chatbox

- 使用本地部署的deeseek-r1模型

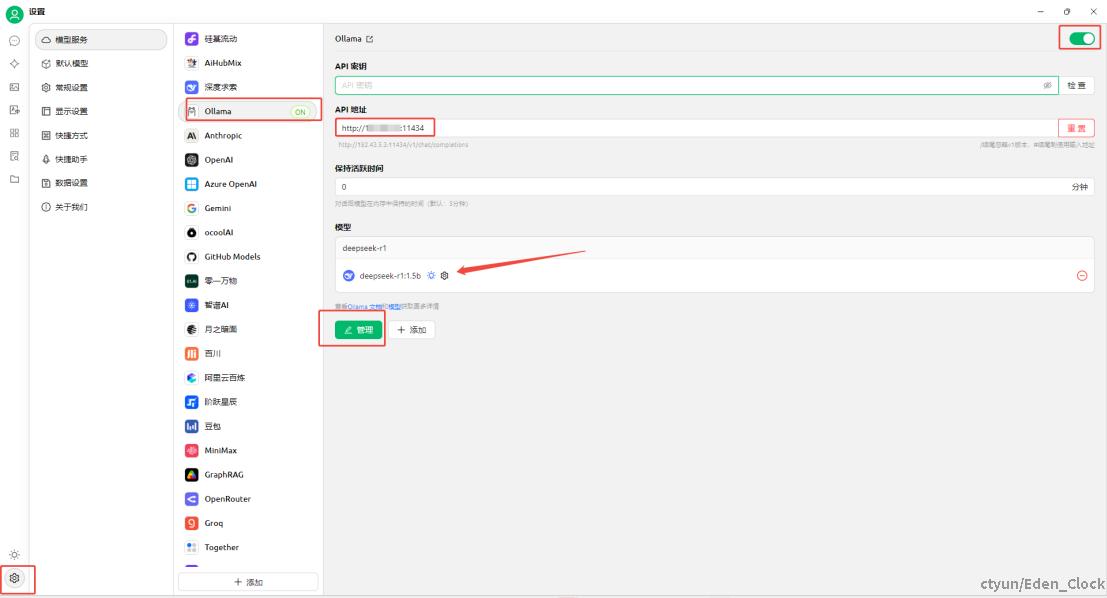

3、通过cherry studio客户端

- 下载安装cherry studio

- 配置cherry studio

- 使用本地部署的deeseek-r1模型

适用场景

1、个人开发与测试

快速部署本地AI模型,为您的开发项目提供灵活、高效的AI能力支持。

2、学习与研究

通过本地运行DeepSeek模型,深入理解AI技术原理,加速学习与研究进程。

3、个人知识库构建

构建专属的知识库,提升信息管理与检索效率,为您的学习与工作提供强大支持。

CTyunOS DeepSeek的核心优势

1、低资源需求

CTyunOS 作为一款高性能、高可靠性的操作系统,即使是低配置设备也能高效运行DeepSeek模型。

2、简单易用,快速上手

一键部署脚本与多种接入方式,让个人开发者无需复杂操作即可快速使用AI模型。

3、安全可控,数据无忧

所有数据与模型均在本地运行,确保您的开发数据隐私与安全。

常见问题解答

Q1:如何选择适合我的模型?

A1: 根据您的硬件配置和需求选择模型:

- 低资源设备:1.5B模型。

- 开发测试场景:7B模型。

- 高复杂度任务:14B及以上模型。

Q2:部署过程中遇到问题怎么办?

A2: 请联系CTyunOS技术支持团队,我们将竭诚为您提供帮助。