RAG技术总览

1. RAG的技术底层原理

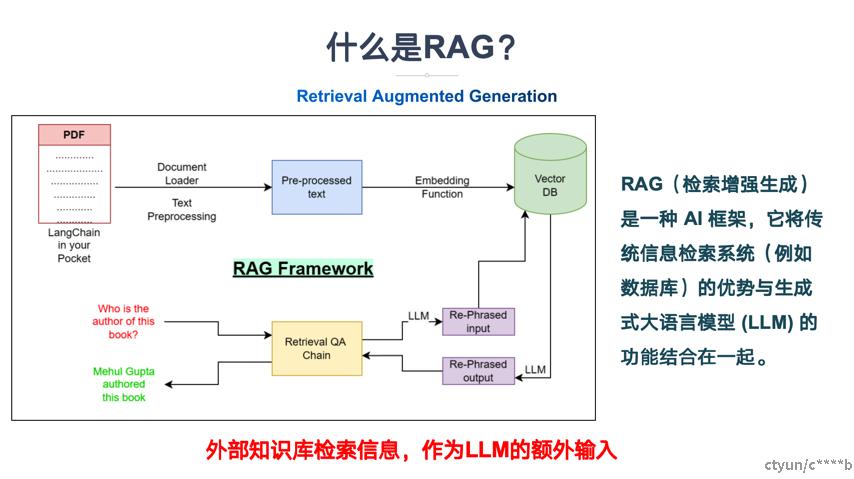

RAG(Retrieval-Augmented Generation)技术是一种结合了信息检索与生成模型的方法,旨在通过整合外部知识源,提高大语言模型(LLM)生成的答案的准确性和可信度。RAG系统主要包括两个主要阶段:检索(Retrieval)和生成(Generation)。

检索模块的底层原理:检索模块负责从外部知识库中检索与输入查询最相关的文档。这一过程主要涉及向量搜索技术,即将文档和查询映射到相同的向量空间中,通过计算向量之间的相似度来找到最相关的文档。具体来说,检索模块会使用预训练的模型(如BERT)将文档和查询转换为向量表示,这些向量表示捕获了文档和查询的语义信息,使得相似度的计算更加准确。

生成模块的底层原理:生成模块负责利用检索到的文档生成最终的回答。这一过程主要涉及序列到序列(Seq2Seq)的生成模型,如T5、BART等。在编码阶段,生成模块会将用户输入与检索到的信息相结合,通过提示词模板生成一个增强提示词,发送给LLM,由LLM生成最终答案。

2. RAG技术的核心难点

RAG技术在实际应用中面临着不少挑战:

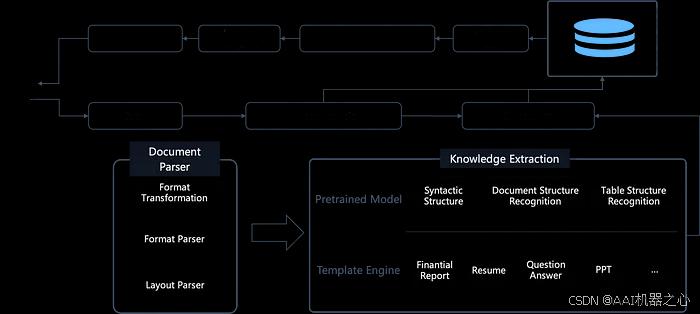

- 信息提取与向量化:在索引阶段,信息提取的完整性和准确性至关重要。由于文档格式的多样性,信息提取难度较大,数据清洗质量也参差不齐。此外,向量化处理虽然能够将文本数据转化为数值向量,便于后续处理,但也会在一定程度上造成信息损失,影响检索的准确性。

- 检索效率与准确性:在检索阶段,RAG需要快速准确地从海量数据中检索出与用户提问最相关的信息。然而,由于向量空间中的距离或相似度并不一定能反映真实的语义相似度,以及向量空间中的噪声和异常值的干扰,检索效率和准确性往往难以保证。

- 文件格式复杂性:以PDF为例,文件中不仅包含文字,还夹杂有图表和图片中的文字,这增加了信息提取的难度。

- 数据索引难点:包括数据切分和embedding模型的选择。数据切分过大或过小都会影响效果,而embedding模型的选择也是关键,如BGE、openAI的text-embedding-3以及CLIP等。

- 检索与生成的优化:包括query预处理、召回、重排技术以及prompt优化等。

3. 目前优秀的开源的RAG项目

以下是一些目前优秀的开源RAG项目:

- RAGFlow:RAGFlow是一款基于深度文档理解构建的开源RAG引擎,为不同规模的企业及个人提供精简的RAG工作流程,结合大语言模型(LLM)针对用户各类不同的复杂格式数据提供可靠的问答以及有理有据的引用。

- QAnything:QAnything是一个支持任何格式文件或数据库的本地知识库问答系统,可断网安装使用。支持的格式包括PDF、Word、PPT、XLS、Markdown、电子邮件、TXT、图片、CSV、网页链接等。

- FlashRAG:FlashRAG是一个用于复现和开发检索增强生成(RAG)研究的Python工具包,包括36个预处理的基准RAG数据集和15种最先进的RAG算法。

- TurboRAG:通过预计算的KV缓存加速检索增强生成,适用于分块文本。

4. 实践经验总结 RAGFlow与Dify

RAGFlow是一个专为深度文档理解和检索增强生成而设计的引擎,它结合了预训练的大型语言模型(LLMs)和高效的检索技术,为用户提供了一个强大的工具来处理复杂的问题和场景。RAGFlow的核心优势在于其混合检索能力,它能够从大规模知识库中检索相关文档,然后将这些信息与模型的生成能力相结合,生成更准确、更全面的答案。这种混合方法特别适用于处理需要深度理解和综合多个信息源的问题,如智能客服、搜索引擎和知识库应用。

Dify是一个开源的LLM应用开发平台,它提供了一站式的解决方案,使得开发者能够快速地从原型设计到产品部署。Dify的核心是其对LLM(大型语言模型)的集成,它支持多种预训练模型,并且允许用户自定义模型的训练和微调。Dify的用户界面直观,功能全面,使得开发者无需具备深厚的技术背景,也能轻松地开发基于LLM的应用。

结合RAGFlow和Dify的原因主要基于以下几点:

- 互补的技术优势:RAGFlow专注于深度文档理解和高效的信息检索,而Dify作为一个LLM应用开发平台,提供了模型集成、提示词编排、RAG引擎以及Agent框架等关键技术栈。通过结合两者,可以充分利用RAGFlow的文档解析能力和Dify的模型管理及应用开发能力,实现更全面的功能覆盖。

- 提高开发效率:Dify提供了直观的界面和API,使得开发者可以快速构建生产级的生成式AI应用,避免了重复造轮子的劳动。RAGFlow的集成可以进一步增强Dify在文档处理和知识库问答方面的能力,从而提升整体的开发效率。

- 优化RAG工作流:RAGFlow支持全面优化的RAG工作流,可以支持从个人应用到超大型企业的各类生态系统。Dify的集成可以使得这些工作流更加灵活和可定制,同时提供易用的API,方便集成到各类企业系统中。

- 强化多模态处理能力:RAGFlow在处理包含图表、图片等非文本元素的文档时,可以辅助提取和理解这些元素的语义信息。Dify的集成可以进一步增强这一多模态处理能力,使得系统在知识库问答、企业数据集成和多模态信息处理等场景下的应用潜力和效率得到提升。

- 提升系统的可解释性和可控性:RAGFlow在处理文档时强调了智能文档处理的可视化和可解释性,用户可以清晰地看到文档是如何被分块和解析的。Dify的集成可以进一步提供对AI处理结果的核查和必要的干预,确保最终输出的准确性和可靠性。

- 解锁新的场景和优化:RAGFlow和Dify的结合可以帮助解锁新的场景,并且根据RAGFlow开源遇到的新情况,把需要的能力下沉到数据库,解决效率和可用性的问题。

操作步骤与部署

- 本地部署问题:在本地部署RAGFlow时,可能会遇到文本解析不了的问题。这可能涉及到Redis、CPU核数分配、Elasticsearch文件配置或内存不足等问题。一个有效的解决办法是重新下载并运行RAGFlow,确保按照GitHub上的readme文件进行操作。

- 模型集成与部署:Dify平台简化了模型的集成和部署过程,使得开发者可以轻松地将RAGFlow技术应用到项目中,无需深入了解底层技术细节。

- 工作流自动化:通过Dify的RAG工作流编排能力,企业可以自动化处理大量文档,从数据提取到问题解答,无需人工干预,大大节省了时间和资源。

- 系统配置:在配置RAGFlow时,需要在

service_conf.yaml文件中配置LLM factory,并填写与选择的大模型相对应的API key。如果跳过系统确认步骤,浏览器可能会提示network abnormal或网络异常。