一、Ambari 集群 log4j 配置

HDP 集群 默认安装的,日志放在数据盘,但是 namenode和snamenode的数据盘本身不大只有 500G,在不经意间 数据盘被日志装满,首先从集群配置着手。

1.1.HDFS log4j

1.2.YARN log4j

1.3.Hive log4j

1.4.Solr log4j

1.5.Ranger log4j

二、脚本删除过期且较大的日志

HDP 集群 默认安装的,日志放在数据盘,但是 namenode和snamenode的数据盘本身不大只有 500G,在不经意间 数据盘被日志装满,我的日志放在 数据盘 /hadoop 下。

hdfs_log_path=/app/var/log/hadoop/hdfs/

log_tmp=/app/cluster_log/log_tmp/

find $hdfs_log_path -mtime +7 -size +500M -name 'hdfs-audit.log.*' | xargs -I '{}' mv {} $log_tmp

find $hdfs_log_path -mtime +7 -size +500M -name 'SecurityAuth.audit.*' | xargs -I '{}' mv {} $log_tmp

rm -rf $log_tmp/*find 参数: -mtime 7天前, -size 大于500M, -name 模糊匹配 , 匹配到之后移动到临时目录然后删除, 以此脚本简单示例可以自行添加删除的路径日志

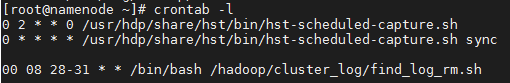

开启调度,每个月的 月末执行一次