一、前期准备:查看系统配置

在部署前,先了解下系统 “家底”。用这几个命令查看:

-

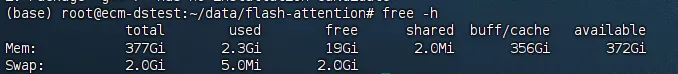

内存:

free -h,我的服务器显示有 377Gi 内存,运行各种程序都很流畅。 -

显存:

nvidia - smi,我这配备了 4 块 NVIDIA A100 - PCIE - 40GB 的 GPU,每块有 40960MiB 显存,大模型运算毫无压力。 -

操作系统版本:

lsb_release -a,是 Ubuntu22.04.5 LTS,稳定可靠。 -

CPU 核心数:

nproc或lscpu,我的有 96 个核心,多任务处理超高效。 -

磁盘信息:

df -h,像/dev/vdb挂载点有 1000G 空间,存数据、模型都够。 -

GPU 驱动版本:还是用

nvidia - smi查看,我的是 550.90.07 ,和 CUDA 配合得很好。

二、基础环境安装

1.安装 cuda:根据配置,我选了 CUDA Toolkit 12.8 版本下载。接着按下面命令操作:

wget https://developer.download.nvidia.com/compute/cuda/repos/ubuntu2204/x86_64/cuda-ubuntu2204.pin

sudo mv cuda-ubuntu2204.pin /etc/apt/preferences.d/cuda-repository-pin-600

wget https://developer.download.nvidia.com/compute/cuda/12.8.0/local_installers/cuda-repo-ubuntu2204-12-8-local_12.8.0-570.86.10-1_amd64.deb

sudo dpkg -i cuda-repo-ubuntu2204-12-8-local_12.8.0-570.86.10-1_amd64.deb

sudo cp /var/cuda-repo-ubuntu2204-12-8-local/cuda-*-keyring.gpg /usr/share/keyrings/

sudo apt-get update

要是报错,检查下磁盘空间够不够。不想用了,按这些命令卸载:

sudo apt-get autoremove nvidia-* sudo apt-get purge nvidia-* sudo apt --purge remove nvidia* sudo apt --purge remove "*cublas*" "cuda*" sudo apt --purge remove "*nvidia*" sudo apt autoremove sudo rm -rf /usr/local/cuda

2.安装 gcc:执行这串命令:

sudo apt-get install gcc-7 g++-7

sudo update-alternatives --install /usr/bin/gcc gcc /usr/bin/gcc-7 9

sudo update-alternatives --install /usr/bin/g++ g++ /usr/bin/g++-9 1

sudo update-alternatives --install /usr/bin/gcc gcc /usr/bin/gcc-9 1

sudo update-alternatives --display g++

sudo update-alternatives --display gcc

sudo update-alternatives --install /usr/bin/g++ g++ /usr/bin/g++-7 9

装完用 g++ -v查看版本,确认是否安装成功。

3.安装依赖环境:简单一条命令搞定:sudo apt-get update && sudo apt-get install gcc g++ cmake ninja-build。

4. 安装 conda:先装些依赖库:

apt install libgl1-mesa-glx libegl1-mesa libxrandr2 libxrandr2 libxss1 libxcursor1 libxcomposite1 libasound2 libxi6 libxtst6

然后下载安装包、创建目录并安装,按提示操作,记得选好安装路径。安装后初始化、创建环境并激活。再升级 pip、换源并安装一些基础工具:

cd /data

wget https://repo.anaconda.com/archive/Anaconda3-2024.10-1-Linux-x86_64.sh

mkdir anaconda3

bash Anaconda3-2024.10-1-Linux-x86_64.sh -u anaconda3

conda init

conda create --name ktrans python=3.11

conda activate ktrans

python -m pip install --upgrade pip

pip config set global.index-url https://mirrors.aliyun.com/pypi/simple/

pip config list

pip install torch packaging ninja cpufeature numpy

要是 pip 报错说磁盘空间不足,按这几步清理:

df -h /tmp

sudo rm -rf /tmp/*

df -h /root/data

export TMPDIR=/root/data/tmp

mkdir -p $TMPDIR

conda clean --all

- 安装 FlashAttention:在 conda 环境里执行:

pip install flash-attn --no-build-isolation。 - 安装 Ktransformers:去这个网址(https://github.com/kvcache-ai/ktransformers/releases/tag/v0.2.0 )下载对应的

.whl文件,上传到服务器后安装,比如:pip install ktransformers-0.2.0+cu124torch24avx2-cp311-cp311-linux_x86_64.whl。

三、DeepSeek - R1 - Q4 满血版测试

- 安装 git lfs:根据系统类型选命令安装,apt/deb 系统:

curl -s https://packagecloud.io/install/repositories/github/git-lfs/script.deb.sh | sudo bash sudo apt-get install git-lfs

yum/rpm 系统:

curl -s https://packagecloud.io/install/repositories/github/git-lfs/script.rpm.sh | sudo bash sudo yum install git-lfs

-

下载模型文件:

git lfs install GIT_LFS_SKIP_SMUDGE=1 git clone https://www.modelscope.cn/lmstudio-community/DeepSeek-R1-GGUF.git git lfs pull --include="DeepSeek-R1-Q4**" ls DeepSeek-R1-GGUF3.合并模型:

wget https://github.com/ggerganov/llama.cpp/releases/download/b4718/llama-b4718-bin-ubuntu-x64.zip unzip llama-b4718-bin-ubuntu-x64.zip cd /root/data/build/bin mkdir /root/data/models/DeepSeek-R1-GGUF/models/ ./llama-gguf-split --merge /root/data/models/DeepSeek-R1-GGUF/DeepSeek-R1-Q4_K_M-00001-of-00011.gguf /root/data/models/DeepSeek-R1-Q4.gguf

要是下载失败,先下到本地再上传到服务器。

- 运行模型:

git clone https://github.com/kvcache-ai/ktransformers.git cd ktransformers git submodule init git submodule update GIT_LFS_SKIP_SMUDGE=1 git clone https://hf-mirror.com/deepseek-ai/DeepSeek-R1 python -m ktransformers.local_chat --model_path /root/data/ktransformers/DeepSeek-R1 --gguf_path /root/data/models/

要是运行报错,提示 libstdc++.so相关问题,把 anaconda 环境里 libstdc++.so和 libstdc++.so.6的链接指向系统路径:ln -sf /usr/lib/x86_64-linux-gnu/libstdc++.so.6 /home/yourenvname/anaconda3/envs/pycode/bin/../lib/libstdc++.so.6 。

整个部署过程下来,天翼云的资源优势太明显了。强大的计算资源让每个步骤都能快速执行,稳定的系统环境减少了很多报错和异常情况。不管你是做 AI 科研、开发应用还是单纯体验大模型的魅力,天翼云都是个超棒的选择!大家赶紧动手试试,有问题评论区交流,一起玩转 Deepseek 模型!