背景:大型语言模型(LLMs)在复杂推理任务上表现突出,而小型语言模型(SLMs)面临挑战,如Mistral-7B在GSM8K数据集上的准确度仅为36.5%。微调可以提升推理能力,但许多LLM依赖的微调数据可能来自更强大的模型,如GPT-4。研究者探索使用更优的教师LLM或LLM自身知识来提升SLM的推理能力,例如通过自我探索和自我奖励的RAP方法。然而,自我探索方法存在问题,如难以有效探索解答空间和辨别高质量推理步骤,导致效果有限。

- 1.LLMs在探索解答空间时面临困难,自我探索方法可能因低质量推理而陷入困境。

- 2.SLMs难以识别高质量的推理步骤,且难以确认最终答案的正确性,导致自我探索效果不佳。

- 与GPT-4等大型模型相比,SLMs在自我优化和输出质量提升方面存在挑战,可能影响模型的广泛应用。

针对这些问题,微软亚洲研究院和哈佛大学提出rStar方法,通过自博弈相互推理提升SLMs的推理能力,无需依赖微调或更优模型。

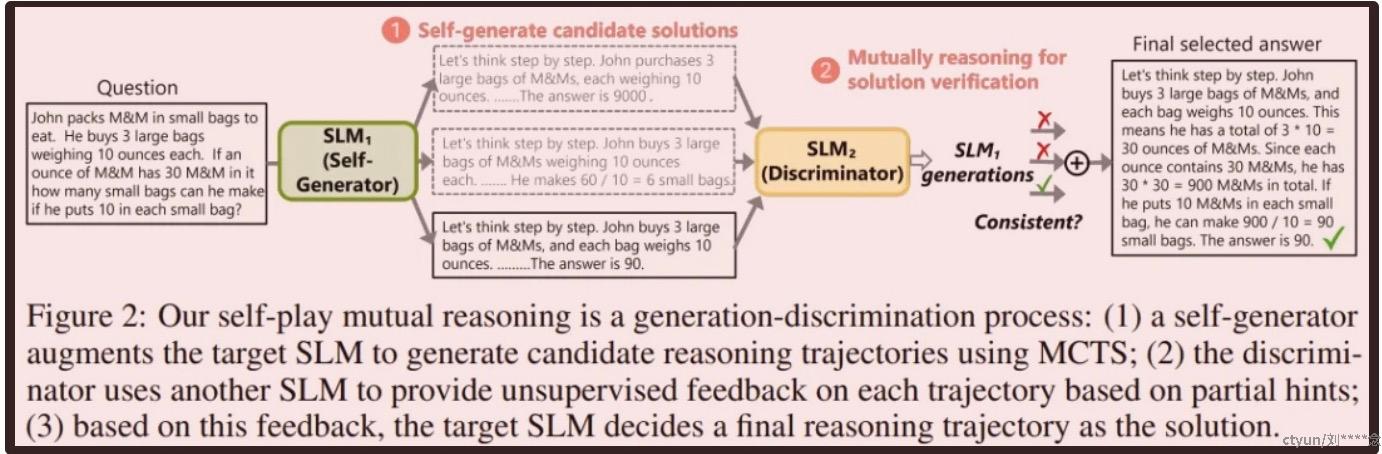

方法:为了解决上述难题,rStar 的做法是将推理过程分成了解答生成和相互验证两部分。

- 针对第一个难题,该团队引入了一个集合,其中包含丰富的类似人类的推理动作,可透彻地探索多种不同的推理任务空间。

- 针对第二个难题,他们设计了一个专门针对 SLM 的奖励函数,这能对中间步骤进行评估,从而避免依赖它们那往往并不可靠的自我评估。

- 此外,该团队还使用了另一个 SLM 作为判别器来增强 MCTS 过程,与判别器 SLM 互相验证每条轨迹的正确性。

使用 MCTS Rollout 自己生成推理轨迹

传统的MCTS方法通常依赖单一动作类型来构建决策树,这可能限制了探索效果。人类在解决问题时会采取多种策略,如分解问题、直接解决或重新表述问题,并根据情况灵活调整。受此启发,研究团队创建了包含五种不同推理动作的数据集,以增强SLM解决复杂问题的能力。

- 动作 1:提议一步思路。针对给定问题,该动作会让 LLM 基于已有的推理步骤生成接下来的一步思路。

- 动作 2:提议余下的思路步骤。该动作与标准 CoT 一样,能实现「快速思考」,从而解决只需少量步骤的简单问题。给定已经生成的推理步骤,它会让 LLM 直接生成剩余步骤,直到得到最终答案。

- 动作 3:提议下一个子问题及其答案。

- 动作 4:再次回答这个子问题。考虑到动作 3 有可能无法正确回答对应的子问题,因此这个动作的作用是再次回答它。

- 动作 5:重新表述问题 / 子问题。这个新动作是以更简单的方式重新表述该问题。具体来说,这里是让 LLM 清晰列出问题陈述中的所有条件。

以上五个动作定义了一个高度多样化的动作空间 {A1, A2, A3, A4, A5}。在每一步,MCTS从动作空间{A1, A2, A3, A4, A5}中选择一个动作,并基于当前状态生成新的推理步骤,注意某些动作需按特定顺序执行。

奖励函数

MCTS的关键组件之一是奖励函数,它评估动作的价值并指导树的扩展。该团队为SLM设计了一个基于AlphaGo的简单有效奖励函数,通过中间节点对最终答案的贡献来评分。初始时,未探索节点的奖励值设为0,以实现随机扩展。到达端节点后,根据答案的正确性计算奖励分数,并沿轨迹反向传播更新中间节点的奖励值。端节点的奖励值基于自洽多数投票的似然(置信度)。MCTS通过选取、扩展、模拟和反向传播等步骤生成候选推理轨迹。使用默认Rollout策略进行模拟,并执行多次Rollout以提高奖励估计的准确性。使用UCT平衡探索与利用,选取过程中考虑节点访问次数、估计奖励值和平衡常数。搜索到达端节点后,收集从根到端节点的轨迹作为候选解答。然后对这些轨迹进行验证,以确定最终的解答。

使用互恰性选择推理轨迹

基于收集到的所有轨迹,该团队提出使用推理互恰性来选择答案。

- 通过判别器 SLM 实现推理互恰性

如图 2 所示,除了目标 SLM 外,该团队还引入了一个判别器 SLM,其作用是为每个候选轨迹提供外部无监督反馈。

具体来说,对于 t = x ⊕ s_1 ⊕ s_2 ⊕ ... ⊕ s_d,遮掩从某个随机采样的步骤 i 处开始的推理步骤。然后将之前的推理轨迹 t = x ⊕ s_1 ⊕ s_2 ⊕ ... ⊕ s_{i-1} 作为 prompt 提供给判别器 SLM,让其补全剩余步骤。由于将之前的 i-1 个推理步骤作为了提示,因此难度降低了,判别器 SLM 便更有可能给出正确答案。

实验设置

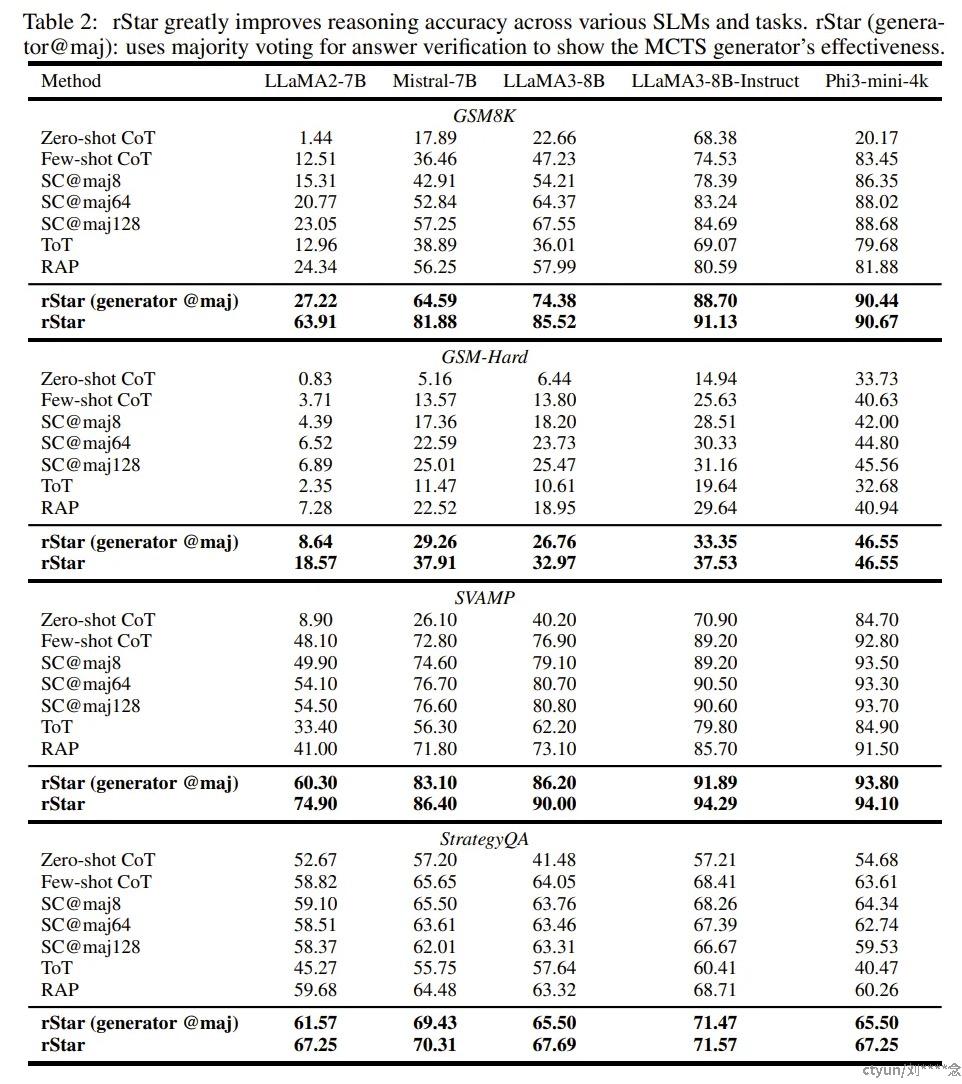

rStar 适用于多种 LLM 和推理任务。该团队评估了 5 个 SLM:Phi3-mini、LLaMA2-7B、Mistral-7B、LLaMA3-8B、LLaMA3-8B-Instruct。

测试的推理任务有 5 个,其中包括 4 个数学任务(GSM8K、GSM-Hard、MATH、SVAMP)和 1 个常识任务(StrategyQA)。

实验细节请访问原论文。

结果

该团队首先评估了 rStar 在一般推理基准上的有效性。表 2 比较了 rStar 和其它当前最佳方法在不同 SLM 和推理数据集上的准确度。为了演示新生成器的效果,该团队还提供了 rStar (generator @maj) 的准确度,即不使用判别器,仅使用多数投票来验证答案而得到的准确度。