本文算法核心

主要步骤

Search-based Reasoning Policy for LLM

简要概括:

- 常规做法(需要两个模型)

- 训练reward model预测solution的reward值(outcome reward model结果奖励模型);

- 额外训练模型预测s的集合p,获得正确答案所需要的最少推理步骤数目mk;

- 本文做法(只需要一个process reward model)

- 只需要训练一个过程奖励模型,因为Vk依赖于Vk-1、mk和Rs(reward model预测solution的reward值)

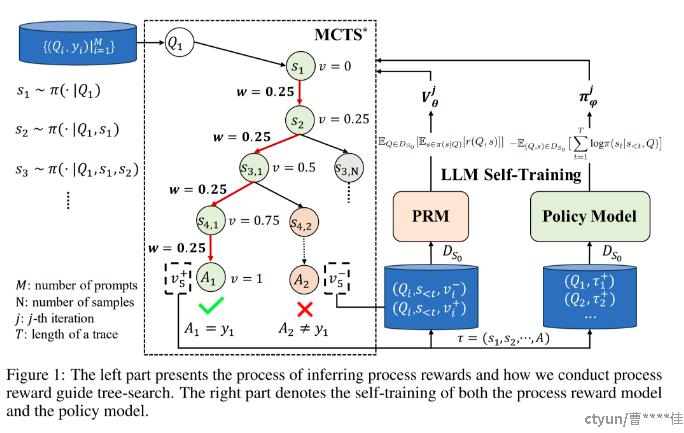

Self-Training ReST-MCTS∗ Pipeline

简要概括:

- 基于初始化后的policy model和reward model进行蒙特卡洛树搜索,生成用于训练policy model的新数据;

- 通过字符串匹配或LLM判断验证每个solution的正确性,这一步也就是数据标注过程;

- 使用标注后的新数据进行policy model和reward model的self-train,每一轮中使用前一轮训练得到的模型继续生成数据、标注、训练,从而逐步提升policy model和reward model的性能。

相关算法

Self-Consistency

https://arxiv.org/pdf/2203.11171.pdf

前提假设:正确的推理过程尽管都不相同,但是都会到达最后正确的答案,且答案是一致的;

核心:其实是提出了一种解码策略,取代之前用的greedy search。挑选多个reasoning path,通过边缘化(marginalizing out)这些推理路径来确定最优答案(如果很多reasoning path都能得到对应的一个答案,那么这个答案的置信度会比较大)

Best-of-N

https://arxiv.org/abs/2305.20050