多模态助力单模态,提高文本视频检索精度

多模态学习

多模杰学习(MultimodalLeaming)是一种利用来自多种不同感官或交互方式的数据进行学习的方法。在这个语境中,"模态”指的是不同类型的数据输入,如文本、图像、声音、视频等。多模态学习的关键在于整合和分析这些不同来源的数据,以获得比单一数据源更全面和

深入的洞察。

多模态学习在人工智能领域尤其重要,因为它模仿了人类处理信息的方式:我们不仅仅依赖视觉或听觉,而是将各种感官的信息综合起来以理解世界。主要特点如下,

(1)数据融合:将来自不同模态的数据(如图像和文本)结合在一起,以创建一个综合的数据表示,

(2)信息补充:不同模态的数据可以互相补充,提供一个更全面的视角。例如,文本可以提供图像中缺失的上下文信息。

(3)增强学习效果:通过结合不同模态的数据,可以提高学习算法的性能和准确性。

(4)复杂交互处理:在处理复杂的任务,如情感分析或语义理解时,多模态学习能够提供更丰富的信息来源。

(5)应对不完整或不准确的数据:在某些情况下,一个模态的数据可能不完整或不够准确,多模态学习可以通过其他模态的数据弥补这一不足。

视频文本检索

多模态学习对于视频文本检索非常重要,视频文本检索是人工智能领域中的一个关键任务。其主要挑战在于将视觉信息和文本信息对齐到同一个语义空间中,使得模型能够理解并匹配两种不同模态的输入。这要求模型不仅能够理解图像中的视觉内容,还能够将这些视觉内容与相应的文本描述进行准确的匹配。这一过程需要模型具备强大的语义理解能力,能够从图像中提取出高层次的语义特征,并在文本中找到相应的描述。

近年来,随着大规模预训练模型的提出,视频文本检索模型的性能得到了显著提升。例如,像CLIP4CIP和CLIP2VIDEO这样的模型,通过在大规模的图像和文本数据上进行对比学习,实现了视觉和文本模态的对齐。这些模型在训练过程中学习到了丰富的语义特征,能够在视觉和文本之间建立起准确的对应关系,从而在视频文本检索任务中表现出色。然而,这些模型通常仅限于视觉模态的输入,忽略了视频中其他模态的信息,如音频和动作等。虽然视觉模态在视频文本检索中起着重要作用,但仅依赖视觉模态存在一些明显的局限性。例如,视觉模态可能无法充分捕捉视频中的声音、环境音效、人物对话等信息。而这些信息往往是理解视频内容的重要补充。此外,视觉信息有时可能不够清晰或明确,尤其是在视频质量较差或场景复杂的情况下。单一模态的使用可能导致召回结果的相关性和多样性不足,无法全面反映视频内容。

多模态信息的引入

音频信息的作用

音频信息在视频文本检索中可以提供重要的补充。例如,通过捕捉环境音效、背景音乐和人物对话,模型可以获得更加丰富的上下文信息。这些信息有助于模型更好地理解视频场景,从而提高检索结果的相关性。例如,在一个足球比赛的视频中,观众的欢呼声、解说员的评论和背景音乐都能提供关于比赛进展的重要线索。

动作信息的作用

动作信息,特别是通过动作识别技术获取的动态行为特征,可以进一步增强视频文本检索的能力。例如,在一个包含体育动作的视频中,模型可以通过识别运动员的动作来更好地理解视频内容,并将其与相应的文本描述进行匹配。动作信息还可以帮助模型在视频中的不同片段之间建立时间和空间上的关系,从而提高召回结果的多样性。

召回率的提升

通过引入多模态信息,如音频和动作,视频文本检索的召回率可以大幅度提升。多模态信息的结合使得模型能够从多个角度理解和描述视频内容,从而更准确地匹配文本查询。这种多角度的理解不仅提高了召回结果的相关性,还增加了检索结果的多样性,使得用户能够获得更加全面和丰富的检索体验。

多模态学习旨在处理和整合来自不同模态的信息,如视觉、音频和文本。近年来,预训练模型在各种任务中表现出色,许多研究人员尝试使用这些预训练模型(即experts)来提取各个模态的特征表示(embedding)。例如,MMT(Multimodal Transformer)和MDMMT(Multimodal Deep Matching Transformer)等方法尝试结合不同模态的信息,以改进任务表现。MMT,MDMMT等方法 尝试利用多任务预训练模型(experts)来提取多模态的嵌入表示(embedding),然后使用 transformer 结构对这些嵌入进行融合。然而,不同预训练模型提取的嵌入表示在分布上存在巨大差异,因此很难通过一个简单的模块来有效融合这些多模态信息。此外,这种“黑盒”融合方式缺乏可解释性,难以确定最终的输出结果是否真正代表了多模态信息,还是仅仅引入了一些“可学习的随机输入”。

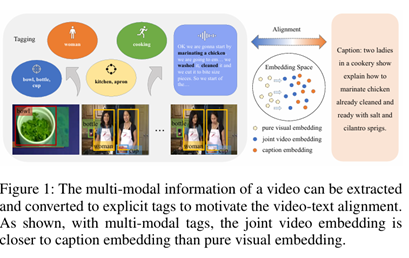

针对以上问题,学者提出了一个新的以多模态标签为引导的视频-文本检索模型:TABLE(TAgging Before aLignmEnt)。TABLE模型通过在标签域内融合多模态信息,以促进视觉和文本的语义对齐。该模型的核心思想是先提取视频各个模态的信息,再在标签域进行融合,最终生成的多模态标签作为锚点(anchor)来提高视频-文本语义对齐的效果。

多模态信息提取

TABLE模型使用多种预训练的专家模型(experts)来提取不同类型的模态信息,包括:物体和人物信息:聚焦于视频中的局部或实体特征,例如识别出视频中的具体物体和人物。如图所示:

(1)物体检测:

通过目标检测器,可以提取视频中的物体标签,如“bowl(碗)”、“bottle(瓶子)”等。

这些物体标签主要聚焦于视频中的具体物体,是视频的局部特征。

(2)人物检测:通过目标检测器,可以提取视频中的人物标签,如“woman(女人)”。

人物标签帮助识别视频中的参与者,是视频内容的重要组成部分。

(3)场景分类:通过图像分类器,可以获得视频的场景标签,如“kitchen(厨房)”。

场景标签提供了视频的背景信息,有助于理解视频的整体环境。

(4)动作检测:通过动作检测器,可以获得视频中的动作标签,如“cooking(烹饪)”。

动作标签捕捉了视频中的动态信息,是视频区别于静态图像的重要特征。

音频信息:通过自动语音识别(ASR)和关键词提取,可以获得音频标签,如“marinating a chicken(腌制鸡肉)”。音频标签提供了视觉信息之外的辅助信息,有助于更全面地理解视频内容。

标签域的融合优势

(1)统一、易解释的表征:

不同专家模型生成的嵌入表示在分布上存在巨大差异,直接融合这些嵌入表示非常困难。而标签域提供了一种统一的表征方式,使得不同模态信息能够在一个共同的空间中进行融合。

标签域的这种方式可以为不同模态信息生成易于解释的表征,有助于模型理解和处理。

(2)综合学习多模态特征:

多模态标签作为锚点,迫使模型综合学习视频的局部特征(如物体和人物)、全局特征(如场景)、时间特征(如动作)以及其他补充特征(如音频)。

这种综合学习方式使得模型能够更加准确地捕捉视频中的重要信息,提升视频-文本召回的整体效果。

整体效果提升

通过将视频的多模态信息转化为标签,TABLE模型能够在视觉和文本之间建立更加准确和高效的对齐关系。具体来说:

(1)重要片段和区域的凸显:在多模态标签的作用下,视频的重要片段(时间)和重要区域(空间)得到凸显,使得模型能够更好地捕捉到视频中的关键信息。

(2)提升视频-文本对齐效果:由于多模态标签提供了丰富的上下文信息,模型在视频-文本检索和召回任务中表现更加优异。

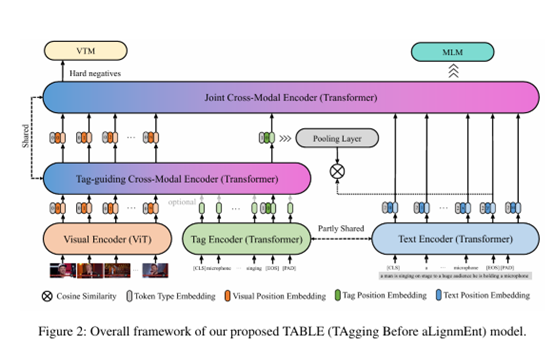

TABLE模型的结构分析

从图二可以看出,TABLE模型包含了四个编码器:视觉编码器、标签编码器、文本编码器以及跨模态编码器。该模型通过多模态信息的融合和标签的使用,提升了视频与文本对齐的效果。以下是对TABLE模型结构的详细讨论:

1. 视觉编码器(Visual Encoder)

视觉编码器使用了预训练的视觉Transformer(ViT)来提取视频帧中的特征。这些特征包括物体、人物、场景和动作等局部和全局特征。这一步骤为后续的多模态信息融合提供了丰富的视觉特征。

2. 标签编码器(Tag Encoder)

标签编码器使用Transformer架构,将提取到的标签信息进行编码。这些标签包括视频中的物体、场景、动作和音频等,标签编码器将这些多模态标签转化为统一的表征,用于后续的融合。

3. 文本编码器(Text Encoder)

文本编码器同样使用Transformer架构,对文本信息进行编码。通过将文本信息转化为嵌入表示,文本编码器为多模态信息的对齐提供了文本特征。

4. 跨模态编码器(Cross-Modal Encoder)

跨模态编码器由两个部分组成:标签引导的跨模态编码器和联合跨模态编码器。

标签引导的跨模态编码器(Tag-guiding Cross-Modal Encoder):通过引入标签信息来指导视频和文本的融合。这一步骤利用标签信息作为锚点,帮助模型更好地理解和对齐视频和文本中的重要特征。

联合跨模态编码器(Joint Cross-Modal Encoder):整合了视觉特征、标签特征和文本特征,通过Transformer架构实现多模态信息的联合编码。这一步骤进一步融合了多模态信息,并通过池化层(Pooling Layer)进行特征的聚合和选择。

监督信号与任务

视频文本匹配损失(Video Text Matching Loss, VTM):通过引入负样本(hard negatives),该损失函数帮助模型学习更准确的视频和文本对齐。

掩码语言模型损失(Masked Language Modeling, MLM):作为额外的监督信号,MLM损失帮助模型在跨模态编码中更好地理解文本细节。

TABLE模型的优势

多模态特征的充分利用:通过提取并融合物体、人物、场景、动作和音频等多模态信息,TABLE模型能够更全面地理解视频内容。

标签的引导作用:标签域提供了统一、易解释的表征,使得不同模态信息在融合过程中更为协调,从而提高了视频和文本对齐的准确性。

增强的监督信号:通过引入VTM和MLM任务,模型在多模态信息的联合编码中得到了更为细致的监督,从而提升了对齐效果。

优异的性能表现:在MSR-VTT、MSVD、LSMDC和DiDeMo等常用视频检索数据集上,TABLE模型取得了最先进的效果(SOTA),证明了其在多模态对齐任务中的优越性。