一、离线环境搭建

参考llama2大模型训练实战连载文《Chinese LLaMA2预训练和指令精调实战-离线环境搭建》

二、训练前准备

参考llama2大模型训练实战连载文《Chinese LLaMA2预训练和指令精调实战-训练前准备》

三、预训练

参考llama2大模型训练实战连载文《Chinese LLaMA2预训练和指令精调实战-预训练》

四、精调

-

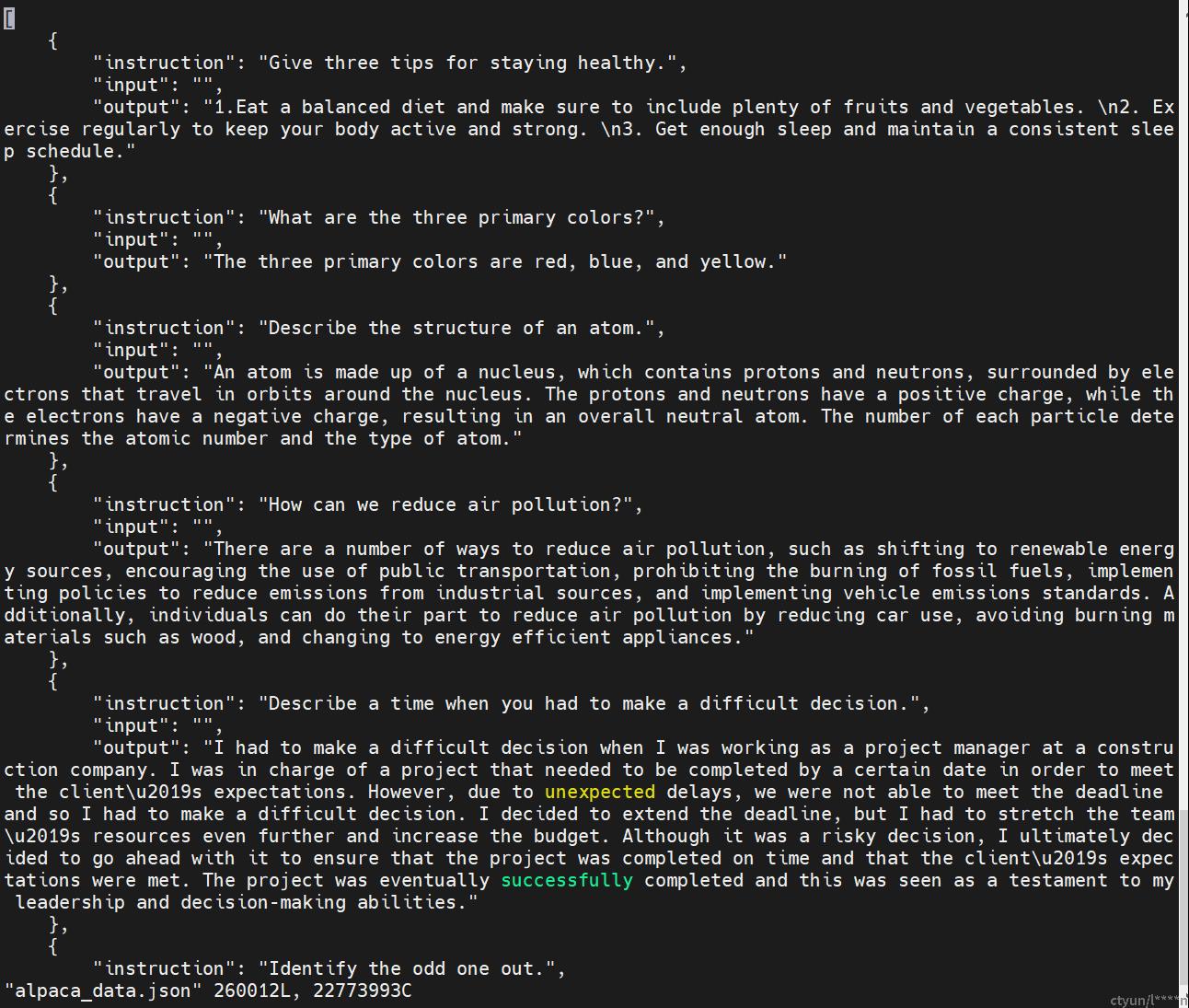

输入格式 .json,Stanford Alpaca格式

- 原版Stanford Alpaca不带input的模版。对于包含input字段的数据,采用f"{instruction}+\n+{input}"的形式进行拼接。

[

{"instruction" : ...,

"input" : ...,

"output" : ...},

...]

- 指令精调代码 github.com/ymcui/Chinese-LLaMA-Alpaca-2/blob/main/scripts/training/run_clm_sft_with_peft.py

- bash run_sft.sh进行指令精调

lr=1e-4

lora_rank=64

lora_alpha=128

lora_trainable="q_proj,v_proj,k_proj,o_proj,gate_proj,down_proj,up_proj"

modules_to_save="embed_tokens,lm_head"

lora_dropout=0.05

pretrained_model=/root/llama/correspond_output_dir

chinese_tokenizer_path=/root/llama/correspond_output_dir

dataset_dir=data_pt

per_device_train_batch_size=1

per_device_eval_batch_size=1

gradient_accumulation_steps=8

max_seq_length=512

output_dir=sft_output_dir2

validation_file=data_pt/alpaca_data_zh_51k.json

training_steps=6000

# 参数解释

tokenizer_name_or_path: Chinese-LLaMA-2 tokenizer所在的目录。

dataset_dir: 指令精调数据的目录,包含一个或多个以json结尾的Stanford Alpaca格式的指令精调数据文件

validation_file: 用作验证集的单个指令精调文件,以json结尾,同样遵循Stanford Alpaca格式

flash_attn: 启用FlashAttention-2加速训练

deepspeed_config_file=scripts/training/ds_zero2_no_offload.json

torchrun --nnodes 1 --nproc_per_node 7 scripts/training/run_clm_sft_with_peft.py \

--deepspeed ${deepspeed_config_file} \

--model_name_or_path ${pretrained_model} \

--tokenizer_name_or_path ${chinese_tokenizer_path} \

--dataset_dir ${dataset_dir} \

--per_device_train_batch_size ${per_device_train_batch_size} \

--per_device_eval_batch_size ${per_device_eval_batch_size} \

--do_train \

--do_eval \

--eval_steps 1000 \

--seed $RANDOM \

--fp16 \

--num_train_epochs 1 \

--lr_scheduler_type cosine \

--learning_rate ${lr} \

--warmup_ratio 0.03 \

--weight_decay 0 \

--logging_strategy steps \

--logging_steps 10 \

--save_strategy steps \

--save_total_limit 3 \

--evaluation_strategy steps \

--eval_steps 6000 \

--save_steps 3000 \

--gradient_accumulation_steps ${gradient_accumulation_steps} \

--preprocessing_num_workers 8 \

--max_steps ${training_steps} \

--max_seq_length ${max_seq_length} \

--output_dir ${output_dir} \

--overwrite_output_dir \

--ddp_timeout 30000 \

--logging_first_step True \

--lora_rank ${lora_rank} \

--lora_alpha ${lora_alpha} \

--trainable ${lora_trainable} \

--lora_dropout ${lora_dropout} \

--modules_to_save ${modules_to_save} \

--torch_dtype float16 \

--validation_file ${validation_file}

- 合并模型

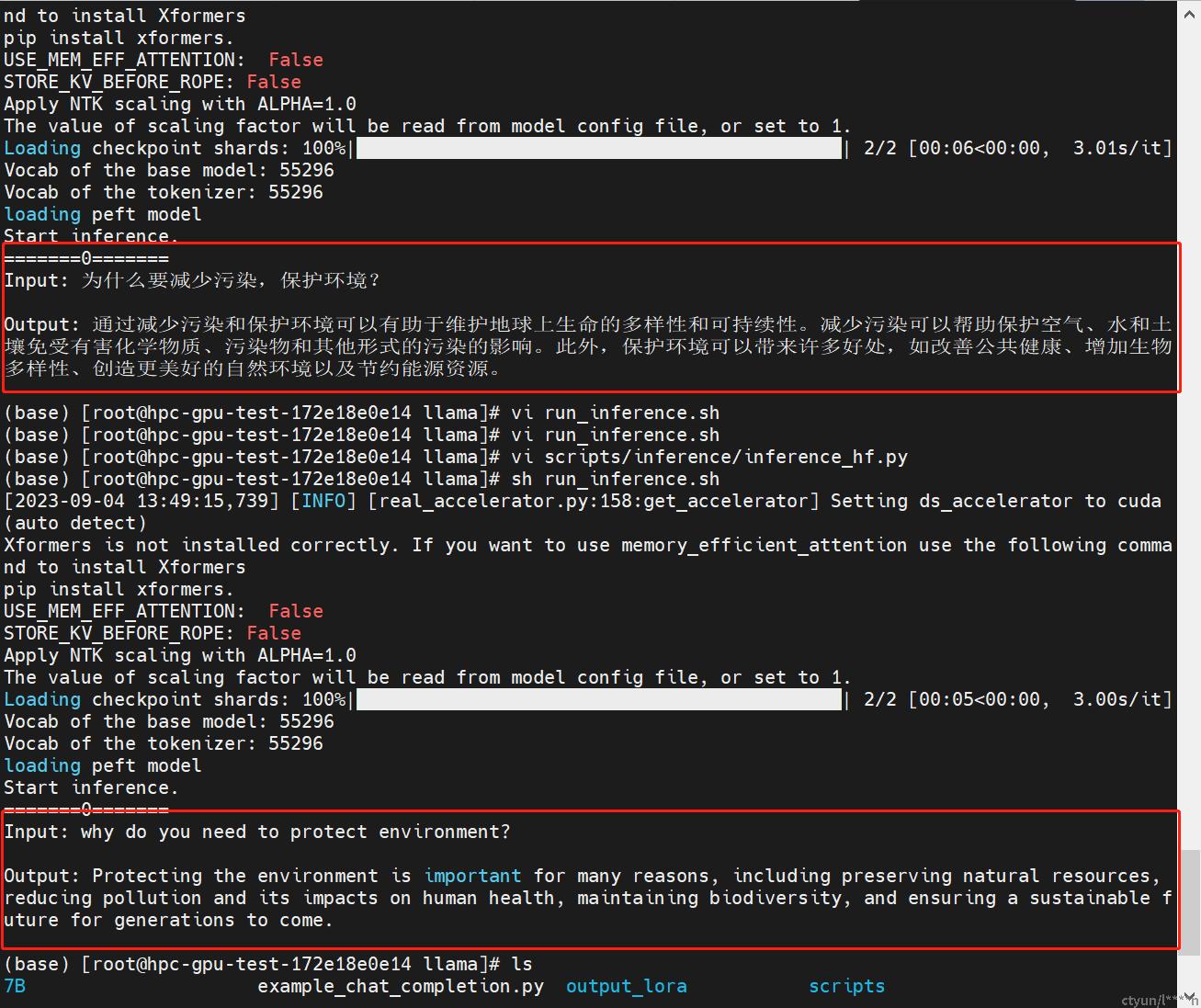

- 推理

- 推理代码github.com/ymcui/Chinese-LLaMA-Alpaca-2/blob/main/scripts/inference/inference_hf.py

- 推理脚本

python scripts/inference/inference_hf.py \

--base_model correspond_output_dir \

--lora_model sft_output_dir2/sft_lora_model \

--tokenizer_path correspond_output_dir \

--with_prompt \

--gpus 1

# 参数解释

with_prompt 使用提示自动包装输入

gpus 使用哪个GPU

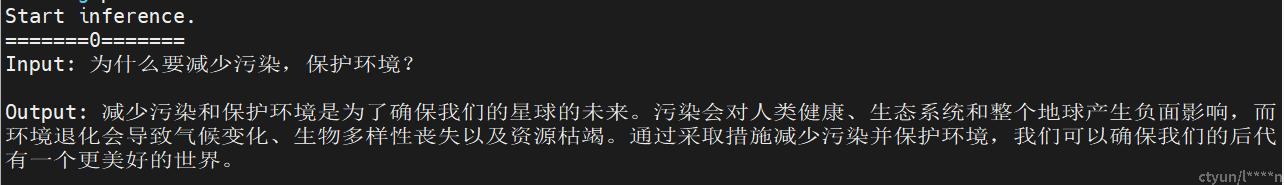

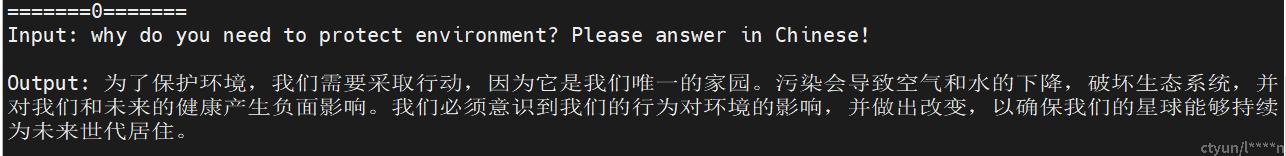

- 推理结果

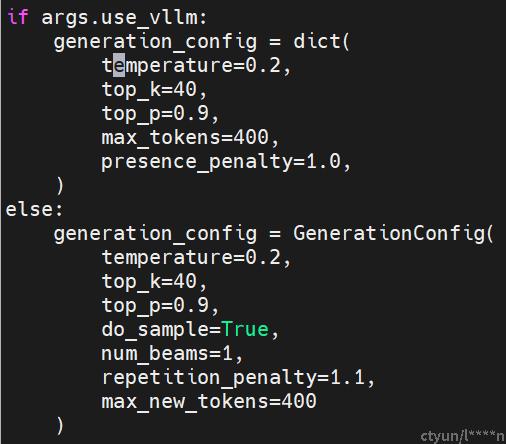

- 可以发现每次的回答不一样,这是因为设置了如下参数temperature, top_k, top_p

-

- vllm加速推理

- 参数理解

if args.use_vllm:

generation_config = dict(

temperature=0.2,

top_k=40,

top_p=0.9,

max_tokens=400,

presence_penalty=1.0,

)

else:

generation_config = GenerationConfig(

temperature=0.2,

top_k=40,

top_p=0.9,

do_sample=True,

num_beams=1,

repetition_penalty=1.1,

max_new_tokens=400

)

# 参数解释

temperature:文本生成的随机性,temperature越大随机性越高,设置为0,则相同的提示会产生相同的结果。0温度相当于 argmax 似然,而无限温度相当于均匀采样。

top_k: 从概率最高的 k 个单词中进行随机采样

top_p: 核采样(nucleus sampling),只从累积概率超过某个阈值 p 的最小单词集合中进行随机采样,为了限制低概率token的长尾,一般设置的比较高。

如果 k 和 p 都启用,则 p 在 k 之后起作用。

max_tokens:文本生成的最大长度。

presence_penalty:(阻止调整: [-2,2] ),防止模型引入新的话题。控制文本同一词汇重复情况。当此参数值大于0时,将鼓励模型生成不同的单词,并尽可能避免使用已经在之前生成的文本中出现过的单词。如果presence_penalty值越大,生成的文本中不同单词的数量可能越多。如果presence_penalty值为0,则不会考虑之前生成的单词,并且每次生成的单词概率分布都是相同的。 例如,在文本生成任务中,如果需要鼓励生成不同的单词,并且避免使用相同的单词,可以增大presence_penalty的值。

frequency_penalty:(阻止调整: [-2,2] ),控制文本罕见词汇出现情况。当此参数值大于0时,将抑制模型生成频繁出现的单词,并鼓励生成罕见的单词。如果frequency_penalty值越大,生成的文本中罕见单词的数量可能越多。如果frequency_penalty值为0,则不会考虑单词的频率,并且每次生成的单词概率分布都是相同的。 如果需要鼓励生成罕见的单词,可以增大frequency_penalty的值。

num_beams: 每一时间步选择num_beams个词,并从中最终选择出概率最高的序列

Beam-search:do_sample = False, num_beams>1

Multinomial sampling(多项式采样):

每一个时间步,根据概率分布随机采样字(每个概率>0的字都有被选中的机会)。do_sample = True, num_beams = 1

Beam-search multinomial sampling:结合了Beam-search和multinomial sampling的方式,每个时间步从num_beams个字中采样,参数:do_sample = True, num_beams > 1