1. kubectl 命令

1.1. 系统梳理

kubectl语法通式可表示为:kubectl [command] [TYPE] [NAME] [flags]

其中:

- command:指定在一个或多个资源上要执行的操作。例如:create、get、describe、delete、apply等

- TYPE:指定资源类型(如:pod、node、services、deployments等)。

- NAME:指定资源的名称。名称大小写敏感。如果省略名称空间,则显示默认名称空间资源的详细信息或者提示:No resources found in default namespace.。

- flags:指定可选的标记。例如,可以使用 -s 或 --server标识来指定Kubernetes API服务器的地址和端口;-n指定名称空间;等等。

注:在多个资源上执行操作时,可以通过类型 [TYPE] 和名称 [NAME] 指定每个资源,也可以指定一个或多个文件。

kubectl输出选项:

将详细信息以特定的格式输出到终端窗口,可以将 -o 或 --output标识添加到受支持的kubectl命令中

kubectl [command] [TYPE] [NAME] -o <output_format>

1.2. 查看类命令

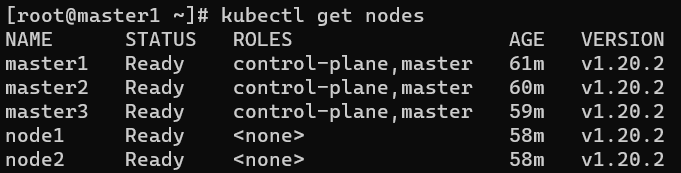

kubectl get nodes #获取节点信息

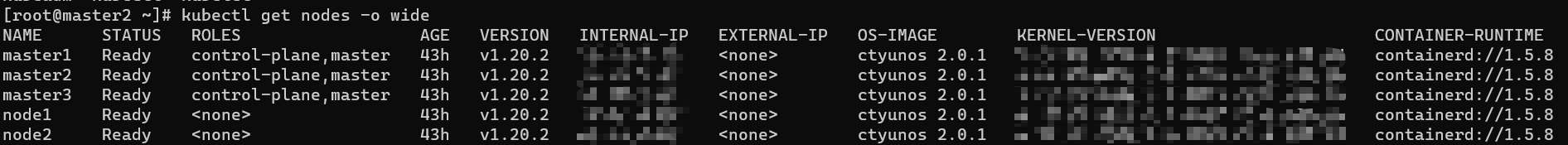

kubectl get nodes -o wide #获取节点和服务版本信息,并查看附加信息

kubectl get Service/svc #查看Service信息,默认查找的是default环境的service信息

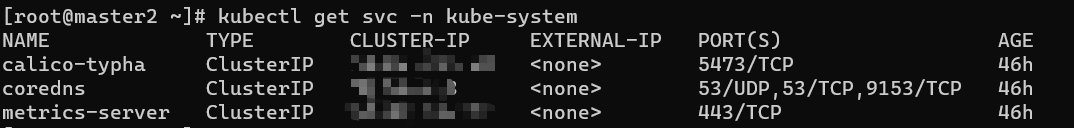

kubectl get svc -n kube-system # 查看指定名称空间的service信息

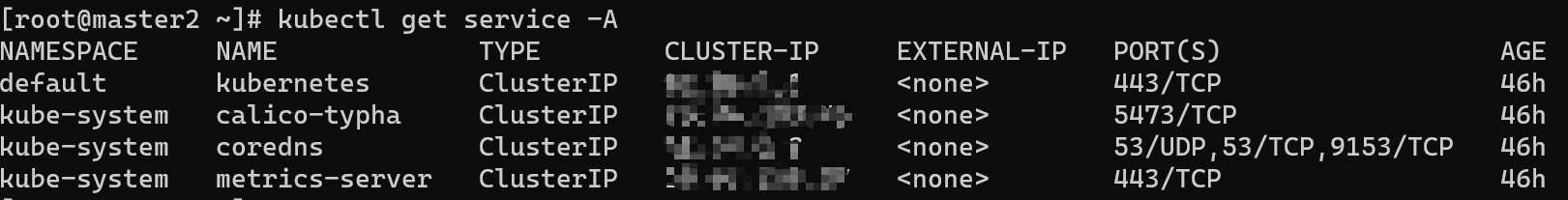

kubectl get svc -A # 查看全部名称空间的service信息

kubectl get pods --all-namespaces 或者 kubectl get pods -A 查看所有资源

kubectl get pods -n kube-system

kubectl get pod -n kube-system podName # 获取指定名称空间中的指定pod

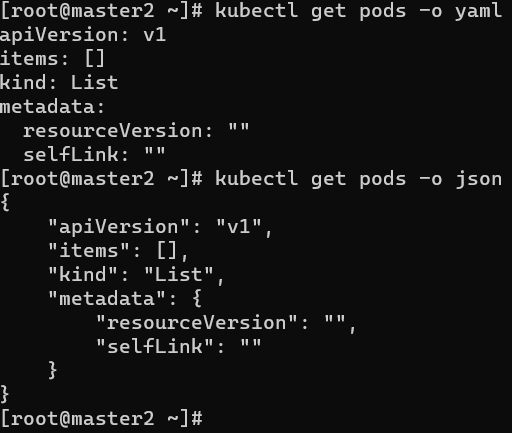

kubectl get pods -o yaml # 查看pod的详细信息,以yaml格式或json格式显示

kubectl get pods -o json

kubectl get pod -A --show-labels # 查看pod的标签信息

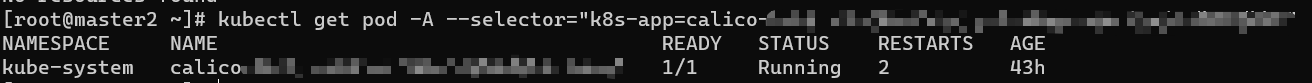

kubectl get pod -A --selector="k8s-app=kube-dns" # 根据Selector(label query)来查询pod

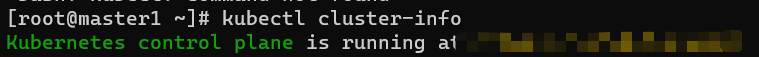

kubectl cluster-info #查看集群信息

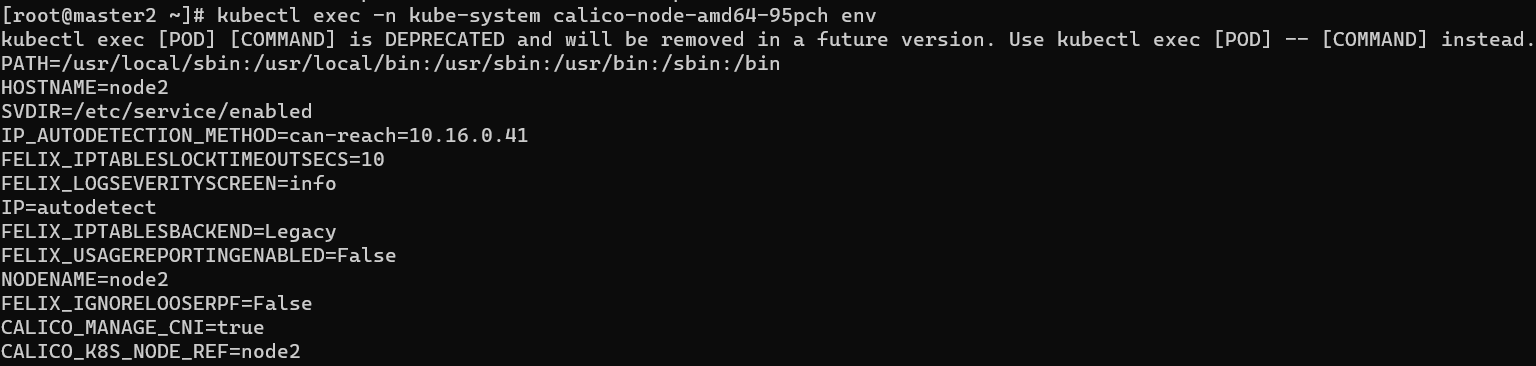

kubectl exec -n kube-system [podname] env # 查看运行pod的环境变量

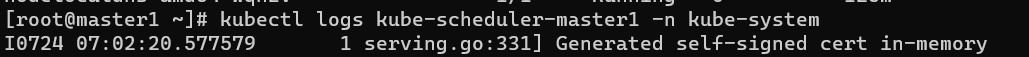

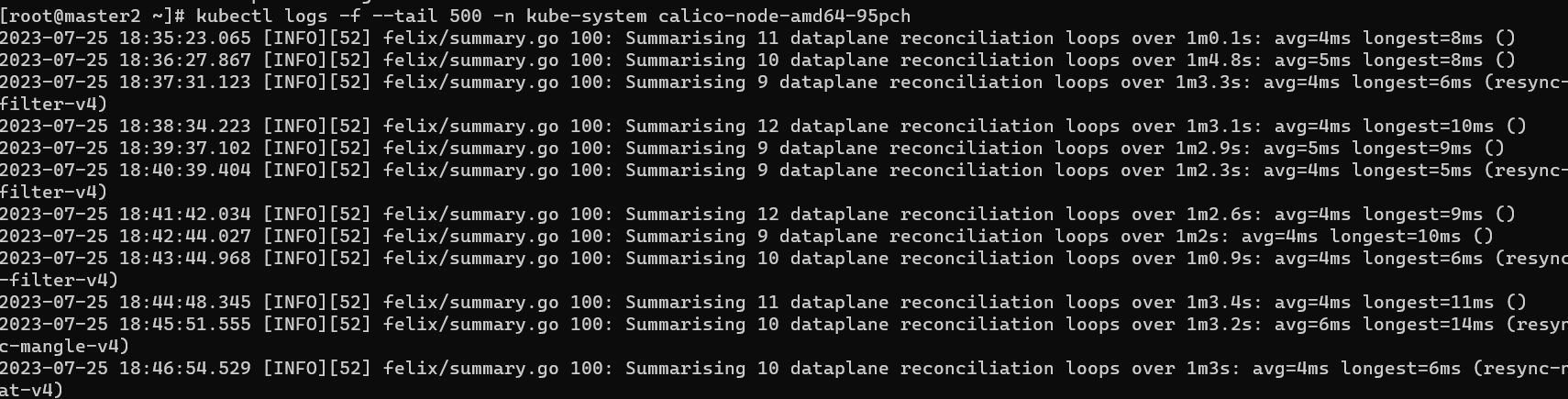

kubectl logs -f --tail 500 -n kube-system kube-apiserver-k8s-master

# 查看指定pod的日志, tail 命令可实时查看日志。-n 参数指定行数,如-n 100 表示查看最新的 100 行日志。

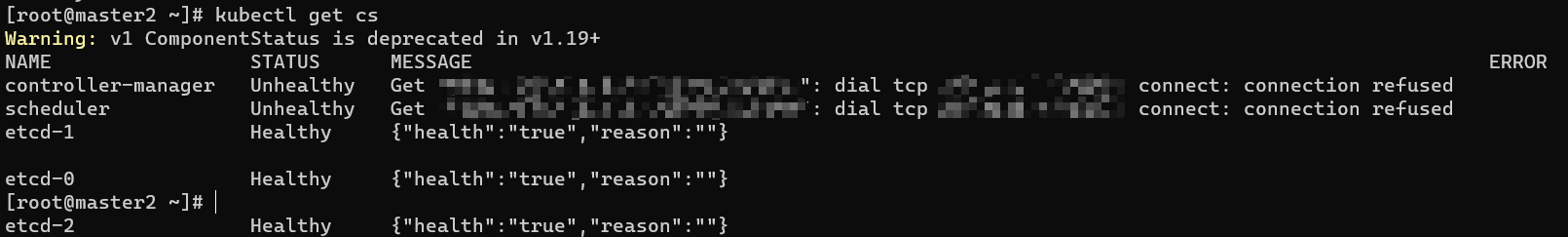

kubectl get cs # 查看componentstatuses信息

# 查看所有configmaps信息 38 kubectl get cm -A

kubectl get sa -A # 查看所有serviceaccounts信息

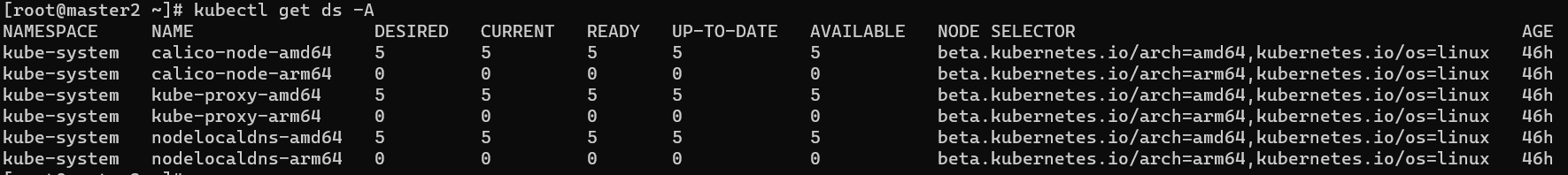

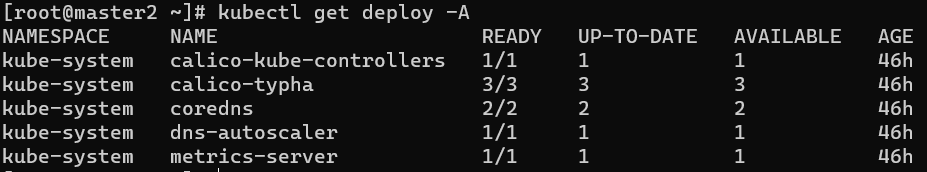

kubectl get deploy -A # 查看所有deployments信息

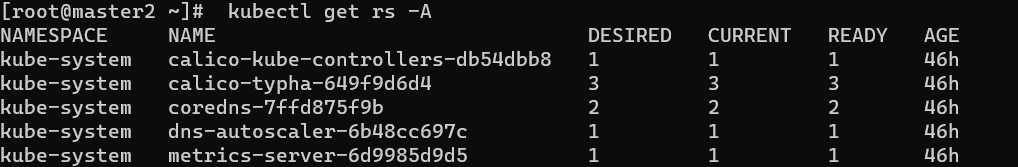

kubectl get rs -A # 查看所有replicasets信息

kubectl get sts -A # 查看所有statefulsets信息

kubectl get jobs -A # 查看所有jobs信息

kubectl get ing -A # 查看所有ingresses信息

kubectl get ns# 查看有哪些名称空间

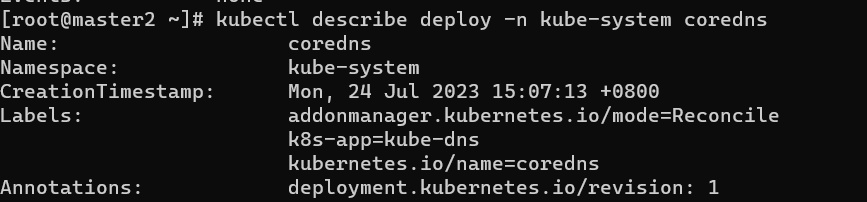

# kubectl describe deploy -n kube-system coredns 查看指定名称空间中指定deploy的描述信息

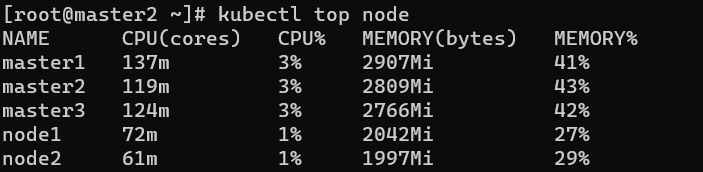

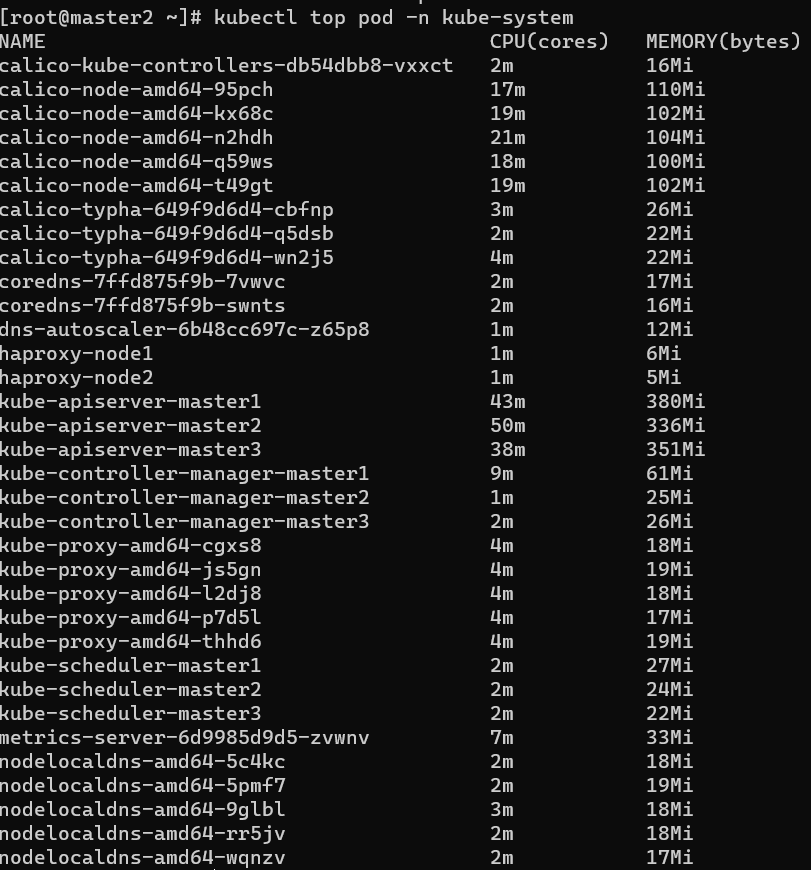

# 查看node或pod的资源使用情况

# 需要heapster 或metrics-server支持

kubectl top node

kubectl top pod

1.3. 操作类命令

# 创建资源

kubectl create -f xxx.yaml

# 应用资源

kubectl apply -f xxx.yaml

# 应用资源,该目录下的所有 .yaml, .yml, 或 .json 文件都会被使用

kubectl apply -f <directory>

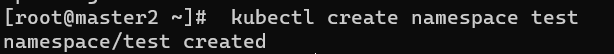

# 创建test名称空间

kubectl create namespace test

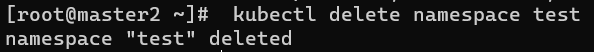

# 删除test名称空间

kubectl delete namespace test

# 删除资源

kubectl delete -f xxx.yaml

kubectl delete -f <directory>

# 删除指定的pod

kubectl delete pod podName

# 删除指定名称空间的指定pod

kubectl delete pod -n test podName

# 删除其他资源

kubectl delete svc svcName

kubectl delete deploy deployName

kubectl delete ns nsName

# 强制删除

kubectl delete pod podName -n nsName --grace-period=0 --force

kubectl delete pod podName -n nsName --grace-period=1

kubectl delete pod podName -n nsName --now

# 编辑资源

kubectl edit pod podName

1.4. 进阶命令

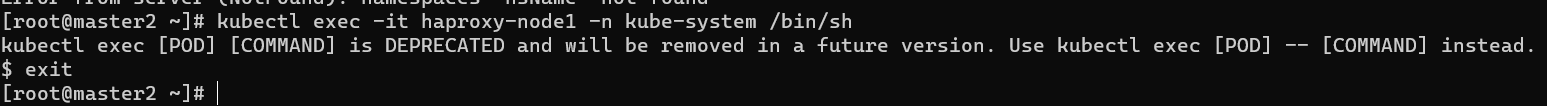

# kubectl exec:进入pod启动的容器

kubectl exec -it podName -n nsName /bin/sh #进入容器

kubectl exec -it podName -n nsName /bin/bash #进入容器

# kubectl label:添加label值

kubectl label nodes k8s-node01 zone=north #为指定节点添加标签

kubectl label nodes k8s-node01 zone- #为指定节点删除标签

kubectl label pod podName -n nsName role-name=test #为指定pod添加标签

kubectl label pod podName -n nsName role-name=dev --overwrite #修改lable标签值

kubectl label pod podName -n nsName role-name- #删除lable标签

# kubectl滚动升级; 通过 kubectl apply -f myapp-deployment-v1.yaml 启动deploy

kubectl apply -f myapp-deployment-v2.yaml #通过配置文件滚动升级

kubectl set image deploy/myapp-deployment myapp="registry.cn-beijing.aliyuncs.com/google_registry/myapp:v3" #通过命令滚动升级

kubectl rollout undo deploy/myapp-deployment 或者 kubectl rollout undo deploy myapp-deployment #pod回滚到前一个版本

kubectl rollout undo deploy/myapp-deployment --to-revision=2 #回滚到指定历史版本

# kubectl scale:动态伸缩

kubectl scale deploy myapp-deployment --replicas=5 # 动态伸缩

kubectl scale --replicas=8 -f myapp-deployment-v2.yaml #动态伸缩【根据资源类型和名称伸缩,其他配置「如:镜像版本不同」不生效】

2. etcdctl 命令

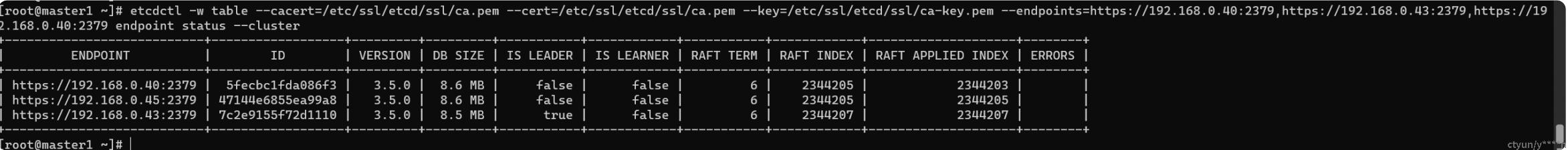

2.1. 查看集群状态

etcdctl -w table --cacert=/etc/ssl/etcd/ssl/ca.pem --cert=/etc/ssl/etcd/ssl/ca.pem --key=/etc/ssl/etcd/ssl/ca-key.pem --endpoints=h(体体)ps://{{ master1_ip }}:2379,h(体体)ps://{{ master2_ip }}:2379,h(体体)ps://{{ master3_ip }}:2379 endpoint status --cluster

2.2. 查看集群节点健康状态

etcdctl -w table --cacert=/etc/ssl/etcd/ssl/ca.pem --cert=/etc/ssl/etcd/ssl/ca.pem --key=/etc/ssl/etcd/ssl/ca-key.pem --endpoints=h(体体)ps://{{ master1_ip }}:2379,h(体体)ps://{{ master2_ip }}:2379,h(体体)ps://{{ master3_ip }}:2379 endpoint health

2.3. 转让etcd leader

模板:将etcd leader从master2(192.168.0.43)转让到master1

第一步:获取etcd leader所在节点的ip

etcdctl --cacert=/etc/ssl/etcd/ssl/ca.pem --cert=/etc/ssl/etcd/ssl/ca.pem --key=/etc/ssl/etcd/ssl/ca-key.pem --endpoints=h(体体)ps://{{ master1_ip }}:2379,h(体体)ps//{{ master2_ip }}:2379,h(体体)ps://{{ master3_ip }}:2379 endpoint status --cluster | grep true | awk '{print $1}' | rev | cut -c 2- | rev

得到:etcd leader所在节点master的h(体体)ps//{{ master2_ip }}:2379

第二步:获取要获得etcd leader的节点id

etcdctl --cacert=/etc/ssl/etcd/ssl/ca.pem --cert=/etc/ssl/etcd/ssl/ca.pem --key=/etc/ssl/etcd/ssl/ca-key.pem --endpoints=h(体体)ps//{{ master1_ip }}:2379h(体体)ps://{{ master2_ip }}:2379,h(体体)ps//{{ master3_ip }}:2379 endpoint status --cluster | grep 192.168.0.40 | awk '{print $2}' | rev | cut -c 2- | rev

得到:5fecbc1fda086f3

第三步:转让

etcdctl --cacert=/etc/ssl/etcd/ssl/ca.pem --cert=/etc/ssl/etcd/ssl/ca.pem --key=/etc/ssl/etcd/ssl/ca-key.pem --endpoints=h(体体)ps//{{ master2_ip }}:2379 move-leader 5fecbc1fda086f3