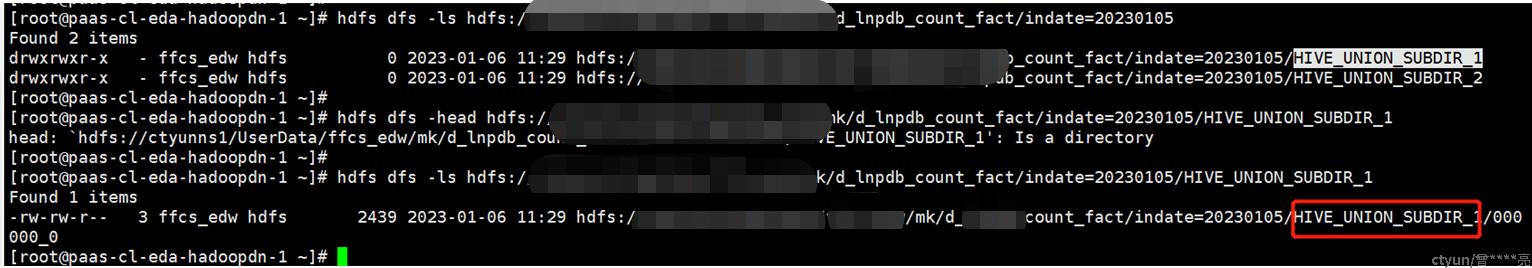

用户反馈相同一条SQL tez查询有结果,但是使用spark-sql查询没有结果,经过分析发现这个表下的分区有子目录如下,多了一层HIVE_UNION_SUBDIR_1目录。

多这个目录的原因是tez引擎使用union all时会生成一个子目录HIVE_UNION_SUBDIR_1,避免数据错乱,针对这个问题有以下解决办法

一、源头不用tez引擎,换成hive或者spark-sql

二、使用tez引擎写数据解决办法 :1、union all插表结束之后,再做一次自表插入;2、在ql最后面增加distribute by, 强制触发一次reduce过程

三、查询时引擎解决办法:1、mr在SQL前面增加参数set hive.mapred.supports.subdirectories=true; set mapred.input.dir.recursive=true;2、spark-sql增加参数--conf spark.sql.hive.convertMetastoreOrc=false --conf spark.hadoop.mapred.input.dir.recursive=true