围绕BERT的引入出现了一个社会学拐点。在2019年之前,语言模型的自监督学习本质上是NLP的子领域,它与NLP其他方面的发展并行推进。2019年之后,使用语言模型的自监督学习更多地成为NLP的基质,因为使用BERT已成为常态。对于单个模型可用于如此广泛任务的接受标志着基础模型时代的开始。基础模型导致了前所未有的同质化水平:几乎所有最先进的NLP模型现在都源自少数基础模型之一,例如BERT、RoBERTa、BART、T5等。虽然这种同质化产生了极高的影响力(基础模型的任何改进都可以为所有NLP任务带来直接的好处),但它也是一种负担;所有人工智能系统都可能继承一些与基础模型相同的错误偏置伦理的讨论。我们也开始看到跨研究社区的同质化。

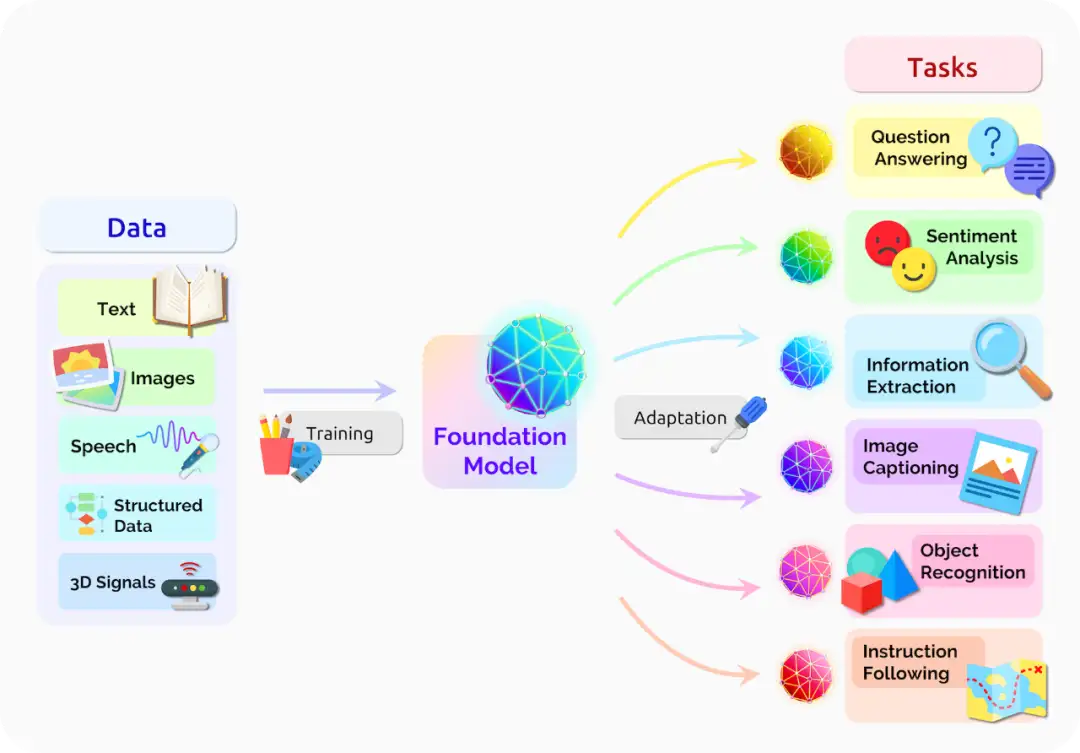

上图展示了基础模型可以集中来自各种模态的所有数据的信息,然后这个统一模型可以适配各种下游任务。

基础模型通过(巨大的)规模也产生了令人惊异的涌现效果。例如,与GPT-2的15亿个参数相比,GPT-3有1750亿个参数,并可以进行语境学习。通过向其语言模型提供提示(prompt)(一条对任务的自然语言描述)就可以让其适配下游任务。这种提示是一种既没有经过专门训练也不被期望在数据中出现的涌现属性。

基础模型已经展示了初步潜力,但我们仍处于早期阶段。尽管它们被部署到现实世界中,但这些模型在很大程度上还是研究原型,人们对其知之甚少。甚至围绕基础模型的专业规范—罗伯特·默顿所说的科学精神[Merton 1979]—也不发达。例如,在诸如模型何时“安全”发布或社区应如何应对某些不当方法等基本问题上缺乏共识。鉴于基础模型的未来充满不确定性,一个大问题是:谁来决定这个未来?

学科多样性 基础模型背后的技术基于机器学习、优化、NLP、计算机视觉和其他领域数十年的研究。这些技术贡献来自学术界和工业界的研究实验室。然而,构建基础模型本身的研究几乎只发生在工业界—谷歌、Facebook、微软或华为等大型科技公司,或OpenAI、AI21 Labs等初创公司,尽管AI2是一个明显的例外。

激励 基础模型的设计、开发和部署阶段带来的政治经济学效应为每个阶段的决策提供了不可避免的激励结构。人们和机构如何对激励做出反应是经济学的基本课程。市场驱动的商业激励可以很好地与社会效益保持一致:在搜索各种潜在用例的同时,使基础模型更加准确、可靠、安全和高效,可以产生大量的社会效用。然而,商业激励也可能导致市场失活和在股东无法获得创新价值的领域投资不足的问题。

可访问性的丧失 不幸的是,由于可访问性的丧失,学术界无法充分参与其中。深度学习革命经常被忽视的影响之一是可复现性和开放科学的增加:公开发布代码和数据集越来越成为常态,诸如TensorFlow 、PyTorch等工具包使人们更容易协同合作以及构建各自的模型。

基础模型开始逆转这一积极趋势。某些模型(例如GPT-3)根本不会公开发布(只对少数人提供API访问权限)。甚至一些数据集(例如GPT-2)也没有公开发布。虽然可以使用经过训练的模型(例如BERT),但由于计算成本过高且工程要求复杂,绝大多数AI研究人员实际上无法对基础模型进行完整的训练。

总结 目前存在巨大的经济激励来推动基础模型能力和规模的提升,因此可以预计未来几年相关技术会稳步发展。但是,一项主要依赖涌现的行为的技术是否适合广泛部署给民众目前尚不清楚。能够清楚的是我们需要谨慎行事,并且现在应着手建立专业规范,这将使可靠的基础模型研究和部署成为可能。学术界和工业界需要在此方面进行合作:工业界会就最终如何部署基础模型做出具体决策,但鉴于学术界的学科多样性以及注重知识生产和社会效益的非商业激励性,我们也应该依靠其为基础模型的开发和部署提供独特的指导,这在技术方面和伦理方面都是有根据的。