1、背景技术

受新冠肺炎疫情影响,全球经济增速放缓,数字经济发展迎来契机。其中,以AI为代表的技术大量应用在智慧医疗、病人护理、体温检测等领域,在疫情防控中大展身手。疫情防控常态化之后,AI扩展到了更多工作领域,如食堂刷脸消费、门禁系统等。

中国电信天翼云自主研发的大数据PaaS平台——诸葛AI平台,目前已经汇聚了200多个资源算法,130个基础算子,300多个专题模型以及350个行业模型,在行业中已经处于领先地位。但5G的到来,万物互联走向万物智联,需要精确度更高的预测算法进一步发挥作用。

天翼云生产环境的数据大多呈现出不平衡的特性,目前不平衡数据的二分类预测算法主要有决策树(C4.5)、 逻辑回归(Logistics Regression,LR)、支持向量机(Support Vector Machine,SVM)、代价敏感随机森林(Cost Sensitive Random Forest,CSRF)、XGBoost 等。其中CSRF因有较高的准确度和AUC值被大量的用于非平衡数据分类问题中,但其也存在不足。

目前CSRF主要存在以下两点不足:

- 不考虑样本数据实际分布情况

构造的代价敏感函数没有将样本数据的实际分布情况纳入考虑范畴;且在代价因子构造的过程中,不区别对待数据特征,并利用欧式距离计算公式计算数据样本之间的距离,这可能会导致算法忽略重要的数据特征。在实际的二分类问题中,预测模型基于的数据集一般由多个特征组成,且同一个特征对“是”和“否”这两个类别的重要程度不相同,若代价函数仅通过欧式距离确定样本之间的距离,这会导致构造的代价函数对重要特征不公平,无法保证所构代价的准确性,从而使CSL方法的性能得不到保证,最终造成预测模型整体性能较差。

- CART决策树基于的实验数据集的非平衡程度不同

传统的CSRF算法使用的基分类器是CART决策树,而构建CART决策树所基于的数据集是随机产生的,即这些数据集的非平衡程度不同。这就导致由这些数据集训练出的基础决策树的预测能力是有差异的。但在最终投票阶段,采取的是少数服从多数的投票方式,并没有考虑决策树分类性能的差异,这会影响预测模型的整体预测性能。但从理论上讲,正确率较高的决策树应该具有较高的权重,反之应该被赋予较低的权重或者零权重。而实际的二分类需求中,预测模型整体预测性能较优是很有必要的。

现阶段,基于非平衡数据的代价敏感随机森林算法改进很少,且大部分都是对采样方法进行改进,如通过多次聚类以及对聚类结果进行分组,获取类别内部子类的结构特征,提高分类的精度。

万物互联时代,事物瞬息万变,有些事物的变化可能会给我们的经济、社会治安等带来严重的影响,我们需要更高精准度的预测算法去预测这些可能造成不良影响事物。因此,对现有预测算法做出改进,提高其精准度是很有必要的。

2、本文目的

针对生产环境真实数据的非平衡性,将样本实际分布与特征权重纳入考虑,并在基础决策树分类器组合时,通过OOB(out-of-bag)数据集计算每棵决策树预测的错误率,以此错误率为依据赋予每棵决策树不同的投票权重,从而提高分类器整体预测性能,弥补CSRF算法的不足。

3、技术方案

一种基于不平衡数据改进的代价敏感随机森林预测方法,包括以下步骤:

步骤1:数据收集

中国电信天翼云诸葛AI平台应用范围较为广泛。本发明以生产上实际的某一场景的用户交易数据为实验数据集,针对某一产品,将这些用户划分为“是”购买该产品和“否”购买该产品两类为实验目的。

步骤2:数据预处理

收集到的实验数据具有重要字段数据缺失、数据存储类型多为类别或者字符型等特点。因此本发明需要对收集到的实验源数据进行缺失值处理、数据规范化等预处理操作。

步骤2.1:缺失值处理

对于类别型变量,本发明直接将缺失率超过百分之50的标签删除,将不超过百分之50的变量中的缺失作为一种新的状态,用-1对缺失值进行填充。

步骤2.2:数据规范化

数据规范化指的是将数据按照比例进行缩放,使之落入一个特定的区域,从而消除指标之间取值范围差异的影响。通常通过编码、连续变量离散化处理等方法进行数据的规范化。本发明规范化规则如下:

- 针对某一新产品,将发生过交易的客户标记为1,将未发生过交易的客户标记为0。

- 对二分类属性进行0-1编码。

- 对无序分类属性进行哑变量编码。

- 将字符串类型数据转换为整数或者浮点数。

- 将平均数、中位数、百分之 75 分位数远小(大)于最大(小)值的数值特征,通过 K-Means 聚类算法进行离散化处理。

- 将数值型特征用最大最小标准化方法对数据进行标准 化,该方法会对原始数据进行线性变换使之映射到[0,1]区间内,其计算公如

下:

其中,y是样本数据变换之后的数据,max是样本数据最大值,

min是样本数据的最小值。

步骤3:特征数据处理

步骤3.1:特征衍生

为了进一步提升预测模型的性能,本发明通过特征衍生的方式在原始数据特征的基础上派生出新的特征以此来增加特征的数量。如可从时间维度、客户交易信息、客户余额信息等数据的基础上进行特征衍生,衍生出“本月比上月账户余额差”等特征,帮助二分类算法进行二分类。

步骤3.2:特征筛选

经过初步的数据收集和特征衍生,本发明进行预测的实验数据的维度达到了58维,即实验数据集共有58个数据特征。由于当数据维度过大时模型的训练时间呈指数级增长,而这些数据特征中有很多与模型预测不相关的特征,所以需要进行特征筛选。本发明通过方差选择法、IV值筛选和KS检验法对原始实验数据进行特征筛选,从而减少数据的维度。

- 方差选择法:方差选择法指的是对实验数据的各个特征的方差进行计算,然后根据设定的某一阈值将方差低于阈值的特征舍弃。本发明制定的阈值为1,当特征的方差接近0时,表明该特征对样本没有预测能力。

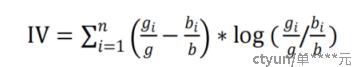

- IV 值筛选法:IV(Information Value)即信息价值指标,主要用以判别二分类问题中数据特征的区分能力。IV值一般不适合对连续型变量进行分析,一般应用在离散型变量中,当在分析连续型变量时需要先对变量进行分箱操作然后再进行IV计算。IV值计算公式如下:

其中,n表示该变量的类别数,表示该变量的第i种类别对应的

正类样本数,g表示正类样本的总数,表示该变量的第i种类别对应的负样本数,b表示负类样本的总数。IV值越大代表该特征的分布有较大的差异性,有较好的区分能力。若IV值过大,则需要注意将该特征加入模型中会发生过拟合的情况。

若 IV 值小于 0.02 时表明,该特征几乎没有预测能力,本发明将IV值小于 0.02 的变量进行舍弃。

- KS 检验:KS(Kolmogorov-Smirnov)常用于检验一个分布是否符合某种理论分布或 比较两个经验分布是否有显著差异,也被用于评估模型或者特征区分能力。KS是基于累计分布函数的,KS指标越大,代表正负类样本的累计差异越大,特征的区分能力越强。一般情况,当KS值大于2时,表明该特征有较好的预测能力。经过实验分析,本发明将KS值小于0.1的特征进行舍弃。

本发明综合使用了上述三种筛选方法,即先用方差选择法对样

本作初始筛选,对筛选后的结果再用 IV值筛选法和KS检验法作进一步的筛选。

经过特征衍生和特征筛选后,本发明最终选取了25维特征构建预

测模型。经过特征筛选,可以剔除冗余特征和噪声特征,能够提高模型计算性能。

步骤4:模型参数设定

ICSRF模型在做数据二分类处理时,主要涉及n_estimators 、 max_depth 、 min_samples_split 以及 max_features 这四个参数。为了提高模型的整体效果,经过多次实验分析,本发明采用经验法和交叉验证法确定参数训练 ICSRF 模型,模型参数如下表。

|

参数名 |

参数含义 |

参数取值 |

|

n_estimators |

基础决策树个数 |

100 |

|

max_depth |

基础决策树深度 |

13 |

|

min_samples_split |

向下继续分支的最小样本数 |

100 |

|

max_features |

每棵树使用的特征数 |

log2 |

步骤5:模型评估

模型评价常用的指标有预测精度、准确度、ROC、AUC 和召回率等。

不平衡数据二分类问题中,少数类分类性能的好坏更为重要,而准确率无法合理的展现 模型对少数类的预测性能。但是少数类的查全率,即判别正确的少数类占所有少数类的比 例,可以展现模型对少数类的性能。此外,F1分数因兼容考虑了分类模型的查全率和准确 率,常用来作为非平衡数据分类问题的评价依据。

F1分数可以看作是分类模型查全率和准确率的一种加权平均,F1 分数的取值是 0-1。其计算公式如下。

其中,Precision 代表准确率,Recall 代表查全率。

考虑到本发明研究的是非平衡数据二分类问题,仅准确率这一评价指标无法真正的评价模型性能的好坏,所以本发明选择查全率、ROC_AUC和F1分数作为模型的评价指标,这三个评价指标的值越大,表明分类模型的性能越好。

4、改进优点

- 避免重要数据特征被忽略。传统的代价敏感随机森林算法构造的代价敏感函数没有将样本数据的实际分布情况纳入考虑范畴;且在代价因子构造的过程中,不区别对待数据特征,并利用欧式距离计算公式计算数据样本之间的距离, 这可能会导致算法忽略重要的数据特征。而实际的生产场景中的二分类问题,预测模型基于的数据集大多由多个特征组成,且同一个特征对“是”和“否”这两个类别的重要程度不相同,若代价函数仅通过欧式距离确定样本之间的距离,这会导致构造的代价函数对重要特征不公平,无法保证所构代价的准确性,从而CSL方法的性能得不到保证,最终造成预测模型整体性能较差。本发明在构造代价函数时,将样本的实际分布与特征权重纳入考虑,以保证代价敏感函数对重要特征的公平性,从而提高CSL方法的性能。

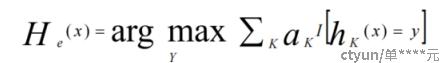

- 提高预测模型整体预测性能。传统的CSRF算法使用的基分类器是CART决策树,而构建CART决策树所基于的数据集是随机产生的,即这些数据集的非平衡程度不同。这就导致由这些数据集训练出的基础决策树的预测能力是有差异的。但在最终投票阶段,采取的是少数服从多数的投票方式,并没有考虑决策树分类性能的差异,这会影响预测模型的整体预测性能。但从理论上讲,正确率较高的决策树应该具有较高的权重,反之应该被赋予较低的权重或者零权重。本发明在基础决策树分类器的组合阶段,将 OOB(out-of-bag)数据作为测试集,计算每棵决策树的错误率,依据错误率赋予每棵决策树以不同的投票权重。权重越大的基础决策树,其错误率越低,在随机森林的最后决策阶段所占的比重越大。最终,改进的CSRF算法的输出如下式。