概述

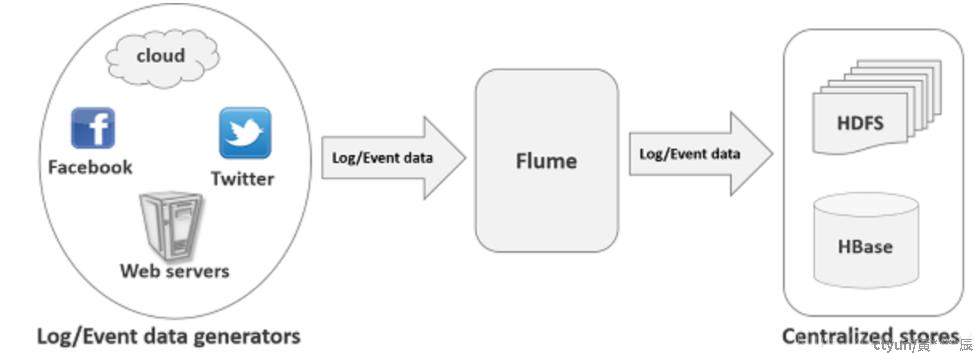

Flume是一个分布式、可靠、和高可用的海量日志采集、聚合和传输的系统。

是可以收集日志、事件等数据资源,并进行整合集中存储的工具/服务。

flume具有高可用,分布式,配置工具,其设计的原理也是基于将数据流,如日志数据从各种网站服务器上汇集起来存储到HDFS,HBase等集中存储器中。官网的数据流程图如下图所示。

特性

Flume可以采集文件,socket数据包、文件、文件夹、kafka等各种形式源数据,又可以将采集到的数据(下沉sink)输出到HDFS、hbase、hive、kafka等众多外部存储系统中

一般的采集需求,通过对flume的简单配置即可实现,flume可以适用于大部分的日常数据采集场景。

原理

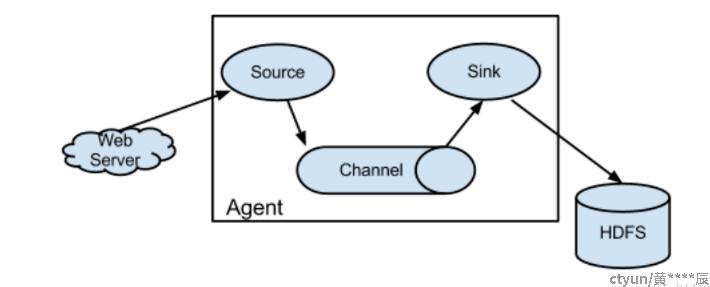

flume核心组件为Agent,对每个Agent,是一个独立的守护进程JVM,从客户端接收数据。

Agent里面包含Source用来与服务器连接获取数据,Channel负责将数据进行传输,Sink下沉组件用于往下一级Agent传递数据,或从最终的存储系统如HDFS传输。

搭建Flume

安装Flume

tar -zxcf apache-flume-/*对应版本*/-bin.tar.gz

mv apache-flume-/*对应版本*/-bin flume配置Flume

进入flume文件夹,修改配置文件flume/conf/flume-env.sh里面的JAVA_HOME

export JAVA_HOME=/usr/local/java/*Java的home文件夹*/根据数据采集的需求配置采集方案,描述在配置文件中,在flume根目录下创建myconf文件夹创建socket-console.conf文件

vim /usr/local/flume/myconf/socket-console.confsocket-console.conf文件内容包括:

# 定义agent a1中各组件的名字

a1.sources = s1

a1.sinks = k1

a1.channels = c1

# 描述和配置source组件:s1

a1.sources.s1.type = netcat

a1.sources.s1.bind = localhost

a1.sources.s1.port = 88888

# 描述和配置sink组件:k1

a1.sinks.k1.type = logger

# 描述和配置channel组件,此处使用是内存缓存的方式

a1.channels.c1.type = memory

a1.channels.c1.capacity = 1000

a1.channels.c1.transactionCapacity = 100

# 描述和配置source channel sink之间的连接关系

a1.sources.s1.channels = c1

a1.sinks.k1.channel = c1启动agent采集数据

[root@hxc]# bin/flume-ng agent -c conf -f myconf/socket-console.conf -n a1 -Dflume.root.logger=INFO,console**-c conf** --> 指定flume自身的配置文件所在目录

**-f myconf/socket-console.conf** --> 指定采集方案

**-n a1** --> 指定agent名字,对应socket-console.conf 中agent节点

测试Flume

利用其他机器连到agent节点上

[root@hxc]#telnet agent-hostname port/和socket-console.conf对应/

[root@hxc]#telnet localhost 88888连接成功后,发送信息通知,查看启动agent采集的机器是否收到数据。